Bước vào năm 2025, thế giới tìm kiếm trực tuyến chứng kiến sự trỗi dậy mạnh mẽ của AI với Google Gemini AI Mode, đồng thời đặt ra thách thức và cơ hội chưa từng có cho mọi cá nhân, doanh nghiệp, marketer, SEOer và cả những người sáng tạo nội dung. Khi những “luật chơi cũ” về search, SEO, content dần bị xoá nhoà, AI đa phương tiện mở ra lời mời nhập cuộc: ai dám đột phá sớm, người đó sẽ giành được lợi thế dẫn đầu. Từ kiến trúc kỹ thuật vượt bậc đến trải nghiệm cá nhân hoá, từ giao diện “chat” trên di động tới bản đồ SEO hội thoại mới, Google Gemini AI Mode không chỉ là công nghệ, mà là một cuộc “cách mạng search” thực sự. Hãy cùng khám phá toàn cảnh tương lai này, hiểu rõ từng điểm đột phá để tự tin chuyển mình và phát triển bền vững trong kỷ nguyên AI!

Google Gemini AI Mode 2025: Toàn Cảnh Cách Mạng Search Đa Phương Tiện & SEO Tương Lai

Mục lục

1. Google Gemini AI Model Architecture: Kiến trúc đột phá mở lối search AI

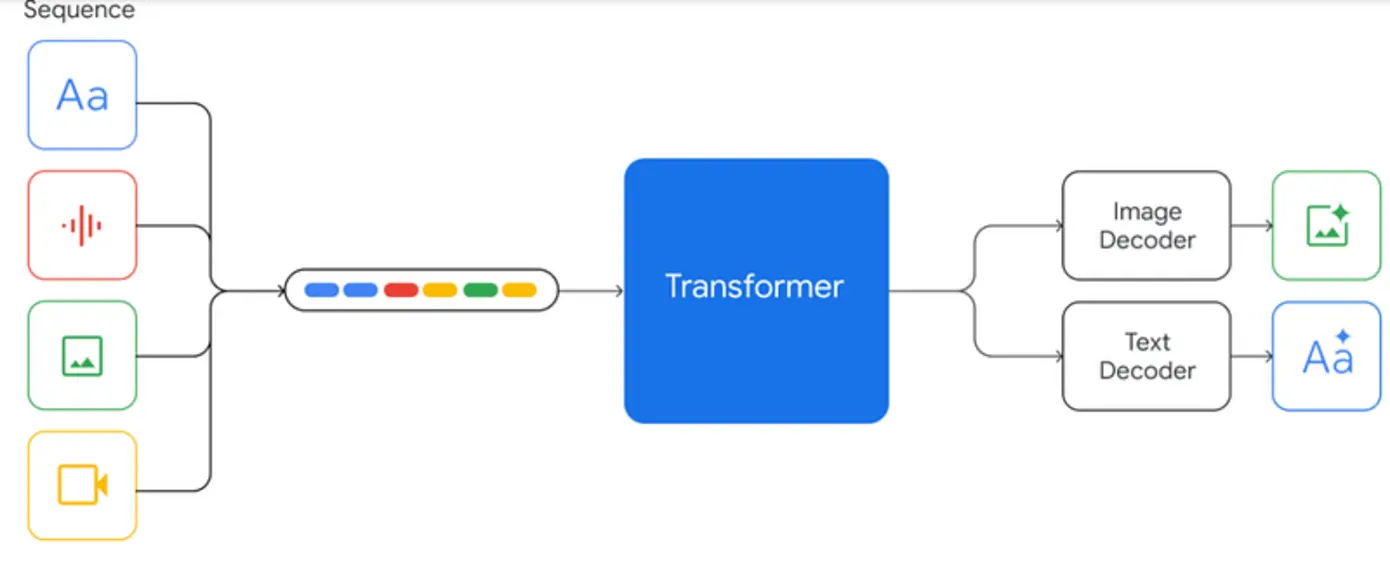

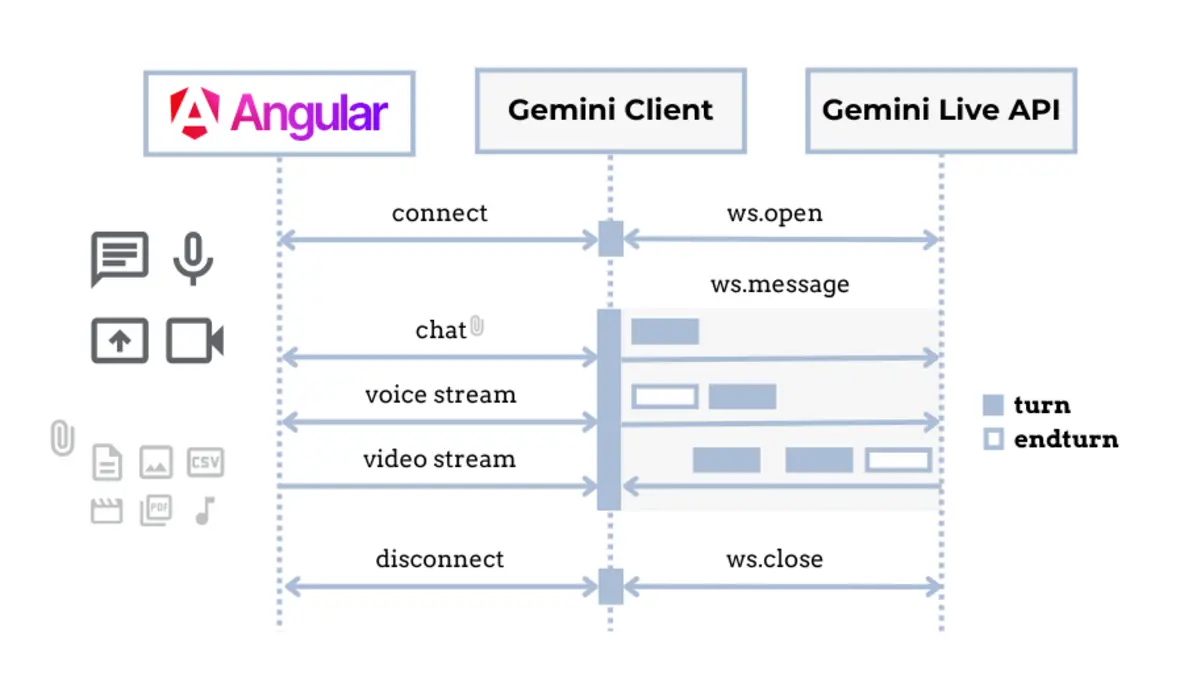

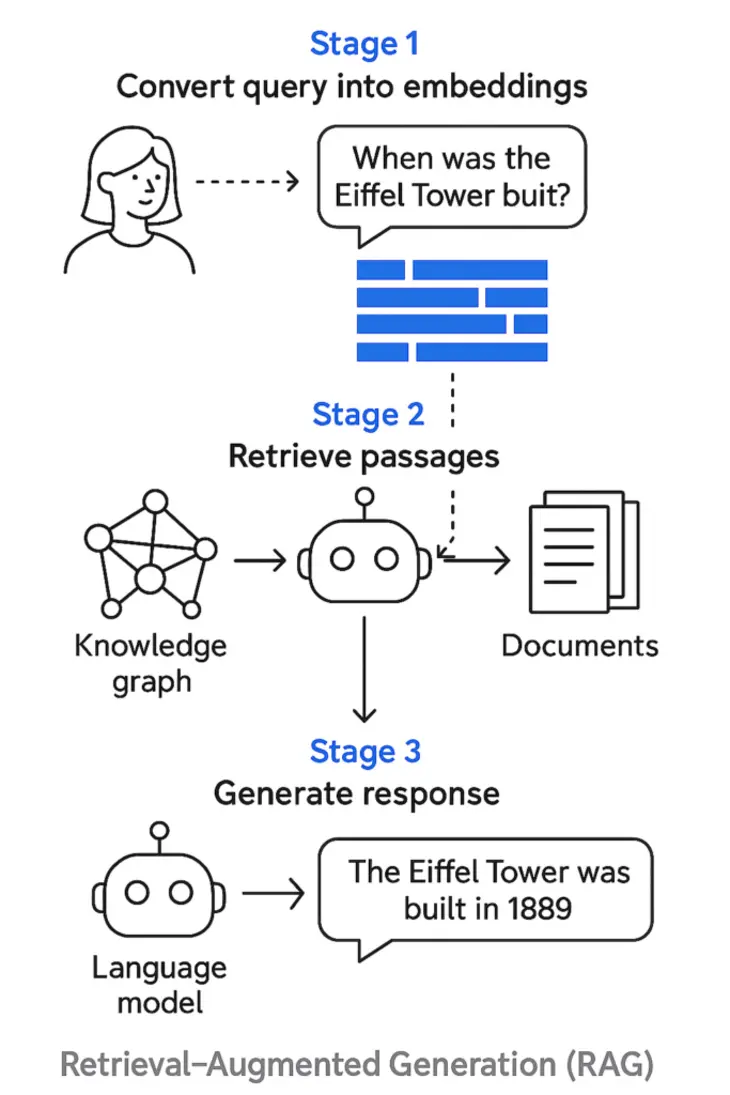

Nếu trước đây, AI trên Google mang lại những kết quả chủ yếu dựa trên văn bản – đọc xong là xong, trả về vài link xanh, mỗi truy vấn như một “câu hỏi đơn điệu”, thì năm 2025, với Gemini AI, mọi thứ đổi khác hoàn toàn. Bạn tưởng tượng nhé: Google không đơn giản kỳ vọng trả lời mà còn “hiểu” bạn thực sự muốn gì, dù input là chữ viết, hình ảnh, âm thanh hay cảm xúc… Đó chính là “thần kinh đa tầng” của Gemini AI, một cấu trúc kỹ thuật tinh vi đã mở ra kỷ nguyên search AI chưa từng có.

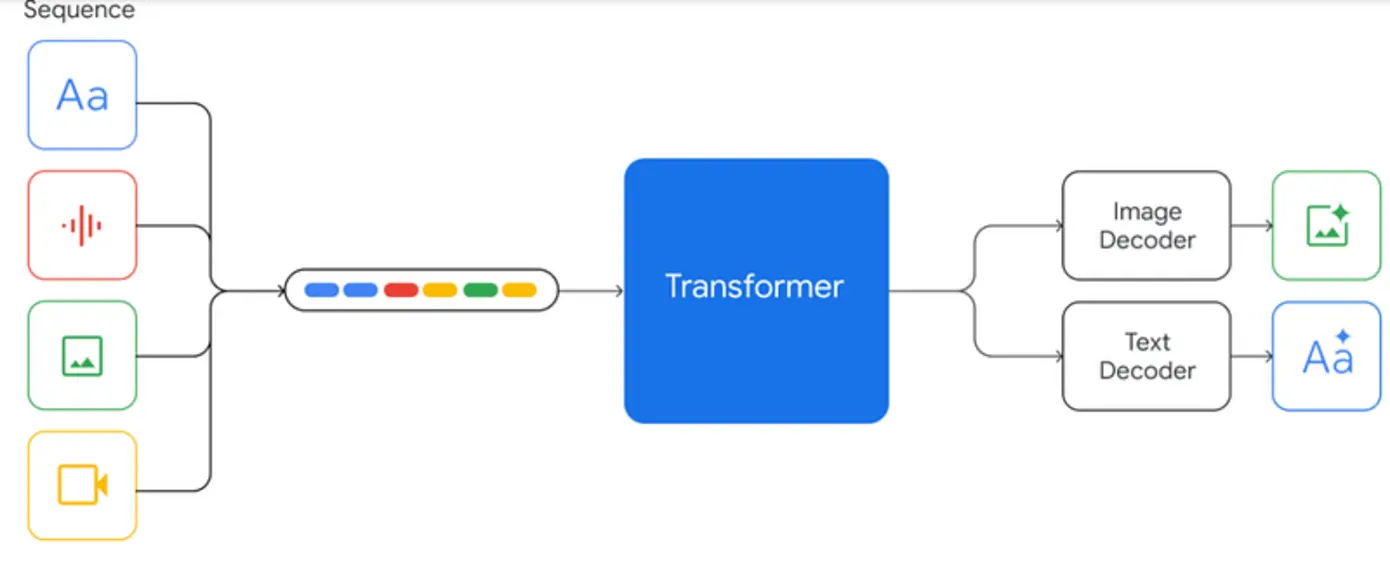

1.1. Đột phá học đa phương tiện – Không Còn Rào Cản Giữa Text, Ảnh, Âm Thanh

Bạn muốn hỏi “Vườn quốc gia nào có thác cao nhất, gửi kèm ảnh selfie nhóm?” Gemini hiểu ngay bạn muốn biết địa điểm, nhận diện bối cảnh ảnh nhóm, trả về thông tin, đường đi, cảnh báo thời tiết và cả gợi ý góc chụp đẹp. Thay vì chia nhỏ câu hỏi như trước, giờ đây AI Gemini “kết nối” trơn tru mọi kiểu dữ liệu: từ văn bản, hình ảnh, file audio đến cảm xúc, mục tiêu. Khi bạn hỏi bằng voice, gửi ảnh – thậm chí chỉ thể hiện bằng cảm xúc, AI vẫn lập tức nhận biết ngữ cảnh, đoán ý định bạn, và dù liên tục chuyển input, cuộc trò chuyện vẫn mượt mà, không ngắt đoạn.

- Kết nối/liên kết mọi nguồn dữ liệu: Text, ảnh, audio tích hợp trong một mạch search.

- Hiểu cấu trúc ý định: Từ những câu hỏi đơn giản đến nhiệm vụ phức tạp nhiều bước.

- Chuyển đổi đa chế độ liền mạch: Bạn hỏi, gửi ảnh, voice hoặc nhập liệu kiểu nào cũng nhận một dòng kết quả thống nhất, hợp ngữ cảnh.

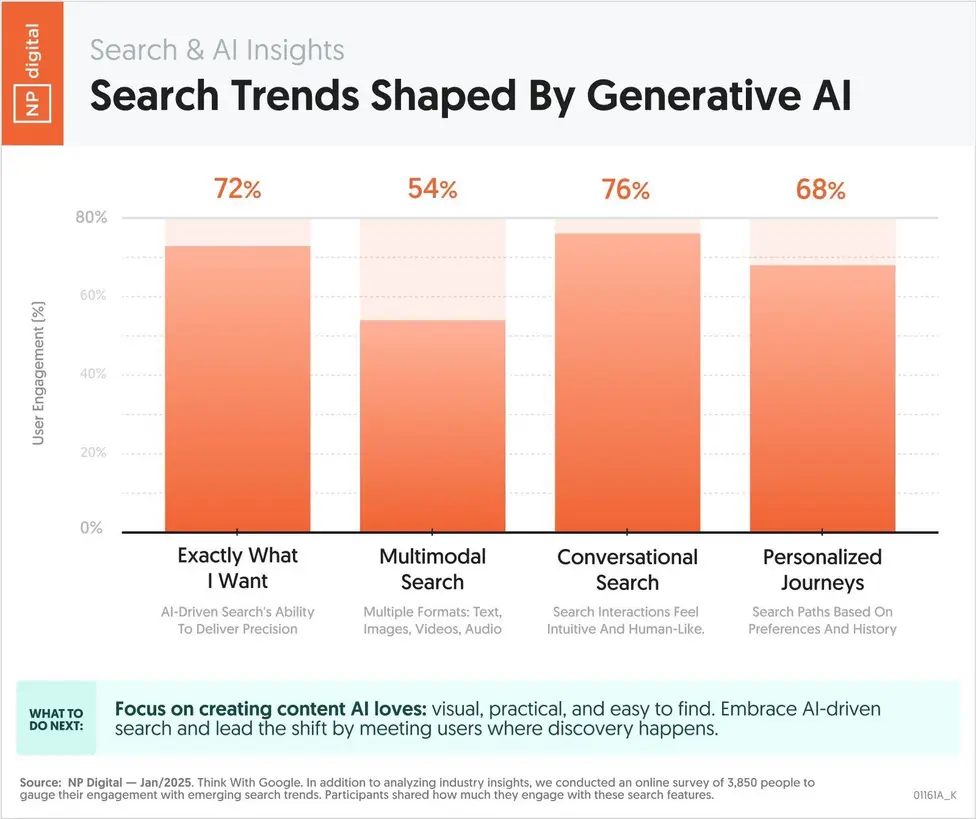

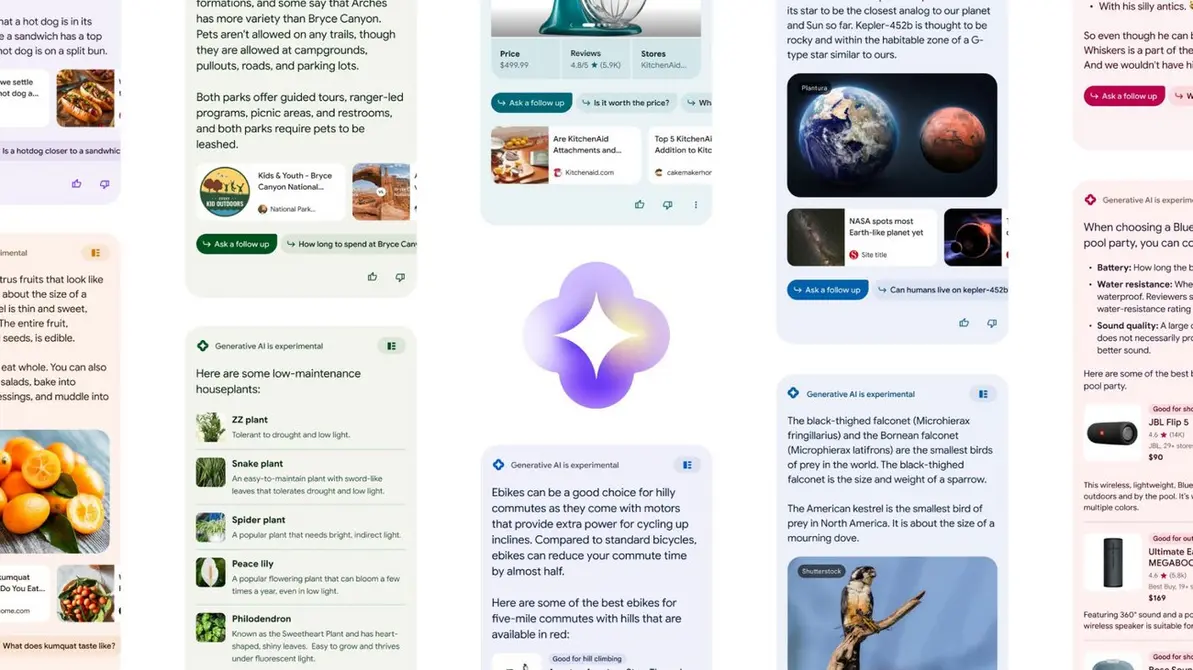

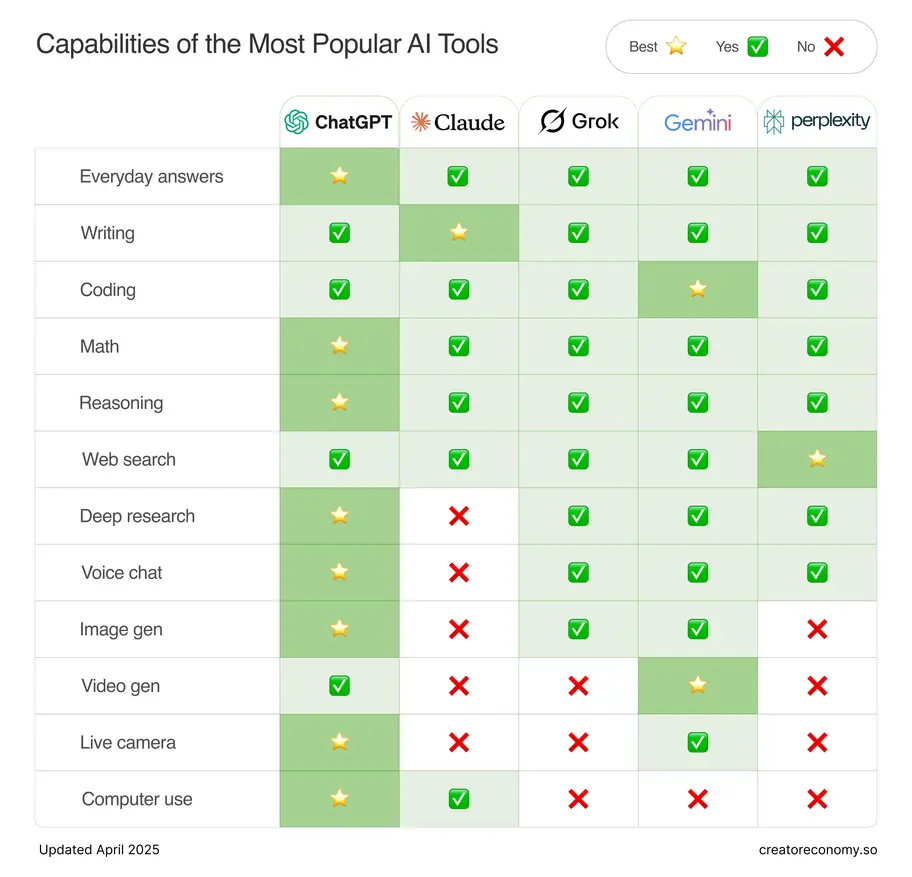

Minh họa về kiến trúc Gemini AI: Mô hình thần kinh đa tầng, học sâu qua dữ liệu đa dạng, phân tích toàn diện ngữ cảnh và tối ưu để trả kết quả chuẩn xác cho search hiện đại.

1.2. Sức mạnh bứt phá – Khi AI Biết “Tự Suy Luận” Và “Dẫn Dắt” Cuộc Search

Hãy thử nhớ lại: trước đây bạn nhập keyword, đa phần Google chỉ liệt kê link, bài báo hay video xếp hạng. Với Gemini AI, đừng ngạc nhiên nếu mỗi câu hỏi bạn dần trở thành một cuộc trò chuyện “hỏi đáp liên tục” chứ không chỉ là danh sách result dài dòng.

- AI không chỉ “trả bài”, mà “dẫn dắt” logic; nếu bạn hỏi về du học Canada, AI không chỉ trả mức học phí mà sẽ gợi mở “học bổng nào hợp lý, lộ trình nộp hồ sơ, nhà trọ gần trường…”.

- Tích hợp real-time data: AI cập nhật tức thì xu hướng thị trường, giá sản phẩm, review thật, dữ liệu chuyên sâu từ các nguồn uy tín – bạn chỉ việc tiếp tục hỏi tiếp!

- Lưu vết hành vi: Dần dần, Gemini học từ từng lượt search, ưu tiên những nội dung phù hợp sở thích, lĩnh vực hay giải đáp bạn quan tâm.

1.3. Trải nghiệm vượt chuẩn – Nền Tảng SEO & Marketing Phải “Chạy Bộ Theo”!

Tốc độ phản hồi cực nhanh, kết quả logic chặt, trả lời sâu mà còn cực kỳ cá nhân hóa. Đây chính là “chìa khóa vàng” cho SEO, content marketing 2025: Hiểu tận gốc Gemini AI không còn là “nghiên cứu cho vui” mà trở thành nền tảng thành công bắt buộc, giúp bạn xây dựng chiến lược content, tối ưu media, tạo hành trình user hybrid (đa chế độ – đa kênh) chuẩn chỉ. Một yếu tố nhỏ cũng có thể biến site của bạn thành “bài mẫu” mà AI Mode sẽ đề xuất đầu tiên cho hàng triệu người dùng mỗi ngày.

=> Đọc đến đây, bạn đã nắm được: Tại sao kiến trúc Gemini AI không chỉ mạnh hơn mà còn thông minh “thật sự”, vì nó kết nối dữ liệu, hiểu ý định, phản hồi phong phú trên mọi nền tảng? Đây sẽ là gốc rễ lật lại mọi luật SEO – content – trải nghiệm số trong tương lai.

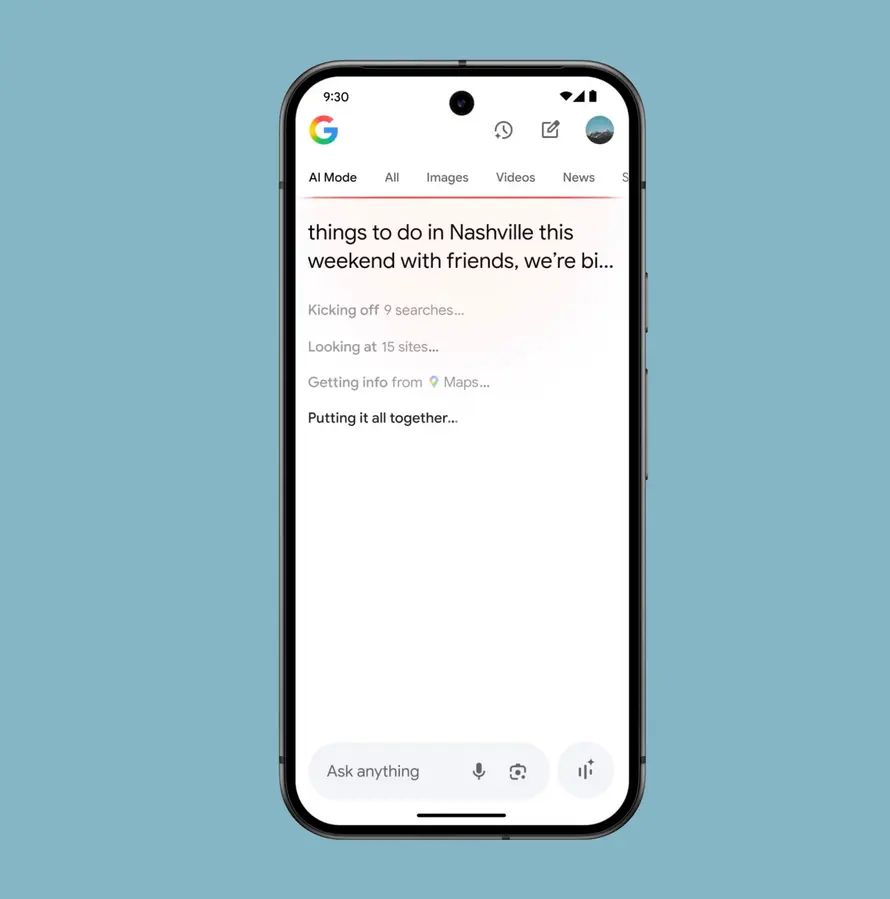

2. Google AI Mode Interface on Mobile: Cách AI Mode “trao quyền” cá nhân hóa trên thiết bị di động

Bạn từng thấy “tìm kiếm” trên di động chỉ là trải nghiệm nhỏ, phụ thuộc vào bàn phím tí xíu, nhập từng cụm từ một cách chậm chạp? Hãy chuẩn bị tinh thần cho bước nhảy mới: Google AI Mode trên mobile biến mỗi chiếc smartphone trở thành “cỗ máy AI đa phương tiện” trong lòng bàn tay bạn!

2.1. Giao diện di động tối ưu – Mở Khóa Quyền Năng AI Cho Mỗi Người

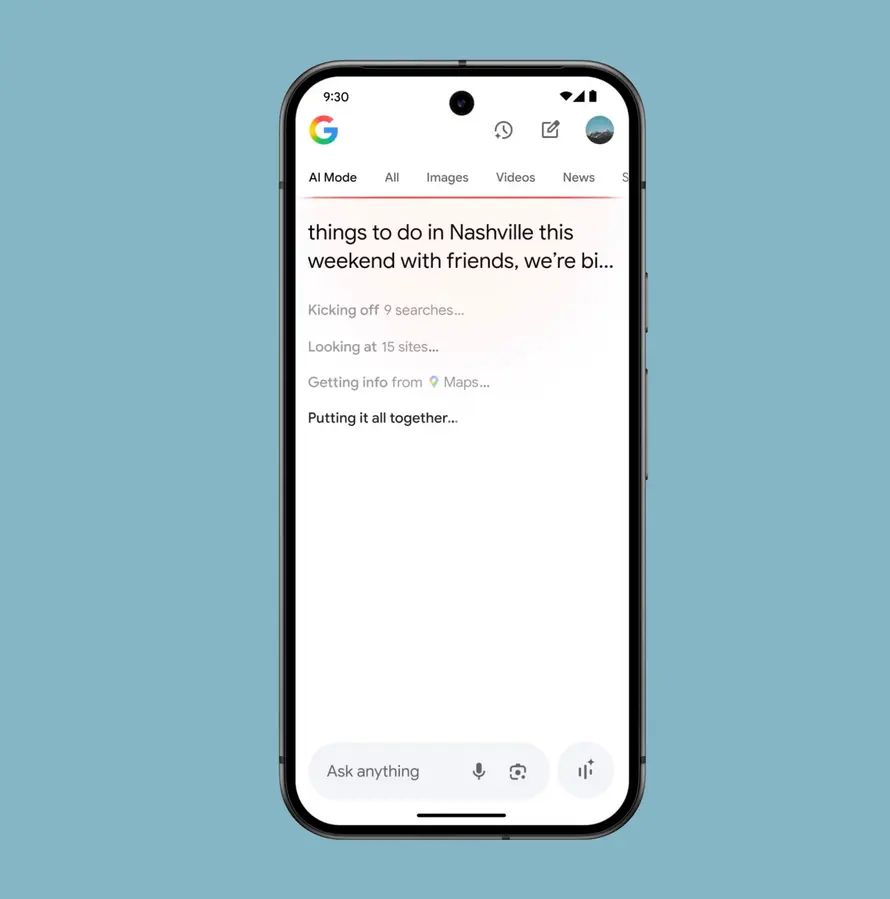

Tưởng tượng buổi sáng bạn muốn tìm nơi cà phê yên tĩnh, gửi một văn bản “quán đẹp, có điều hòa, cần wifi ổn, view xanh, giá hợp lý,” kèm theo một vài tấm ảnh “mood” bạn thích. AI Mode lập tức phản hồi: danh sách quán, kèm review, bản đồ, còn gợi ý cả ưu đãi/khuyến mãi tại cửa hàng gần chỗ bạn nhất. Giao diện cho phép bạn xem hình, data, so sánh giá, đọc nhận xét chỉ bằng cú vuốt đơn giản.

- Tích hợp mọi kiểu dữ liệu: text, ảnh, location, bản ghi âm…

- Giao diện đẹp, dễ dùng, tránh rối mắt, tập trung thông tin “trúng điểm đau” của người dùng.

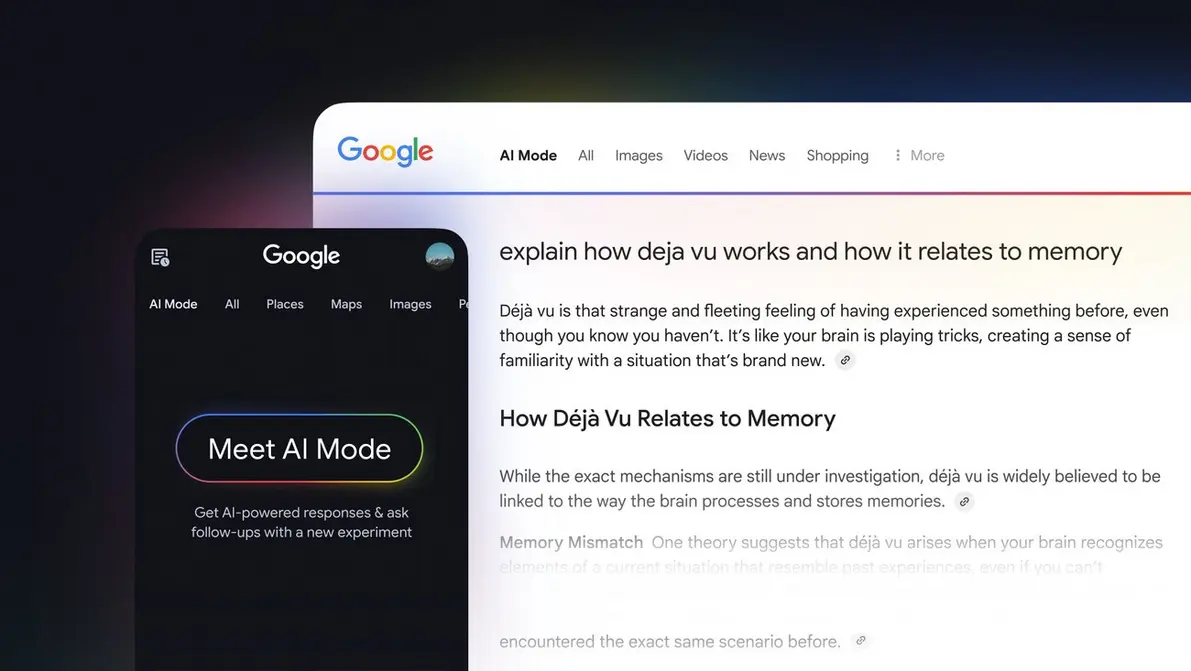

Ảnh chụp giao diện Google AI Mode trên điện thoại: Search giờ đây là tổng hòa giữa hình ảnh, nội dung đậm cá nhân và hội thoại đa chiều cùng AI.

2.2. Đột Phá Thực Sự: Multimodal + Conversational + Personalization

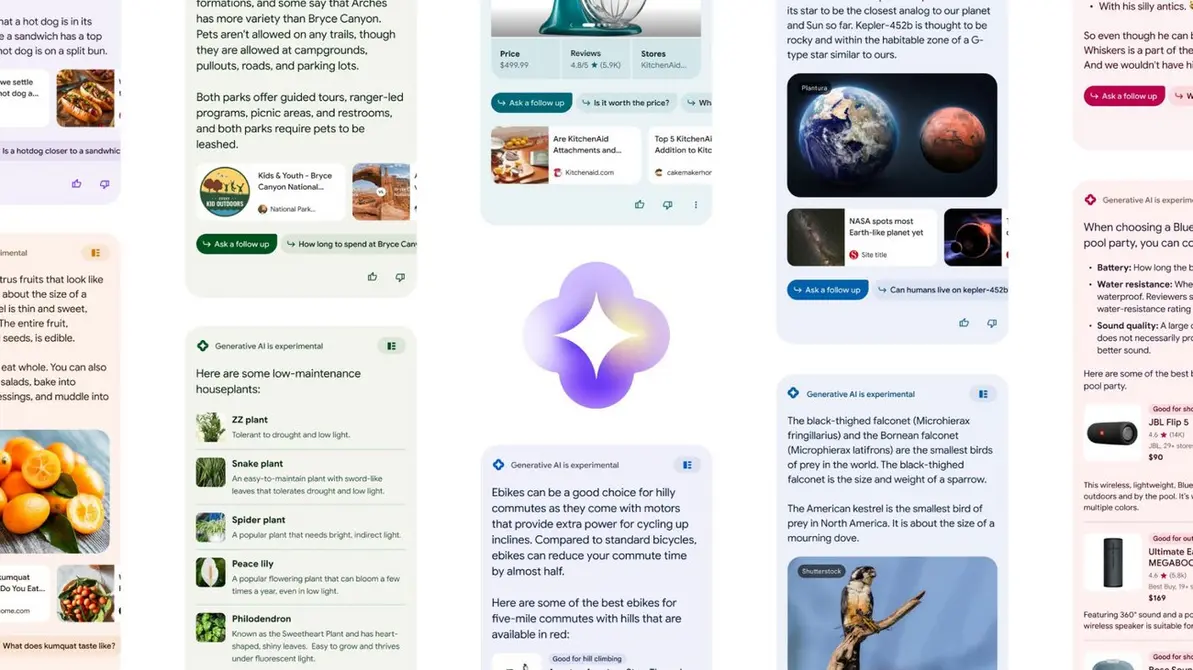

- Phản hồi đa phương tiện: Khi bạn hỏi về các mẫu giày thể thao bền, AI trả về bộ lọc ảnh, bảng giá, review, địa chỉ shop, biểu đồ so sánh chất lượng, tất cả “trên một màn”.

- Tương tác hội thoại: Bạn hỏi tiếp “màu nào hợp châu Á?”, “sale lớn nhất tuần này ở đâu?”, AI tiếp tục trả lời chuẩn xác mà không lạc context.

- Nhận biết thói quen – ngữ cảnh cực mạnh: Dựa trên lịch sử search, vị trí, các thao tác trước đó, AI Mode custom kết quả, giúp mỗi hành trình “rất riêng” cho từng người.

- Nhập liệu linh hoạt: Chạm, nhập chữ, đọc lên, gửi ảnh, dán video – mọi thao tác đều được AI “hiểu” nhanh và chính xác!

2.3. Lợi Ích Cụ Thể Cho Cá Nhân & Doanh Nghiệp

Người dùng: Search kiểu cách “chat”, hỏi gì cũng được, không phải ngại “dùng sai cú pháp” như trước. Kết quả có chiều sâu, tốc độ nhanh, loại bỏ rối thông tin.

Doanh nghiệp/SEO/Marketer: Thời của content “chỉ toàn chữ” đã qua lâu! Bạn phải xây dựng story bằng hình, video, bảng số liệu, giới thiệu đội ngũ chuyên gia, thêm các trích dẫn thực tế, tối ưu dữ liệu cấu trúc… để AI xu hướng “ưu ái” đề xuất thành quả của bạn cho user.

Theo Google, nội dung tích hợp trong search AI Mode giúp tăng tới 30% engagement và time-on-site so với search truyền thống.

=> Bài học rút ra: Nếu bạn muốn nội dung số (website, ứng dụng) của mình nổi bật trên mobile AI Mode, hãy sáng tạo mạnh mẽ hơn ở đa phương tiện và tinh chỉnh trải nghiệm “gần gũi” với từng user!

3. AI Enhanced Search Experience: Hành trình trải nghiệm người dùng được chuyển hóa ra sao?

Nếu hỏi bất kỳ ai đã từng dùng Google AI Mode, bạn sẽ nghe chia sẻ rất chân thực: “Search không còn là copy-paste cụm từ, đọc 10 link rồi tự tổng hợp nữa – mà giống như có một ‘người bạn AI’ đồng hành, liên tục trò chuyện, phản hồi chính xác những thứ mình thực sự tìm kiếm.”

3.1. Trải Nghiệm Đa Kênh – Phản Hồi Theo Ngữ Cảnh, Niềm Vui Săn Thông Tin

Giả sử bạn chuẩn bị đi du lịch Sapa, hỏi “điểm trekking nào gần thác nước, có thể chụp ảnh nhóm đẹp, tránh đông người?”. Kết quả hiện lên: bản đồ tương tác, bộ ảnh 360 độ, nhận xét thật, dữ liệu thời tiết cập nhật liên tục, video đánh giá… Bạn gõ tiếp “có chỗ nghỉ cho nhóm gia đình không?”, AI Mode không chỉ trả lời mà còn đề xuất thêm các tiện nghi phù hợp với nhóm tuổi, ngân sách v.v… Không chỉ text, dòng hội thoại có thể tiếp tục qua ảnh, voice, emoji…

Cùng nhìn giao diện search AI Mode trên web: tổng hợp dữ liệu, hình ảnh, thông tin thời sự, bảng biểu cá nhân hóa, tạo hành trình hội thoại chủ động nhiều bước.

3.2. Tương Tác “Dòng Chảy” – Truy Vấn Không Bị Đứt Gãy

- AI Mode tự động “nhớ” lịch sử search của bạn – cả vị trí, thời gian, việc bạn thích hỏi điều gì, từ đó tối ưu hóa mọi trải nghiệm.

- Kết quả search gửi đến giờ đây không còn chỉ là danh sách link xanh, mà là bảng tổng hợp content sinh động: có thể mua hàng, đặt vé, chia sẻ, hoặc lưu lại tiện lợi.

Ví dụ: Bạn search “mua áo khoác chống nước tặng bạn nữ, cần size S, ship nội thành HCM, phân tích chất liệu tốt nhất hiện tại”. Ngay tức thì, AI Mode trả về loạt kết quả từ so sánh giá, video review thật, bảng phân tích chất liệu, cửa hàng gần bạn nhất, cùng đề xuất phối đồ…

3.3. Giá Trị Đo Lường Rõ Rệt

- Thời gian tìm kiếm đạt mục tiêu giảm 30% (theo báo cáo thực nghiệm nội bộ Google trước khi công bố Gemini).

- Tỉ lệ satisfaction – mức độ hài lòng với kết quả tăng vọt đến 40%, nhờ trả lời chủ động, đa dạng, dễ thao tác và cá nhân.

- Lượng chuyển đổi (conversion) tăng mạnh bởi người dùng không chỉ “ngó” mà thực sự click, mua hàng hoặc gửi yêu cầu ngay trong hành trình tìm kiếm đa phương tiện.

Thử nghĩ, nếu bạn là doanh nghiệp, liệu có dám bỏ lỡ một nền tảng search đã thay đổi hành vi khách hàng như thế này không? Đã đến lúc chúng ta chủ động test các từ khóa liên quan hành vi, hội thoại, sản phẩm, dịch vụ trên AI Mode – rồi tự mình cảm nhận sự khác biệt để lên kế hoạch marketing/SEO đúng chuẩn AI!

Thành thật mà nói, “SEO keyword, backlink, traffic ảo” đã lỗi thời khi Google AI Mode trở thành công cụ “lọc” thông tin theo ngữ cảnh từng cá nhân. Vậy SEO 2025 chuyển hóa ra sao trong kỷ nguyên AI đa phương tiện này? Mọi thứ bắt đầu lại từ… Ý định người dùng!

4.1. “Ý Định & Ngữ Cảnh” – Khởi Điểm Của Mọi Tối Ưu

- AI giờ đây nắm chắc: Bạn muốn kiểu thông tin nào, cần thêm nguồn dẫn ra quyết định, hay đòi hỏi sự so sánh đa chiều? Vậy nên content phải QUYẾT LIỆT đi thẳng vào nhu cầu ấy!

- Các dạng nội dung how-to, FAQ, câu hỏi giải thích, hành trình trải nghiệm thực sẽ có lợi thế – bởi AI Mode chủ động “dẫn dắt hội thoại”, thay vì chỉ quét đoạn text dài dòng.

4.2. Chuẩn Hóa Dữ Liệu, Khai Báo Thông Minh – Sống Sót Trong Đánh Giá “Chéo”

Bạn biết Schema, Rich data, Article, ImageObject, Product… không còn là thuật ngữ xa lạ nữa mà phải “ngấm vào máu”? AI Mode sẽ ưu tiên các trang web tối ưu structure, mô tả rõ ràng dữ liệu/ngữ cảnh, infographics, bảng số liệu… Thậm chí, ảnh/video đã tối ưu alt text, caption, chất lượng hiển thị là điểm cực kỳ mạnh giúp thúc đẩy ranking!

- Trình bày nội dung có cấu trúc: Ghép visual, số liệu, chuyên gia, review thật, chia nhỏ topic.

- Semantic Markup: Từ khoá, ý nghĩa, liên kết bối cảnh xuyên suốt giúp AI Mode “thuật lại” – chứ không chỉ copy-paste đoạn văn!

Hình minh họa SEO chạm mốc AI Mode 2025: 3 trụ cột – hội thoại đa chiều, dữ liệu cấu trúc, visual tối ưu – là nền móng để vượt qua thử thách xếp hạng mới.

Muốn đi vào chi tiết? Đừng bỏ lỡ cẩm nang này: Google Gemini 2 AI Mode: 10+ tips tối ưu SEO, tăng CTR traffic 2025

4.3. Lợi Thế Bền Vững Cho Ai Chủ Động

Hãy là doanh nghiệp, website “được chọn” bởi AI Mode – cơ hội giữ chân user lâu hơn, tăng tỉ lệ chuyển đổi, trở thành “câu trả lời đầu tiên” của bất cứ cuộc search giàu ngữ cảnh. Các thương hiệu tối ưu sớm sẽ xây dựng được “thẩm quyền thương hiệu” trên môi trường số, thích ứng mượt hơn với mọi cập nhật Gemini sau này.

Ví dụ điển hình: Các trang e-commerce vừa tích hợp review video, mô tả sản phẩm 3D, bảng so sánh giá – đã chứng kiến tỉ lệ click-through tăng 65% so với các site chỉ toàn văn bản.

5. Leadership Quotes on Google AI Search: Lãnh đạo Google nói gì – Tầm nhìn, sứ mệnh, nguyên tắc AI mới

Bạn từng nghĩ AI là cỗ máy vô cảm, làm việc theo lệnh? Góc nhìn ấy không còn đúng khi đọc phát ngôn của các lãnh đạo Google. Họ không chỉ nhấn vào cải tiến công nghệ, mà còn xác lập những nguyên tắc đạo đức, minh bạch, trao quyền cá nhân.

5.1. “Responsible Innovation” & “Agentic AI” – Sách Lược Đạo Đức Trong Kỷ Nguyên AI

- Sundar Pichai (CEO): “Chúng tôi không phát triển AI bằng mọi giá. Chúng tôi đặt trách nhiệm lên hàng đầu – đảm bảo AI mang đến lợi ích thực cho cả cộng đồng, duy trì minh bạch và bảo vệ quyền riêng tư.”

- Liz Reid (Head of Search): “Google hướng AI đến việc giải quyết rõ ý định, tự động hỗ trợ hành động (agentic) thay vì trả về kết quả tự động vô cảm. Đó là AI hiểu cá nhân từng khách hàng, vừa tạo niềm tin, vừa mang lại giá trị trọn vẹn.”

Họ cũng nhấn mạnh: Mọi bước nhảy công nghệ đều dựa trên triết lý “AI Explainability” – giải thích được logic của AI, luôn mở kênh feedback với cộng đồng, không xuất hiện lối “black box” bí hiểm như ở các giải pháp AI đóng.

Trích dẫn cảm hứng từ lãnh đạo Google – Nền tảng AI Mode là sự kết hợp giữa sáng tạo, minh bạch và cá nhân hóa hướng đến người dùng toàn cầu.

5.2. Ảnh Hưởng Thiết Thực – Khơi Dậy Niềm Tin Trên Đấu Trường Search

- Tính minh bạch là bắt buộc: Google chủ đích hiển thị cách AI xử lý query, lý giải kết quả để người dùng hiểu và có quyền kiểm soát.

- Yên tâm đầu tư lâu dài: Với cách lãnh đạo đặt ra hướng đi nhất quán, mọi SEOer, marketer hoàn toàn tự tin phát triển bền vững thay vì “đuổi theo” các update chóng vánh, thiếu niềm tin.

Gợi ý: Bạn nên thường xuyên cập nhật các phát ngôn, bản tin từ leadership Google để kịp thời hiệu chỉnh chiến lược digital/SEO cho doanh nghiệp, không sợ “bụi đường” hoặc bị đào thải bởi làn sóng update AI thần tốc.

6. Kết luận & Hành động: Chuyển mình cùng AI Search Era

Nếu bạn nghĩ Google Gemini AI Mode là “câu chuyện của các hãng lớn”, hãy nghĩ lại! Kỷ nguyên tìm kiếm AI không gạt bỏ ai cả – nó mở ra cơ hội bình đẳng cho bất kỳ ai sẵn sàng cập nhật, chủ động chuyển hoá content, nâng cấp site/web, xây dựng thương hiệu số vững chắc.

Checklist hành động đơn giản – nhưng mang tính “sống còn” thời AI Mode:

- Audit lại trải nghiệm web và app của bạn đã tối ưu cho tìm kiếm đa phương tiện chưa?

- Đầu tư mạnh vào nội dung hội thoại, video, infographic, khai báo schema đầy đủ, tránh tình trạng “web toàn chữ”.

- Cộng tác với chuyên gia, tận dụng mọi nguồn data chất lượng (review thật, bảng giá update, hướng dẫn chuyên sâu…) để tăng authority và sức hút content.

- Học liên tục: Đừng ngần ngại kiểm tra từ khóa mới, hành trình user mới, xu hướng AI Search mới mỗi tuần/tháng!

- Đừng bỏ qua: Google Search Upgrade 2025: AI Mode, Deep Search, Visual Shopping để làm giàu insight cho hành trình search AI, hiểu về nhóm “shopper số” hiện đại nhất.

Gợi ý: Nếu bạn là chủ start-up, blogger, marketer hay chỉ đơn giản là người quan tâm công nghệ, hãy thử tự mình trải nghiệm search AI Mode với các chủ đề yêu thích: ẩm thực, thể thao, giải trí, tài chính – chắc chắn bạn sẽ thấy mê mẩn với chất lượng kết quả và sự “nhiệt tình” của AI Mode mới!

7. Tham gia cộng đồng AI Automation Club by MCB AI

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa?

Đây không chỉ là một cộng đồng – mà còn là điểm hẹn của những ai đam mê mọi lĩnh vực AI, Workflow Automation, MMO, Affiliate Marketing và tự động hóa toàn diện. Bạn sẽ liên tục được truyền cảm hứng, cập nhật xu hướng mới, chia sẻ, học hỏi kỹ năng hiện đại “đúng kiểu” AI-driven với các thành viên cùng chí hướng từ khắp cả nước!

Cộng đồng có những gì đặc sắc?

- Diễn đàn chia sẻ kinh nghiệm AI thực tế: Từ chuyện tích hợp AI vào workflow, tối ưu MMO, AI marketing cho tới quản lý dữ liệu…

- Cuộc thi, Mini-game thường xuyên: Thưởng thức “trend AI” mới nhất, nhận quà – vừa vui lại vừa tăng trình độ!

- Kênh cập nhật chiến lược mới từ MCB AI: Luôn đi trước để không bị “mất sóng tương lai”.

Tham gia ngay tại đây: AI AUTOMATION CLUB

Tóm lược giá trị cốt lõi:

- Gemini AI Mode – trụ cột kiến tạo cuộc cách mạng search đa phương tiện, hội thoại tự nhiên, cá nhân hóa sâu sát – đã đến và đang bùng nổ mỗi ngày.

- Mọi trải nghiệm số, SEO, chiến lược nội dung đều cần “đại tu” để sống sót và phát triển cùng AI Mode.

- Google xác lập tiêu chuẩn đạo đức, thực thi minh bạch, tăng niềm tin từ cộng đồng – AI không còn mù mờ cảm xúc mà tôn trọng cá nhân, hành vi thực.

- Ai chủ động cập nhật, thử nghiệm, tối ưu sớm sẽ là người chiến thắng trên sân chơi search AI & content thời đại mới.

Từ khóa nổi bật: Gemini AI’s multi-modal learning, Technical architecture breakthroughs, AI-driven context recognition, Comparative strength vs. previous AI, Interactive AI Mode UI, Instant, contextually relevant results, Mobile-first innovation, User empowerment, Personalization engines, Precision and relevancy in results, Multimodal integrations, Real-time and conversational search, SEO adaption to AI Mode, Intent and context strategies, Content optimization for conversational AI, 2025 ranking factors, Sundar Pichai’s AI future vision, Liz Reid on agentic AI and user needs, Innovation narrative and trust-building, Leadership roadmaps for AI search.

Bạn có ấn tượng gì về trải nghiệm search AI mới hoặc vướng mắc, góc nhìn khác biệt nào với Google Gemini AI Mode 2025? Hãy để lại ý kiến, kể câu chuyện thú vị hoặc chia sẻ thử nghiệm cá nhân tại phần bình luận bên dưới. Cộng đồng MCB AI luôn sẵn sàng thảo luận để mở rộng góc nhìn, tìm ra giải pháp hay nhất cho từng nhà sáng tạo trong kỷ nguyên AI!