Trong bối cảnh AI tạo sinh bùng nổ toàn cầu, cuộc đua xây dựng hạ tầng, trung tâm dữ liệu đang nóng hơn bao giờ hết và không chỉ còn là lĩnh địa của những “ông lớn” như Nvidia hay Google. Nếu bạn là CTO, nhà sáng lập startup công nghệ, hay chỉ đơn giản là người đam mê AI và muốn hiểu xu hướng democratization AI compute – đây là bài viết đem tới phân tích toàn cảnh từ câu chuyện khởi nghiệp của TensorWave, lý do chọn AMD “phản dòng” thay vì Nvidia, chiến lược vốn, kiến trúc kỹ thuật cho đến góc nhìn thị trường 2024–2025, rủi ro/cơ hội, lời khuyên thực chiến và cả kết nối cộng đồng AI Automation Club. Dù bạn muốn săn trend, tìm nền tảng tiết kiệm chi phí, hay đơn giản là hiểu sâu về democratization AI, nội dung dưới đây chính là bản đồ dành riêng cho bạn.

TensorWave & AMD: Bước Nhảy Đột Phá Trong Democratization AI Compute Toàn Cầu

Chúng ta đang sống giữa đại dịch AI! Không, đó không đơn thuần là một trào lưu – mà là làn sóng cuốn phăng những thứ cũ kỹ, từng định hình bởi các gã khổng lồ như Nvidia, Google, Microsoft… Nhưng hãy dừng lại một chút và nhìn về phía những “underdog” – cái tên như TensorWave, nơi mà mọi định kiến về việc ai sở hữu AI compute đang bị lật ngược.

Trung tâm dữ liệu kiểu mới – Kẻ thách thức mọi quy chuẩn

TensorWave đã lặng lẽ (nhưng cực kỳ quyết liệt) đặt cược vào nền tảng AMD cho AI. Trung tâm dữ liệu của họ không chỉ là nơi đặt máy chủ – đó còn là biểu tượng khát vọng biến AI trở thành tài sản chung — dành cho tất cả, không chỉ “ông lớn” mới hưởng lợi.

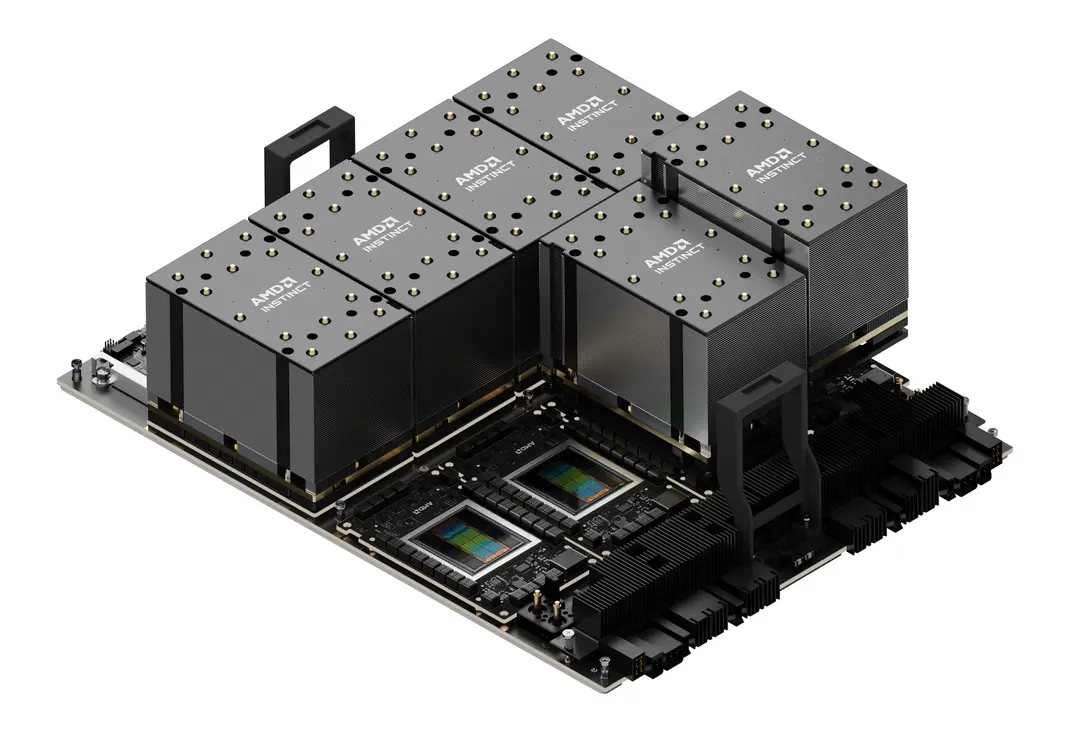

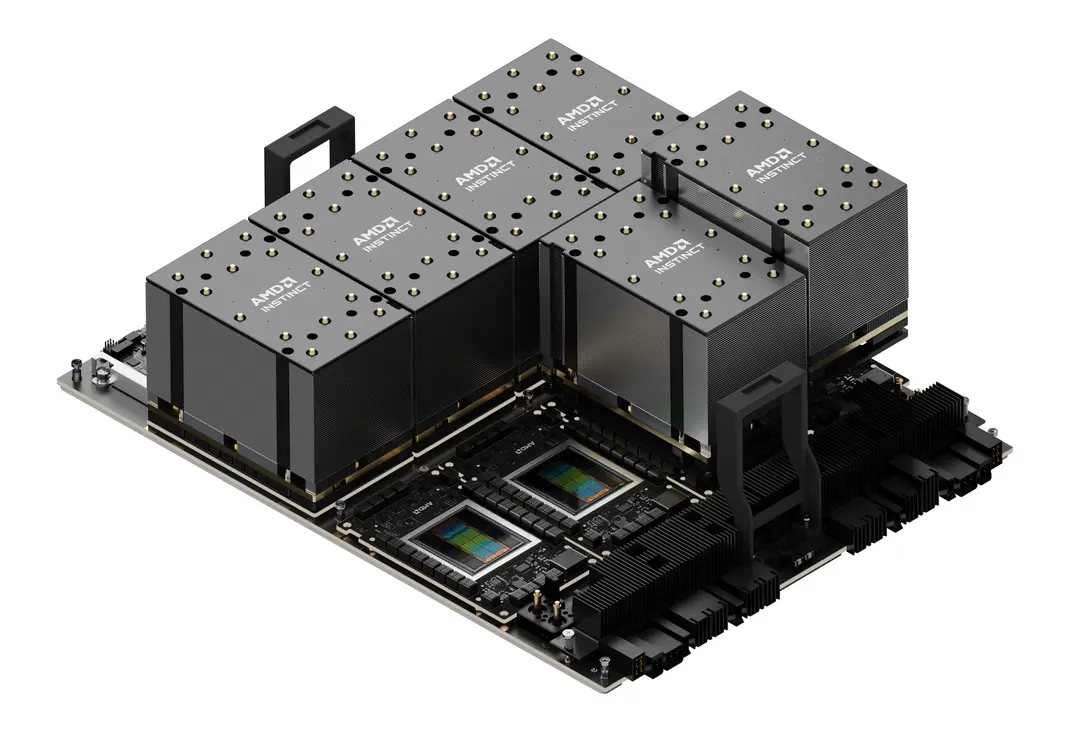

Hình ảnh: Trung tâm dữ liệu hiện đại của TensorWave – Vị thế tiên phong về quy mô, độ an toàn & chuẩn AMD cho AI next-gen

Thay vì “đua vũ trang” với Nvidia như đa số, TensorWave thẳng tay chơi lớn với AMD Instinct MI325X, biến mình thành nhà cung cấp hạ tầng AI-native của AMD lớn nhất toàn cầu. Điều này không chỉ là quyết định tài chính – mà còn là lựa chọn chiến lược, bởi việc xây dựng hệ sinh thái AMD giúp họ giảm phụ thuộc nguồn cung truyền thống, hạ rào cản chi phí cho doanh nghiệp khát khao bước vào kỷ nguyên machine learning.

“AI For All”: Hành trình hiện thực hóa giấc mơ dân chủ hóa AI Compute

Có câu hỏi này bạn phải tự hỏi: trên đường đua AI, bạn muốn là “khán giả đứng ngoài cổng”, hay là tay đua thực thụ phóng vào playground? TensorWave, với hệ sinh thái AMD Instinct MI325X, đang mở toang cổng sân chơi ấy.

-

Chiến lược lấy democratization làm “cốt lõi”:

Bạn là SME, startup hay doanh nghiệp lớn? Không còn câu chuyện “chỉ người khổng lồ mới đủ chip AI xịn”.

Đội ngũ lãnh đạo vốn xuất thân từ các hyperscaler, top-tier cloud builder, tư duy mở, tăng trưởng bền vững, đặt khách hàng vào trung tâm mọi quyết sách. -

Vượt “bóng đen” Nvidia:

AMD native không chỉ là thay thế – mà là bước đi dũng cảm nhằm tạo chuẩn mực mới: hạ tầng AI phải dễ tiếp cận hơn, mạnh mẽ hơn và phù hợp với đủ loại túi tiền, quy mô.

Một lời nhắn hành động đến bạn

Nếu bạn hoặc tổ chức của mình đang nhủ thầm “đã đến lúc scale up AI”, TensorWave cùng nền tảng AMD chính là cánh cửa dẫn lối: từ dữ liệu raw tới deployment thực chiến, sẵn sàng san phẳng mọi rào cản cũ.

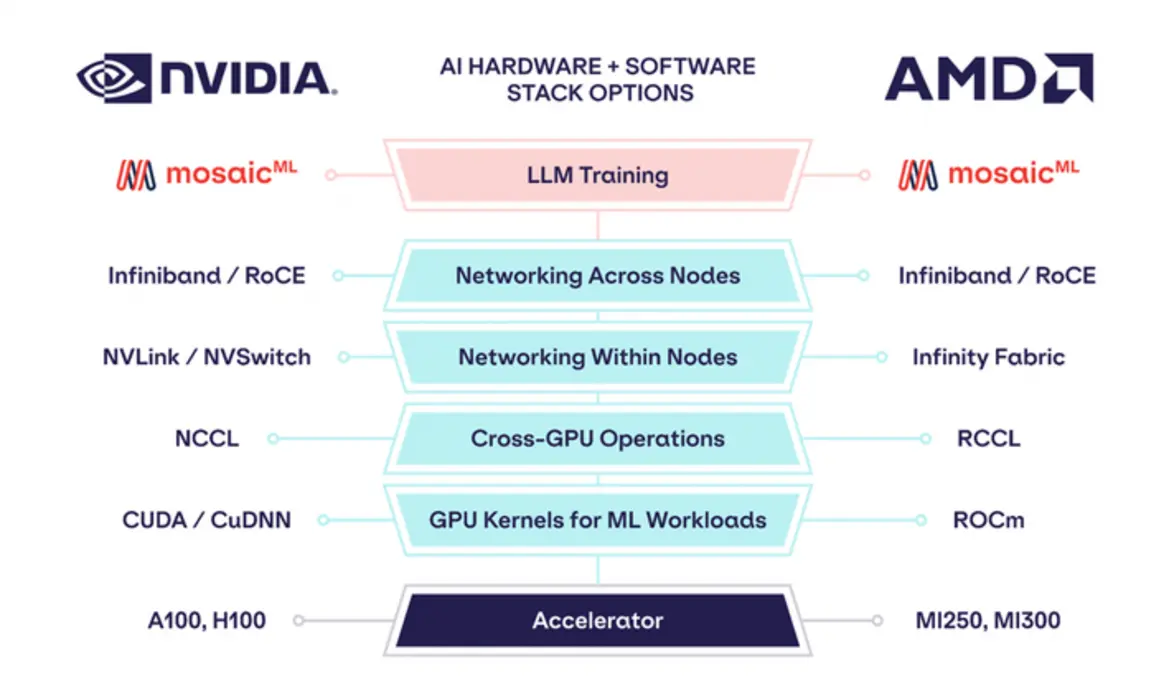

1. AMD vs Nvidia Trong Hạ Tầng AI: Đừng “Chọn Bừa”, Biết Rõ Để Không Đi Lùi

Bây giờ hãy thử tưởng tượng bạn là CTO, định rót triệu đô cho training AI. Đứng giữa hai ông lớn AMD và Nvidia, chọn ai? “Chọn AMD liệu có là canh bạc mạo hiểm?” Đó không còn là câu hỏi xa lạ, nhất là khi “mỏ vàng AI” ngày càng nóng.

So sánh AMD Instinct MI325X với Nvidia – Bảng vàng dành cho CTO, Tech Lead

Điểm mạnh MI325X “ghi điểm” trước khách hàng AI như thế nào?

-

Hiệu năng/chi phí vượt trội:

Không đơn thuần là tốc độ, MI325X còn “ghi điểm” về tổng TFLOPS/$. Có thông số thực tế cho thấy PCIe Gen5 “chiến tốt”, cân dễ mọi workload LLM, deep learning khủng. -

Kiến trúc liquid cooling hiện đại:

Một thử thách cho mọi data center AI là tỏa nhiệt – giải pháp cooling lỏng (liquid) duy trì ổn định, chẳng cần ngồi thấp thỏm lo máy nóng, tụt hiệu năng. -

Dễ mở rộng quy mô:

GPU AMD MI325X, đi kèm kiến trúc mở, giúp bạn “phóng đại” cluster AI với chi phí dễ chịu hơn – không vướng tình trạng khan hiếm hay bị Nvidia “hắt hơi cả ngành cảm lạnh”.

Nvidia: Những gì đang là ưu thế, và… cơn đau đầu chi phí

- Về phần cứng:

GPU H100/H200 của Nvidia vẫn có những benchmark đỉnh, CUDA ecosystem mạnh, phần mềm tối ưu hàng đầu. - Nhược điểm then chốt:

Các báo cáo thị trường 2024 chỉ ra đầu tư Nvidia về mặt dài hạn thường đội giá lên 20–35%; khan hiếm nguồn cung liên tục; phần mềm và hạ tầng bị “giam” trong hệ sinh thái riêng khó migrate.

Thực tế thị trường:

- TCO (Total cost of ownership):

Cluster AMD MI325X tại TensorWave cho tổng chi phí thấp hơn tới 30% so với Nvidia trong vòng 36 tháng. - Xu hướng chuyển dịch:

Rất nhiều “AI cloud provider” lớn đang đồng loạt dịch chuyển về AMD – tập trung vào “open standard”, tự do chọn phần cứng, giảm thiểu lock-in.

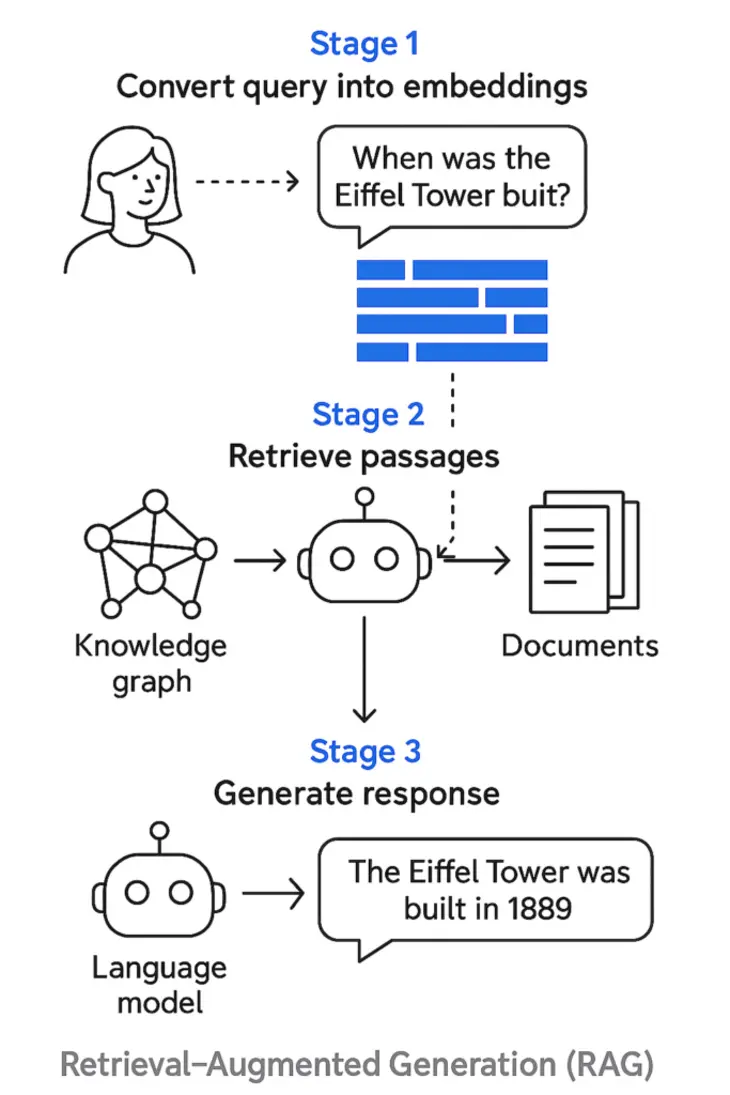

Phần mềm AI: Nvidia liệu còn là “độc quyền công nghệ”?

Đúng, CUDA từng là “vũ khí bí mật” kéo phần lớn AI developer nán lại với Nvidia. Nhưng gần đây, open-source framework như PyTorch, TensorFlow đã được tối ưu mạnh tay cho ROCm/AMD, tạo bước nhảy lớn về khả năng tương thích, hiệu năng… Rào cản phần mềm “cổ điển” đang bị xóa nhòa.

Kết luận chuyên gia:

Nếu bạn muốn đánh đổi “hiệu năng độc quyền” lấy lợi ích democratization AI: đã tới lúc mở lòng với AMD, cho phép AI scale-up rộng lớn với chi phí hợp lý, không phụ thuộc vendor.

Xem thêm:

Bạn muốn đào sâu case thực chiến về lựa chọn hạ tầng AI? Mời bạn đọc Alibaba ZeroSearch: Giảm Chi Phí, Tăng Tốc Huấn Luyện LLM để thấy cách các ông lớn xử lý bài toán nền tảng cho AI scale-up.

2. Series A Funding & Cú Hích Đổi Đời Cho AI Cloud

Ở thung lũng Silicon, người ta thường nói: “Có ý tưởng tốt là một chuyện, có vốn lớn mới thực sự tạo nên khác biệt”. Với TensorWave, cú bơm vốn “khủng” – 100 triệu USD Series A – là tấm vé vàng mở ra tương lai mới cho hạ tầng AI cloud.

Các dòng vốn đang được “giải ngân” ở đâu?

-

Mở rộng cụm infrastructure AMD-native:

Mục tiêu xây dựng cụm AMD-native lớn nhất “cloud”, giảm đáng kể độ trễ, nâng cấp khả năng phục vụ enterprise/SME/startup đồng thời. -

Triển khai nhanh “liquid cooling” trên diện rộng:

Các cluster MI325X được đầu tư thêm cooling lỏng – công nghệ chỉ có ở top-tier data center – sẵn sàng chịu tải cực nặng, tiết kiệm điện, bảo vệ môi trường. -

Thu hút nhân sự đỉnh cao, mở rộng R&D:

Đội ngũ AI/research engineer được đầu tư thẳng tay, tăng thời gian ra mắt sản phẩm, mở rộng kết nối quốc tế.

Từ vốn tới doanh thu: Democratization AI biến thành con số cụ thể

Dự phóng nội bộ: Doanh thu tăng trưởng hai chữ số đều đặn tới giữa 2026 nhờ ưu thế hạ tầng AMD. Đặc biệt, nhóm SME, startup – những “dreamer” mới của AI – giờ đây tiếp cận sức mạnh mà một, hai năm trước còn xa vời.

Hình ảnh: Series A như “liều doping” – bùng nổ cluster, foster ecosystem, boost doanh thu ngay trên nền tảng AMD-native.

3. Kiến Trúc Kỹ Thuật: MI325X + Liquid Cooling – Hệ Sinh Thái Toàn Diện Cho AI Scale-Up

Bạn từng nghe về AI “ngốn điện” và “nóng như lò lửa”? Hãy hỏi bất kỳ operator nào của data center thời nay, họ sẽ kể chuyện sợ cooling lỗi còn hơn… sập internet. Cũng vì thế, TensorWave kết hợp MI325X với kỹ thuật liquid cooling, cho phép “đốt hiệu năng” mà không sợ máy nghỉ, tăng uptime tới mức tối đa.

Sức mạnh combo: MI325X + Liquid Cooling được kiểm chứng trên thực tế

-

Hiệu suất compute-watt tối đa:

Đẩy cao mật độ GPU, dễ dàng “ép xung” mọi bài toán LLM, generative AI đòi hỏi “cày ngày cày đêm”. -

Bảo trì/uptime vượt trội:

Cooling lỏng giảm nguy cơ overheat, tăng thời gian hoạt động (uptime), tối ưu luồng công việc (training/inference) mà không bị gián đoạn. -

Tốc độ triển khai ấn tượng:

Nhờ nguồn vốn Series A, khách hàng TensorWave có thể thử nghiệm và dùng hạ tầng high-end nhanh hơn – trước cả khi đối thủ “trở tay kịp”.

Minh chứng từ khách hàng:

- Huấn luyện AI (Generative/LLM):

Test thực tế cho thấy tiết kiệm đáng kể chi phí điện, “thu ngắn” giai đoạn training, tối ưu hóa sử dụng cụm GPU. - Inference thực chiến:

Các AI cloud client xác nhận – latency giảm, vận hành rẻ hơn, ổn định hơn so với benchmark Nvidia truyền thống.

4. Democratization AI: Đừng Để Lỡ Cơ Hội Vàng & Cạm Bẫy Thị Trường 2025

2025–2026 sẽ là thời điểm AI không chỉ dành cho “ông lớn”. Sự phá thế độc quyền, tiêu chuẩn hóa phần cứng mở, democratization compute đã manh nha trở thành xu thế không thể đảo ngược.

Ai sẽ hưởng lợi – và nhóm nào sẽ hụt hơi?

-

Doanh nghiệp vừa/nhỏ, startup

Một năm trước, ai muốn train lớn đều lắc đầu vì chi phí Nvidia ngất ngưởng. Với MI325X, mọi giấc mơ AI scale-up đều chạm được! Tăng tốc dự án, test nhanh ý tưởng mới chỉ bằng… khoản đầu tư vừa phải. -

Tiết kiệm năng lượng & vận hành xanh:

Liquid cooling – điện năng tối ưu, giữ carbon footprint thấp, hợp trend ESG/green tech toàn cầu. -

Đột phá cho nhà đầu tư “nhạy bén”:

Kẻ nào dám open-minded, thử AMD sớm sẽ tránh được khan hàng Nvidia, kiểm soát chi phí input tốt hơn… – trend của các quỹ đầu tư AI tại Mỹ, châu Âu đang cho thấy tín hiệu này.

Đâu là rủi ro thực tế?

- Cuộc đua phần cứng khắc nghiệt:

Nếu chậm thích nghi, không thử AMD, bạn dễ trở thành “kẻ lỗi thời” khi thị trường chỉ nói chuyện open standard, scale fast. - Đảm bảo leadership vận hành:

Đội tàu nhà TensorWave – tập hợp chuyên gia từ các hyperscaler, startup AI lớn – đã chứng thực bản lĩnh “vượt bão” thị trường, dẫn dắt xu thế mới, giữ vững cam kết lâu dài với client.

Góc nhìn từ Data Center thật: Cluster MI325X tại TensorWave – liquid-cooled, tối ưu hóa cho vận hành AI sản xuất thực tế 2025.

5. Đừng Để Xu Thế Trôi Qua: Lời Khuyên Hành Động Từ “Dân Trong Nghề”

- Đầu tư sớm vào AMD-native clusters:

Làm chủ trục sức mạnh trước khi mainstream – ai tiên phong sẽ là người dẫn dắt cuộc chơi. - Chuyển đổi linh hoạt lên hybrid/open infrastructure:

Benchmark để khám phá ngay điểm mạnh cluster AMD; control TCO, sẵn sàng “nhảy” trước đối thủ 6–12 tháng. - Theo sát các roadmap từ TensorWave:

Mỗi partner ký mới, technical update đều có thể “bẻ lái” thị trường – đừng “bị động đứng ngoài”. - Cam kết test production thực chiến:

Thị trường AI chỉ thưởng cho ai dám thử, dám triển khai thật – đây chính là thời cơ lớn để bạn tối ưu vị thế và chi phí doanh nghiệp.

6. Góc Nhìn Chiến Lược & Case Study Thực Tế: Học Từ Người Đi Trước

Muốn nhìn thấy sức mạnh AI cloud scale-up? Hãy theo dõi những dự án tập đoàn lớn đang bắt tay cùng “đội phá cách” như TensorWave. Đơn cử, hãy Xem thêm về case study nổi bật: AWS – Trung Tâm AI 5 Tỷ USD Tại Ả Rập Xê Út.

Bài học ở đây: Sự hợp tác sâu giữa hyperscaler và startup hiện đại chính là chìa khóa mở đường cho AI democratization toàn cầu, chứ không còn đơn thuần chạy theo phần cứng đắt đỏ.

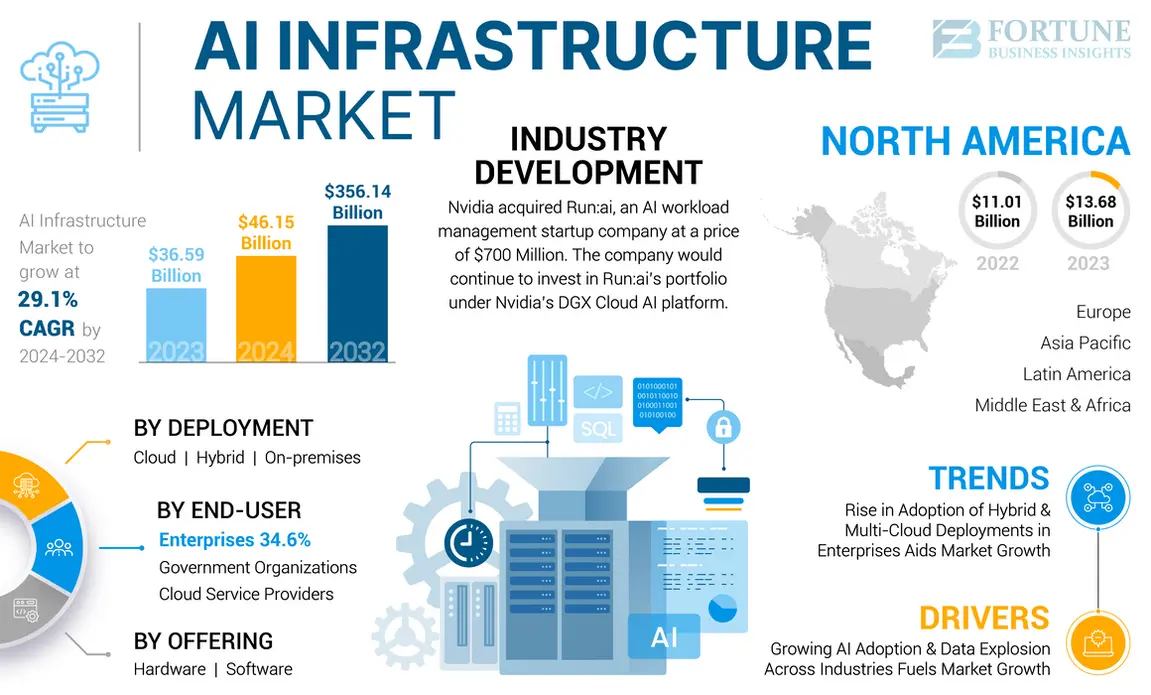

7. Một Chút Số Liệu, Ngẫm Nghĩ & Trend Thị Trường AI 2024–2025

Để thấy bức tranh rõ nét hơn, tôi muốn bạn cùng nhìn qua vài con số ấn tượng:

- Theo dữ liệu CBInsights (2024), tổng giá trị đầu tư vào hạ tầng AI cloud toàn cầu ước đạt 120 tỷ USD, tăng 64% so với 2022.

- Nghiên cứu của Omdia chỉ ra, đến cuối 2025, các nhà cung cấp AI cloud sử dụng AMD dự kiến tăng trưởng cao gấp 3 lần so với ngành chung, nhờ chi phí hạ tầng giảm – thị phần có khả năng cán mốc 30% (so với chỉ 10% hồi 2022).

- Một khảo sát nội bộ của TensorWave cho hay: 80% khách hàng của họ là SME, startup bắt đầu “chuyển nhà” lên AI cloud native AMD từ 2023, mức thoả mãn dịch vụ tăng liên tục, chi phí cắt giảm bình quân 28%.

Hãy thử nghĩ mà xem: Giấc mơ AI dân chủ hóa đã dần trở thành bài toán ROI cụ thể, chứ không còn là những viễn cảnh xa vời trên slide thuyết trình!

8. Góc Nhìn Văn Hóa Đại Chúng: AI, AMD Và “Cuộc Đua Vũ Trang” Công Nghệ

Bạn đã bao giờ xem một clip TikTok viral kiểu “build server GPU cực ngầu” chưa? Các YouTuber, streamer thời nay đã bắt đầu bật mí bên trong máy chủ AI “to chà bá” của mình đầy… AMD Instinct, chứ không chỉ là Nvidia như trước! Bắt trend nhanh hơn, tiết kiệm hơn – đó là điểm khiến giới trẻ đổ xô thử sức với AI cloud, không chỉ vì tò mò công nghệ mà còn bởi khả năng thực thi các project cá nhân, học thuật với ngân sách khiêm tốn.

Spotify, Netflix từng đưa AI vào mọi quy trình tối ưu trải nghiệm người dùng – thì giờ đây, các startup Việt Nam, Thái Lan, Singapore cũng sở hữu cơ hội tương tự khi tiếp cận nền tảng compute xịn với chi phí “dễ thở”, không còn là độc quyền của Thung lũng Silicon.

9. Tạm Kết: Đường Đua AI Nóng Bỏng Đang Chờ Bạn

Kết thúc một vòng khám phá, có lẽ bạn cũng đã tự trả lời: AI democratization không còn là mơ mộng hay khẩu hiệu marketing nữa! Với nguồn vốn vững mạnh, mô hình cluster AMD-native, tốc độ scale cụm liquid-cooled MI325X, cùng triết lý chiến đấu thực chiến của TensorWave – AI thực sự bước vào kỷ nguyên bình dân, tối ưu chi phí và không phụ thuộc ai.

Và nhớ nhé, đứng ngoài là lựa chọn an toàn – nhưng chính bạn sẽ bỏ lỡ chuyến tàu AI “bình dân hoá” đang tăng tốc mỗi ngày. Còn ngập ngừng gì nữa, hãy chủ động tìm hiểu, thử sức – xây dựng, thử nghiệm và tăng tốc cùng AI thời đại mới!

10. Khám Phá Thêm: AI Automation Club — Địa Chỉ Kết Nối Cộng Đồng AI “Có Chất”

Bạn nghe tới AI Automation Club chưa? Đây là nơi hàng trăm thành viên, từ developer đến founder MMO/Affiliate, đội ngũ kỹ thuật và marketer, học hỏi chia sẻ bí kíp “chiến AI”, làm workflow automation, tìm kiếm lộ trình hợp tác, phát triển dự án mới.

Chưa bao giờ cơ hội phát triển kỹ năng cùng kết nối thực chiến lại mở rộng dễ dàng như thế. Tham gia cực nhanh tại đây: AI AUTOMATION CLUB.

Sẵn sàng nhấc máy bàn kế hoạch thử nghiệm AMD-native cluster, trao đổi AI, automation hoặc chỉ đơn giản là cập nhật trend hot mới nhất? Đừng ngại tham khảo, hỏi đáp và trở thành người chơi hệ AI thực thụ cùng cộng đồng TOP của thế hệ mới!