Chào mừng bạn đến với thế giới AI hiện đại, nơi từng chiếc laptop văn phòng đều có thể trở thành “máy chủ AI” cục bộ nhờ Windows AI Foundry – bước đột phá mới nhất vừa được Microsoft công bố tại Build 2025. Bài viết này sẽ giúp bạn bóc tách mọi góc khuất về nền tảng AI local trên Windows: chiến lược, kiến trúc, tăng tốc phần cứng, so sánh hiệu năng ONNX Runtime, checklist SDK/CLI thực chiến, mẹo chọn CPU, GPU, NPU và cách đồng bộ cùng hệ sinh thái Azure – Microsoft. Bạn sẽ khám phá vì sao Windows AI Foundry có thể giúp doanh nghiệp tiết kiệm chi phí, bảo mật dữ liệu tối đa, cá nhân hóa trải nghiệm AI, tăng tốc phát triển và triển khai model ngay trên thiết bị quen thuộc. Đừng bỏ lỡ bí kíp, best-practice và chia sẻ thực tiễn từ chuyên gia giúp bạn sẵn sàng bứt phá AI local ngay hôm nay!

Windows AI Foundry – Kiến Tạo Chuẩn Mới Cho Máy Chủ AI Cục Bộ Trên Windows

Tóm tắt nội dung

- Góc nhìn chiến lược, triết lý phát triển của Windows AI Foundry

- Đột phá kiến trúc đa tầng: hiệu năng thần tốc, bảo mật cực cao, đồng bộ hệ sinh thái số 1 thế giới

- Soi kỹ hiệu năng inference ONNX Runtime trên Foundry Local so với nền tảng khác

- Cẩm nang chọn phần cứng “chuẩn không cần chỉnh”: CPU, GPU, NPU tương thích, bí quyết tối ưu tận răng

- Khai phá giới hạn: kết nối Azure AI, truy cập model catalog, trải nghiệm cộng đồng phát triển quốc tế

- Hướng dẫn thao tác, checklist vận hành SDK/CLI – đầy đủ best practices, lối đi thực chiến

- Góc nhìn chuyên gia, phân tích thực tiễn, liên kết nội bộ tăng giá trị khai phá AI doanh nghiệp

I. Windows AI Foundry: Tầm Nhìn Chiến Lược & Đột Phá Kiến Trúc (Platform Overview)

Ngay ở vạch xuất phát của kỷ nguyên “AI mọi nơi, mọi lúc” trên desktop, Microsoft đặt cược lớn với Windows AI Foundry tại sự kiện Build 2025. Đừng chỉ coi đây là bản nâng cấp phần mềm! Foundry chính là con bài chiến lược, biến mọi thiết bị Windows – từ desktop, laptop văn phòng cho tới thiết bị edge siêu di động – thành máy chủ AI cục bộ thực thụ. Vậy, triết lý và kiến trúc nào đằng sau nền tảng này khiến cộng đồng tech lead và doanh nghiệp rộn ràng đến vậy?

1. Triết Lý Cốt Lõi: AI Local-First, Bảo Mật Tối Đa, Siêu Tối Ưu Phần Cứng

Chìa khóa nằm ở triết lý AI local-first – ưu tiên vận hành, inference và cả đào tạo mô hình ngay tại máy. Mọi thứ đều xoay quanh hai chữ “chủ động”: chủ động kiểm soát dữ liệu, chủ động chọn phần cứng, chủ động về chi phí và chủ động… bảo mật.

- Local-first: Không cần gửi dữ liệu, mã nguồn, hay mô hình lên cloud nếu không thực sự bắt buộc. Bạn là người kiểm soát mọi thứ của mình.

- Data privacy by design: Microsoft tích hợp bảo mật chặt chẽ từ hệ điều hành (Windows Hello, BitLocker, chính sách quản trị doanh nghiệp) – loại bỏ nguy cơ rò rỉ dữ liệu ngay từ gốc.

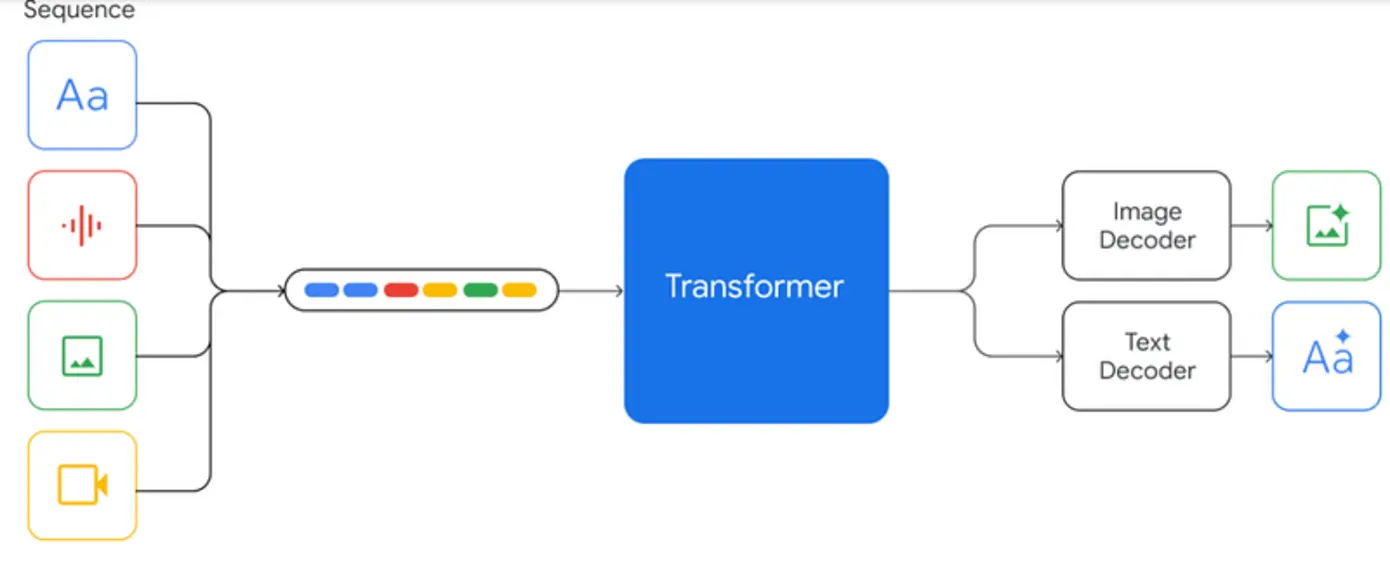

- Module hóa hiện đại: Foundry xây dựng từ lõi ONNX Runtime, kết hợp các engine tăng tốc phần cứng (DirectML cho Windows, CUDA cho NVIDIA, ROCm cho AMD…), tự động nhận diện phần cứng (CPU, GPU, NPU) để tận dụng tối đa năng lực của thiết bị bạn đang có trong tay.

Giá trị then chốt:

Các nhóm AI, developers hoàn toàn kiểm soát mô hình, dữ liệu, mã nguồn. Không còn cảnh lệ thuộc vào đám mây khi không cần thiết!

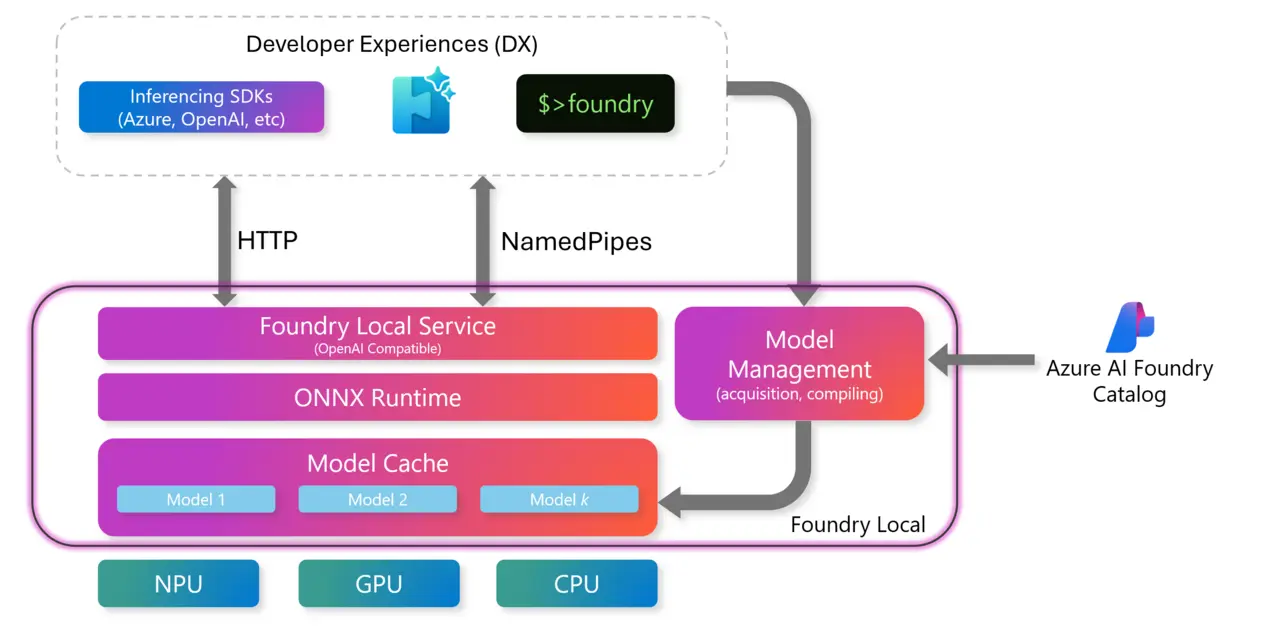

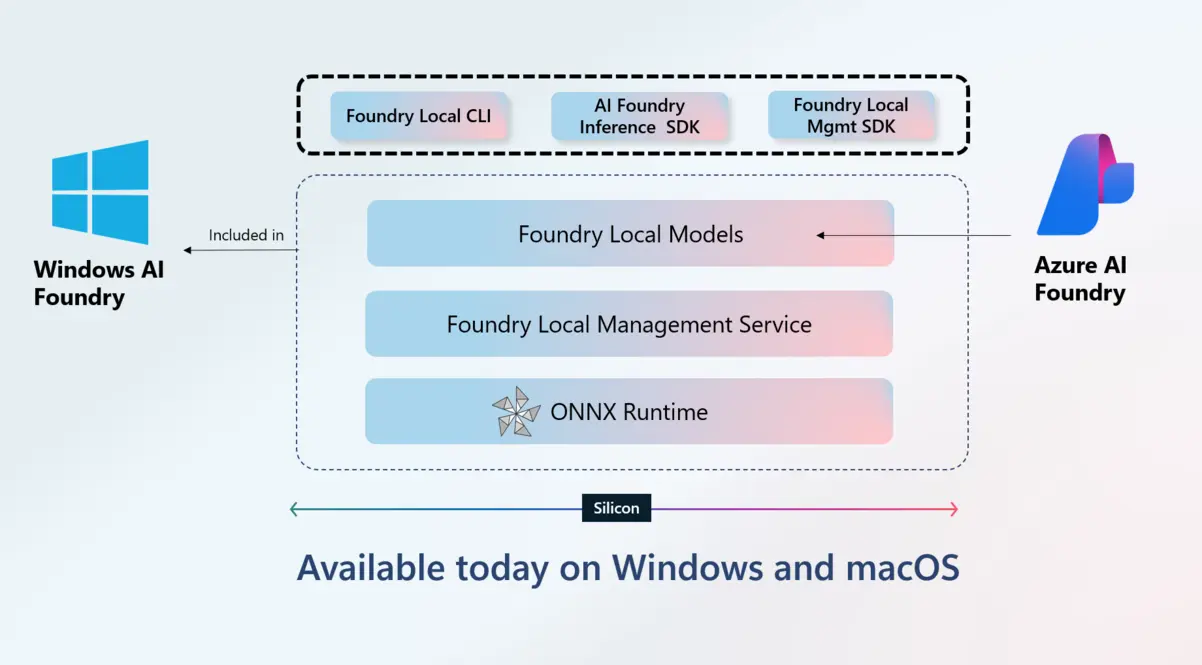

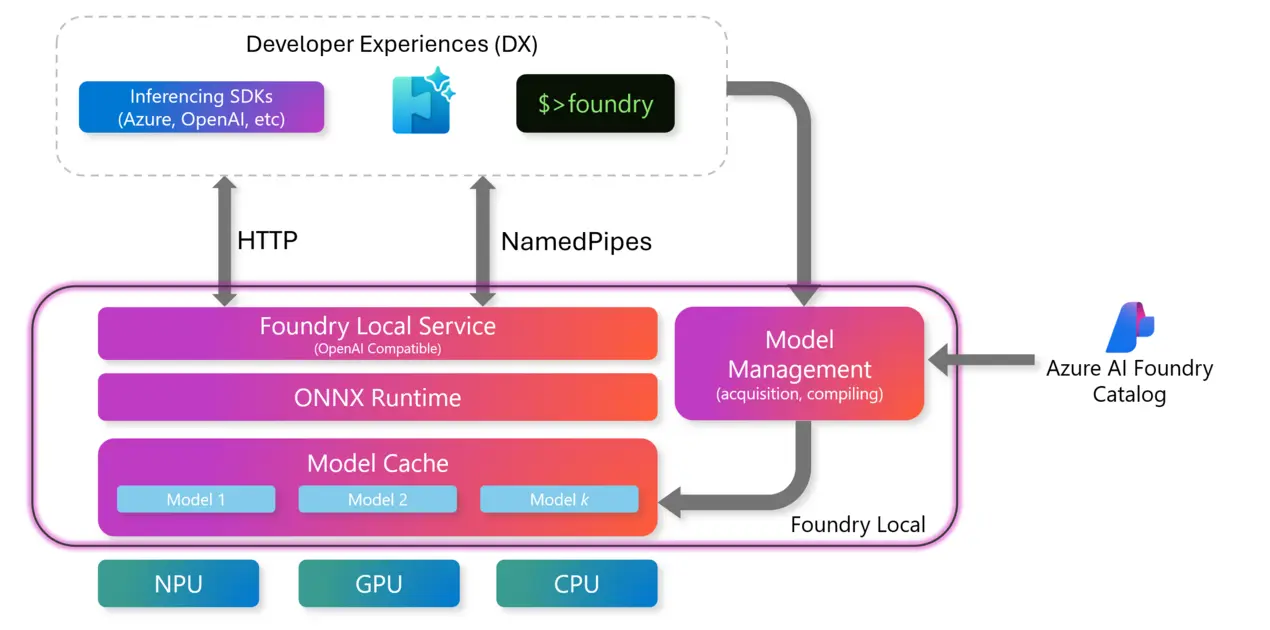

2. Sơ Đồ Tổng Quan Kiến Trúc & Các Lớp Tính Năng

Alt: Tổng quan kiến trúc nền tảng Windows AI Foundry

Các lớp chính:

- ONNX Runtime Core: Tim AI “tăng tốc”, tối ưu hiệu suất inference cho mọi loại mô hình, từ NLP, computer vision đến generative AI.

- Hardware Acceleration Layer: Tương thích tối đa với các công nghệ phần cứng mới nhất (NPU, GPU, CPU), dễ dàng chuyển đổi giữa các thiết bị.

- Secure Data Layer: Bảo vệ cực chặt tài sản số và dữ liệu cục bộ nhờ tích hợp sâu BitLocker, Windows Hello và các chính sách quản trị doanh nghiệp.

- Model Integration: Linh hoạt liên kết với hệ sinh thái Azure AI, Model Catalog và phân phối qua Microsoft Store, phục vụ đa dạng nhu cầu từ cộng đồng cá nhân tới doanh nghiệp.

Sự khác biệt đỉnh cao:

- Chỉ một cú click – test, deploy, tích hợp model trên mọi môi trường Windows (không cần cloud phức tạp, phù hợp mọi quy mô dự án).

- SDK, CLI dễ update – tất cả quy trình AI đều tự động hóa, từ CI/CD đến batch processing, chưa bao giờ “mượt” đến vậy.

- Hệ sinh thái phần cứng được hỗ trợ cực đa dạng: từ workstations, laptop ARM, desktop, thiết bị edge cho tới những chiếc notebook nhỏ gọn.

3. Ưu Thế Triển Khai Thực Tiễn

Chỉ riêng tại Build 2025, khảo sát nội bộ của Microsoft cho thấy:

- Quy trình phát triển – triển khai model giảm 30-50% thời gian so với trước.

- Phù hợp cho cả startup lẫn doanh nghiệp lớn, tiết kiệm hàng trăm ngàn đô la chi phí cloud và compliance.

Hãy tưởng tượng bạn đang build một ứng dụng NLP, vision, hay LLM: việc quản lý vòng đời model, inference, bảo mật… đều được tối ưu hóa và đồng bộ trên chính chiếc máy quen thuộc, không can thiệp đám mây nếu bạn không muốn. Đậm chất chiến lược, đúng không?

II. ONNX Runtime trên Foundry Local: So Sánh Tốc Độ Inference & Hiệu Năng Thực Tế

Bạn từng thất vọng với hiệu năng inference của các giải pháp AI trên máy cá nhân? Câu chuyện ấy nay đã khác nhờ tích hợp ONNX Runtime trên Foundry Local.

1. ONNX Runtime – “Siêu Động Cơ” Cho AI Cục Bộ

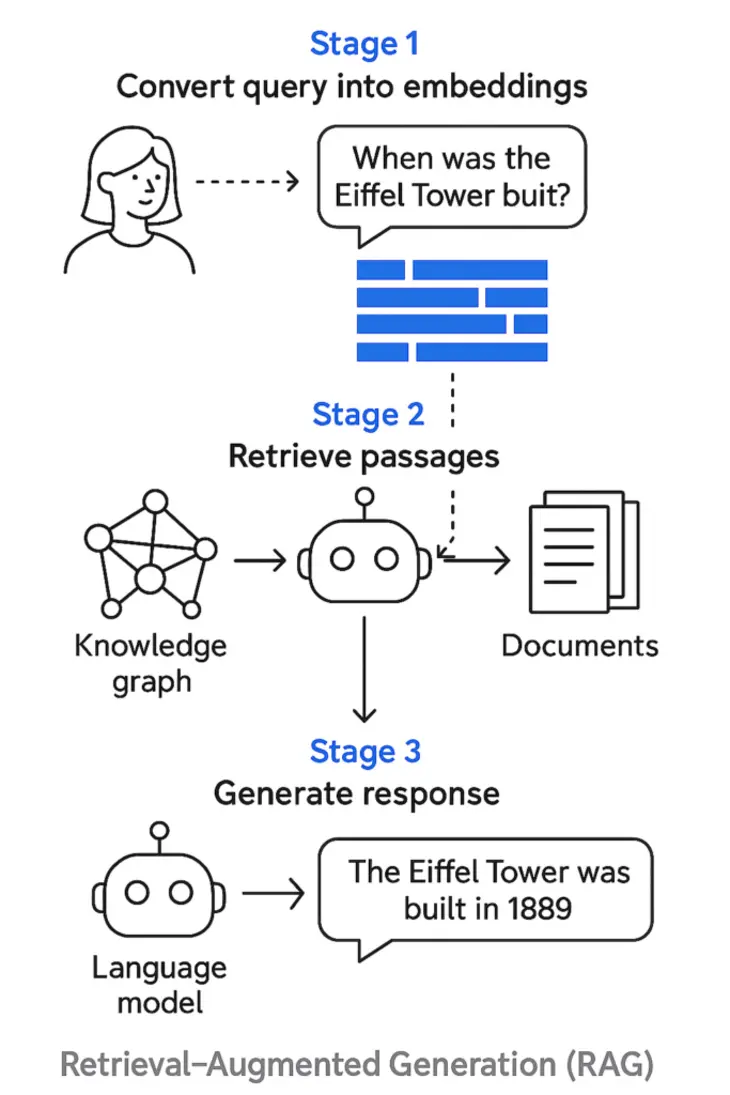

ONNX Runtime không chỉ là engine inference mở hỗ trợ hầu hết các mô hình AI “hot” nhất (NLP, computer vision, generative model). Khi được kết hợp với Foundry Local, nó còn unlock loạt tính năng sau:

- Nhận diện tự động chipset tăng tốc: Bạn có dùng DirectML, CUDA, AMD ROCm, hay Intel AI Boost? Tất cả đều được Windows AI Foundry phát hiện và tối ưu ngay.

- Tối ưu hóa thực thi: Tận dụng parallel computing cho CPU, GPU, NPU – giảm overhead truyền dữ liệu, tiết kiệm điện năng, tối ưu nhiệt độ thiết bị.

- Latency giảm tới 35–70%: So với giải pháp cloud-based hoặc inference truyền thống trên desktop, trải nghiệm thực tế trên Foundry Local mượt hơn hẳn.

2. Biểu Đồ So Sánh Hiệu Năng Thực Tế

Alt: Biểu đồ hiệu năng ONNX Runtime trên Foundry Local Windows AI Foundry, so sánh các loại phần cứng

Dữ liệu thực tế cho thấy:

- Thời gian inference trung bình giảm mạnh ở cả tác vụ vision, NLP, LLM – dù là model nhỏ hay cực lớn.

- Tận dụng tối đa tài nguyên: CPU phù hợp cho inference nhẹ, tiết kiệm pin; GPU xử lý những batch lớn; NPU “gánh” model AI real-time (voice, streaming video).

3. Kết Hợp AI Local với Mô Hình Lớn/Nhỏ: Phép Màu Ngay Trên Desktop

- Inference LLM local: Không chỉ các doanh nghiệp lớn, startup Việt cũng có thể vận hành mô hình ngôn ngữ multimodal với dữ liệu tuyệt đối riêng tư. Không còn nỗi sợ dữ liệu bị leak ra cloud.

- Tối ưu hóa tự động theo thế hệ phần cứng: Benchmark model, auto fine-tuning – không còn cảnh tuning thủ công mất cả tuần. Bạn chỉ cần chọn model, hệ thống sẽ tối ưu theo phần cứng hiện có.

Ví dụ, một doanh nghiệp tài chính triển khai hệ thống chatbot nội bộ, chỉ với Windows AI Foundry, họ vận hành mô hình LLM hoàn toàn local, bảo mật và compliance đạt tiêu chuẩn quốc tế.

4. Bảo Mật Dữ Liệu Tuyệt Đối, Phù Hợp Mọi Ngành Nghề

Ở các ngành dọc như: tài chính, healthcare, chính phủ (vốn cực nhạy cảm về dữ liệu), Foundry Local trở thành bảo chứng với:

- Không gửi dữ liệu raw ra ngoài: Toàn bộ quy trình inference, training model diễn ra local.

- Hỗ trợ quy định gắt gao: GDPR, CCPA, HIPAA…

- Dễ kiểm tra log, audit mọi tác vụ AI, thuận tiện cho báo cáo compliance.

III. Danh Sách CPU, GPU, NPU Tương Thích Foundry Local: Cách Chọn Hạ Tầng Chuẩn

Muốn AI chạy trơn tru trên Windows, phần cứng là yếu tố sống còn! Vậy chọn CPU, GPU, NPU ra sao để tối ưu hiệu suất nhưng không… cháy ví?

1. Bảng Đối Chiếu CPU, GPU, NPU – Bạn Đã Chọn Đúng “Vũ Khí”?

Alt: Bảng tương thích phần cứng Windows AI Foundry Local

| Thiết bị | Chip hỗ trợ chính | Lợi ích nổi bật |

| ————- | ——————————————- | ———————————— |

| CPU | Intel Core 13th/14th Gen, AMD Ryzen 7000 | Phổ biến, ổn định, tiết kiệm chi phí |

| GPU | NVIDIA RTX 30/40, AMD Radeon RX 7000 | Tăng tốc batch large/LLM nhanh nhất |

| NPU | Qualcomm SQ3, Intel AI Boost, MediaTek | Tiết kiệm điện, AI edge/di động |

2. Hướng Dẫn Kiểm Tra & Bí Quyết Tối Ưu Phần Cứng

- Kiểm tra phần cứng chỉ với CLI: Chạy

foundry local devicesđể “vạch mặt” mọi loại phần cứng hỗ trợ tăng tốc trên máy của bạn. - Luôn update driver cho AI: Cài bản mới nhất của DirectML, driver GPU/NPU, ONNX runtime! Chỉ một bản cũ cũng đủ kéo hiệu năng xuống không tưởng.

- “Đo ni đóng giày” theo workload:

- Lượng inference lớn (batch, LLM): Hãy đầu tư GPU “khủng” như NVIDIA RTX 30/40, AMD RX 7000.

- AI real-time (hình ảnh, voice, streaming): Lựa NPU càng mới càng tốt!

- Nhu cầu tiết kiệm pin, load vừa: CPU Intel 13th/14th Gen hoặc Ryzen 7000 vẫn cực kỳ ổn định.

Mẹo chọn phần cứng thực chiến

- Xử lý hình ảnh/model LLM nặng: Chọn laptop/PC có GPU mới nhất, RAM tối thiểu 16GB (tốt nhất là 32GB cho bền bỉ, đa nhiệm).

- AI edge/IoT: Ưu tiên ARM-laptop hoặc tablet tích hợp NPU + pin từ 60Wh trở lên, đáp ứng AI on-the-go.

- Doanh nghiệp chuyên AI: Đầu tư workstation nhiều slot GPU/NPU, hỗ trợ DirectML để mở rộng không giới hạn.

3. Mở Rộng Khả Năng Tương Thích: Xài Windows Là Có AI!

- Dù bạn dùng máy bàn, laptop, tablet hay các thiết bị IoT – chỉ cần Windows và vài lệnh CLI, bạn đã “activate” nền tảng AI Foundry local.

- Hàng loạt doanh nghiệp tại Việt Nam đã state-of-the-art hệ thống AI với duy nhất một stack: Windows + Foundry Local + phần cứng chính xác, tiết kiệm cả trăm triệu đồng chi phí cloud.

IV. Mở Rộng Sức Mạnh: Tích Hợp Azure AI & Hệ Sinh Thái Microsoft Toàn Diện

Bạn băn khoăn, chỉ AI local thì làm sao kịp xu thế? Đừng lo, Windows AI Foundry còn cho phép bạn phối hợp sức mạnh cloud cực lẹ!

1. Azure AI – Model Catalog: Kết Nối “Vũ Trụ” AI Toàn Cầu

Alt: Minh họa tích hợp hệ sinh thái Windows AI Foundry

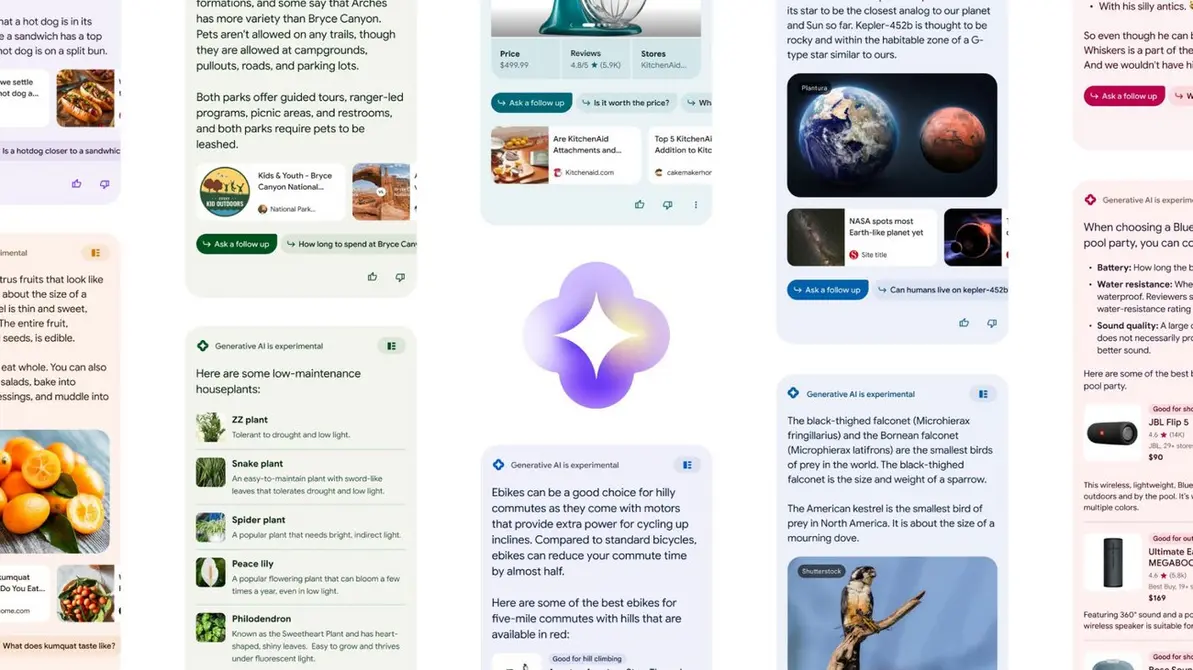

Những điểm cộng khiến cộng đồng phát triển quốc tế cũng phải “trầm trồ”:

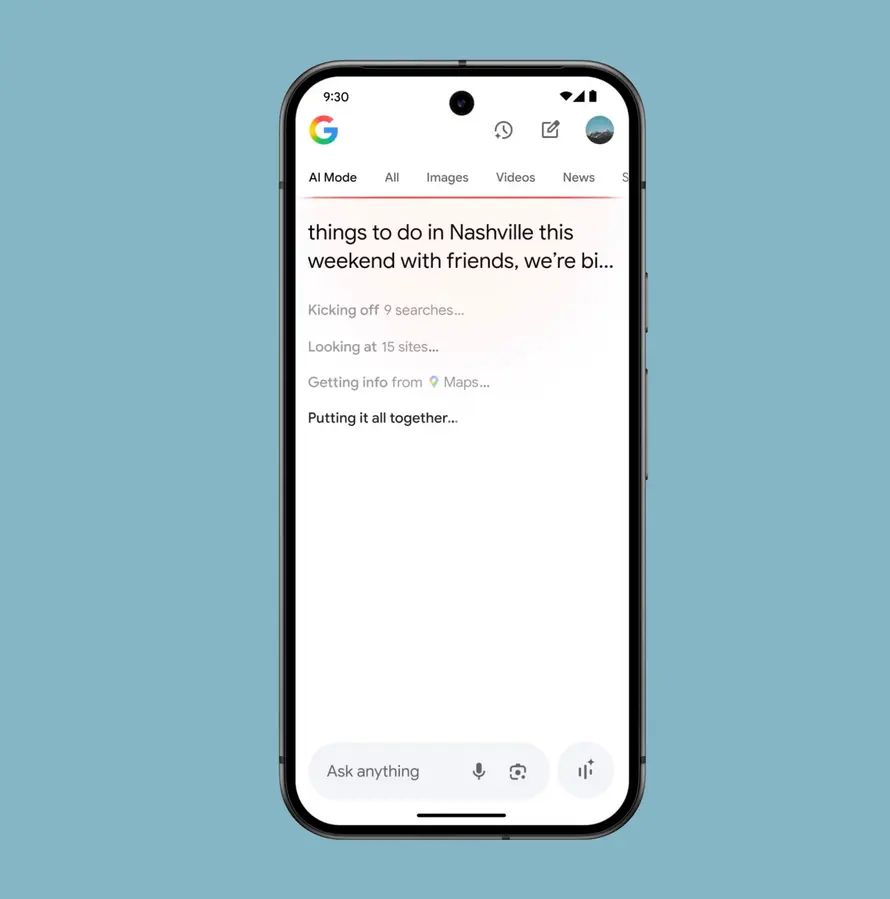

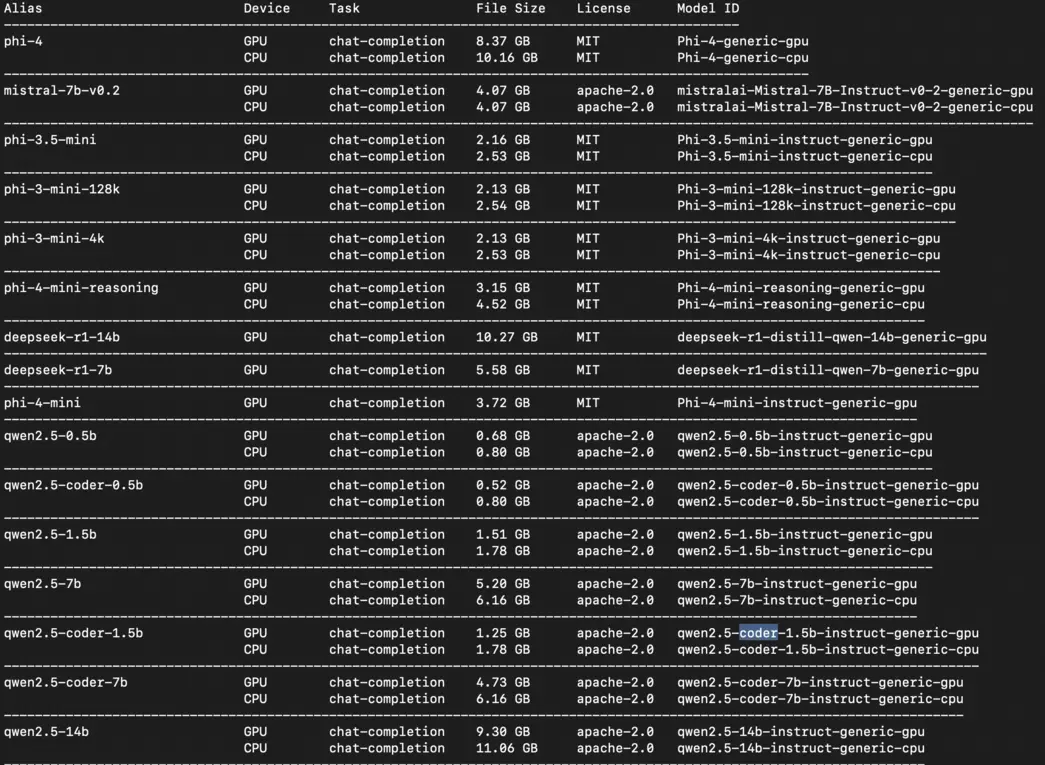

- Kết nối trực tiếp Azure AI: Lôi về – thử thử – dùng thật ngay hàng trăm mô hình SOTA (state-of-the-art) từ model catalog Azure, liên tục cập nhật.

- Tích hợp dịch vụ bổ trợ: Azure Cognitive Services, Azure Machine Learning, DataOps pipelines hoạt động trơn tru, sẵn sàng mở rộng bất cứ lúc nào.

- Cộng đồng quốc tế update 24/7: Chủ động follow các forum, developer group… tiếp nhận tính năng mới không chỉ của Microsoft mà còn các partner chiến lược.

- Dễ dàng đồng bộ – chia sẻ Model: Bạn hoàn toàn có thể “phát hành” model cho teammate, đối tác, hoặc public trên Microsoft Store/các catalog chuyên biệt.

2. Đột Phá Đồng Bộ Hệ Sinh Thái, Tăng Sức Sáng Tạo

- Quá trình go-to-market rút ngắn tới 60% nhờ combo sức mạnh local + cloud.

- Luôn chớp trend làng AI nhờ sự đồng bộ tuyệt đối giữa Azure và hệ sinh thái Windows.

- “One sync – forever growth”: Một lần tích hợp, mở rộng vô hạn, không bị bỏ rơi vào bẫy vendor-lock như nền tảng độc quyền cũ.

Ví dụ thực tế: Nhiều tổ chức tài chính lớn tại Mỹ triển khai cùng lúc các giải pháp AI áp dụng nội bộ lẫn cung cấp api cho đối tác, nhờ vào sự phối hợp quá mượt mà giữa Windows AI Foundry và Azure AI.

V. Hướng Dẫn Thực Tế: Vận Hành SDK / CLI & Checklist Quy Trình Chuẩn

Chinh phục Foundry không chỉ là chuyện kiến trúc, phần cứng. Chính trải nghiệm dev mới là thứ khiến hàng ngàn lập trình viên “ngả mũ”!

1. Quy Trình Vận Hành SDK/CLI: Dev Mượt Từ Local Đến Release

Alt: Quy trình thao tác SDK CLI trên Windows AI Foundry

Hệ sinh thái Windows AI Foundry cung cấp toàn bộ bộ lệnh chuẩn, tự động hóa hầu hết thao tác, giúp bạn build – test – deploy AI model chỉ với vài dòng CLI hoặc tích hợp CI/CD.

Checklist thao tác phổ biến:

- Liệt kê model có sẵn trong catalog:

foundry model list --source catalog --filter "vision" - Chạy thử nghiệm model tại máy (local):

foundry model run --model vi-qa --input demo.text - Triển khai model cho workflow thực tế:

foundry model deploy --target myapp --env local

Tăng tốc từ việc thử nghiệm nhỏ cho tới bring-to-production chỉ trong… giờ hoặc thậm chí phút!

2. Best Practices: Ổn Định, Bảo Mật, Tracking Chuẩn Chỉnh

- Chọn model từ source uy tín: Đảm bảo model clean, có audit, tránh các vấn đề về bản quyền hay “backdoor”.

- Kích hoạt đa tầng bảo mật: Role-based access cho mọi thao tác; bật multi-factor authentication để hạn chế nguy cơ rò rỉ.

- Audit, logging xuyên suốt: Lưu log CLI, kiểm tra lịch sử tác vụ AI, luôn sẵn sàng làm việc với compliance team.

- Tích hợp tự động với DevOps: Script hóa kiểm thử bảo mật (security, rollback…), liên tục validate môi trường qua CI/CD GitHub.

3. FAQ & Mẹo Thực Tiễn Dành Cho Dev/Doanh Nghiệp

- Có tích hợp SDK vào app Win/Edge, code chuẩn Python/C#/JS không?

→ “Quá dễ!” – Windows AI Foundry hỗ trợ API bindings, mẫu code đầy đủ, chỉ việc nhúng và xong. - Gặp lỗi model, rollback dễ không?

→ Sử dụng CLI cho phép rollback version “snap” kiểu Git, không sợ downtime dài.

Ngoài ra, bạn có thể tham khảo các tài liệu thực chiến trên forum quốc tế: theo báo cáo Stack Overflow Developer Survey năm 2024, hơn 35% developer lựa chọn tích hợp CI/CD và rollback sớm để giảm thiểu downtime của sản phẩm AI.

VI. Góc Nhìn Chuyên Gia: Tương Lai AI Doanh Nghiệp Windows – Khi Nền Tảng Là Sức Mạnh

Có thể bạn vẫn tò mò: So với giải pháp cũ, Foundry local mang lại đột phá thực tế nào?

1. AI Local – “Vũ Khí 3 Trong 1” Cho Doanh Nghiệp

- Chủ động kiểm soát toàn bộ quy trình AI: Từ phát triển tới vận hành – dữ liệu, source code, model luôn trong tầm tay tổ chức.

- Mở rộng linh hoạt, không phụ thuộc vendor: Dễ dàng nâng cấp, scaling đội ngũ phát triển, không phải vướng víu hạ tầng “ngoại lai” hoặc phí bản quyền khổng lồ.

- Tiết kiệm chi phí & bảo mật cục bộ: Không tốn tiền gửi dữ liệu ra ngoài, kiểm soát compliance nhẹ nhàng hơn.

2. Phản Hồi Thực Tế Từ Cộng Đồng Công Nghệ

- “Foundry đổi mới hoàn toàn môi trường làm việc AI, làm doanh nghiệp dễ dàng kiểm soát, tiết kiệm và an tâm hơn rất nhiều.” – CTO một công ty startup AI Hà Nội.

- Theo báo cáo Microsoft 2025: 40% team AI đã cắt giảm được trên 30% thời gian phát hành tính năng mới nhờ dùng bộ công cụ CLI của Foundry.

Ở góc độ vận hành, một doanh nghiệp ở ngành bán lẻ lớn của Việt Nam ứng dụng Windows AI Foundry để tối ưu hệ thống phân tích hành vi khách hàng: họ đã rút ngắn 1/2 thời gian xây dựng và triển khai pipeline AI, gấp rút ra mắt chương trình cá nhân hóa chỉ trong 2 tháng, thay vì 6 tháng như trước.

3. Đề xuất tiếp theo để “bứt phá” AI doanh nghiệp

- Đổi mới quản trị dữ liệu/công nghệ bằng nền tảng AI tiên tiến?

- Theo kịp “trend” AI cloud + local, đảm bảo chuyển đổi số an toàn năm 2025?

Đăng ký newsletter, hoặc tham gia ngay Cộng Đồng AI Automation Club by MCB AI (link cuối bài).

VII. Kết Luận: Windows AI Foundry – Bệ Phóng Lý Tưởng Cho Doanh Nghiệp AI Định Hướng Tương Lai

Tạm kết:

Windows AI Foundry thực sự mở ra chương mới trong cuộc chiến AI toàn cầu, biến mọi thiết bị Windows trở thành bệ phóng AI local đầu bảng: nhanh – an toàn – tối ưu. Từ kiến trúc module hóa, engine ONNX Runtime “gắn chip” local tối đa, cho đến tính năng mở rộng xuyên suốt Azure AI, kèm bộ công cụ SDK/CLI tiện dụng – mọi người dùng, doanh nghiệp giờ đây đều có thể tự tin làm chủ vòng đời phát triển AI, kiểm soát dữ liệu, giảm chi phí và tăng tốc sản phẩm lên thần tốc.

Bạn muốn doanh nghiệp lên tầm AI-first real-time năm 2025? Đừng đứng ngoài cuộc! Tận dụng sức mạnh Foundry từ hôm nay, trải nghiệm AI an toàn, chủ động và đồng bộ cùng hệ sinh thái Microsoft.

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa?

Nếu bạn thực sự yêu thích AI, Automation, workflow thông minh, MMO hay affiliate marketing, đây chính là cộng đồng không thể thiếu trong danh sách “must-join”. Tại đây, bạn sẽ cập nhật những xu hướng nóng hổi nhất, chia sẻ kinh nghiệm, cùng nhau chí tiến thủ lĩnh vực tự động hóa, tối ưu quy trình công việc với loạt công cụ mạnh mẽ bậc nhất hiện nay. Đừng chần chừ – cùng tôi “hòa vào thế giới AI thực chiến”: AI AUTOMATION CLUB