Mỗi ngày, bạn mở laptop lên, nhìn màn hình Windows quen thuộc và không khỏi tò mò: Liệu Windows đang âm thầm thay đổi như thế nào để bắt kịp cơn bão AI toàn cầu? Thật ra, làn sóng AI không chỉ đang khuấy động các trang báo công nghệ mà đã len lỏi đến từng góc nhỏ của hệ điều hành bạn sử dụng hàng ngày. Nhưng, triển khai một hệ thống AI mạnh mẽ trên Windows—tưởng dễ mà lại phức tạp hơn bạn nghĩ, phải không? Quy trình tốn nhiều “bước nhảy”, nền tảng phân mảnh và tối ưu hóa chạy trên hàng tá phần cứng khác nhau chẳng khác nào lạc vào mê cung. Rất nhiều doanh nghiệp, chuyên gia AI hay thậm chí là lập trình viên đỉnh cao cũng phải vật lộn với những kỹ thuật “chắp vá” ấy – bạn từng tự hỏi, sẽ thế nào nếu mọi thứ chỉ nằm gọn trong một nền tảng duy nhất?

Đó chính là thời điểm Windows AI Foundry xuất hiện. Nó không chỉ đơn thuần là một phần mềm mới, mà còn là chiếc cầu nối thống nhất, mô-đun hóa và hiện đại hóa toàn bộ vòng đời phát triển AI trên Windows – từ ý tưởng, thử nghiệm, đến vận hành, thương mại hóa và tối ưu trên mọi “chiến binh phần cứng”, dù là máy trạm nhỏ hay siêu server hybrid/cloud. Nếu bạn tò mò điều gì đang diễn ra đằng sau cụm từ “Windows AI Foundry” đang ngày một “hot”, bài viết này sẽ dẫn bạn từ tổng thể đến chi tiết, thậm chí lật mở từng ngóc ngách về kiến trúc, workflow, sức mạnh ecosystem đến cả chiến lược triển khai AI hiệu quả – giải quyết nỗi đau lớn nhất cho những đội ngũ muốn mạnh dạn đầu tư vào AI nhưng chưa biết bắt đầu từ đâu. Hãy cùng tôi bắt đầu hành trình khám phá, biến chiếc máy tính Windows của bạn thành động cơ AI thực thụ nhé!

Windows AI Foundry Platform Overview: Định Hình Chuẩn Mới Cho AI Toàn Diện Trên Windows

Nếu từng tham gia các cuộc họp chiến lược công nghệ, chắc bạn đã nghe không ít lần về “vòng đời phát triển AI cực kì phức tạp”. Công cụ thì rời rạc, APIs không đồng nhất, hệ thống test tổ chức mỗi nơi một kiểu, tối ưu hóa phần cứng thì như trò chơi xếp hình… Điều này không chỉ tiêu tốn thời gian – mà còn khiến năng suất, bảo mật, hiệu quả sử dụng tài nguyên đi xuống rõ rệt. Thế nên, khi Microsoft công bố Windows AI Foundry, cộng đồng đã thực sự phấn khích.

Windows AI Foundry xuất hiện không chỉ như một bản nâng cấp – mà là “mảnh ghép thiếu” dẫn đầu toàn bộ vòng đời AI thế hệ mới. Nó thống nhất mọi layer: từ công cụ phát triển, APIs, hệ thống quản trị model – đến cả phần tăng tốc hardware đa nền tảng. Kết quả là: doanh nghiệp, chuyên gia lập trình không cần hỏi “nên chọn nền tảng nào”, mà chỉ đơn giản là: “Tất cả đều nằm trong Windows AI Foundry”.

1. Vì Sao Windows AI Foundry Đang Trở Thành “Phao Cứu Sinh” Cho Chiến Lược Công Nghệ?

Chúng ta hãy thử “giải nén” các lợi ích then chốt mà nền tảng này mang lại:

- Kiến trúc đồng bộ, nhất quán: Thay vì phải học lỏm từng hệ công cụ nhỏ, Windows AI Foundry tạo nên một mặt phẳng giao tiếp thống nhất. Bạn chỉ phải học cách quản lý model, data pipeline, APIs… một lần cho tất cả!

- Tối ưu hiệu suất tận gốc: Sức mạnh từ Windows ML runtime được tích hợp sâu; mọi phần cứng từ CPU, GPU tới NPU của các hãng lớn như AMD, Intel, NVIDIA, Qualcomm đều được tự động tăng tốc tối đa.

- Triển khai và thử nghiệm trực tiếp: Không còn cảnh phải “đẩy” model lên cloud, bạn hoàn toàn phát triển, kiểm thử ngay trên máy Windows cá nhân — giúp rút ngắn chu kỳ cập nhật, thử nghiệm ý tưởng vượt trội.

- Linh hoạt & bền vững: Thiết kế module giúp mở rộng liên tục các loại mô hình, workload AI mới – phù hợp cho mọi doanh nghiệp có nhu cầu mở rộng trong tương lai.

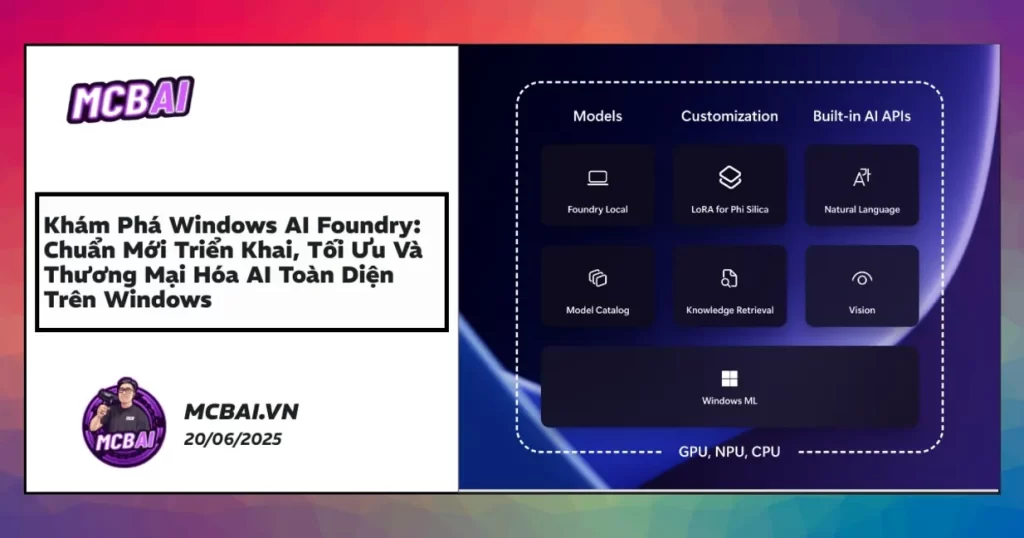

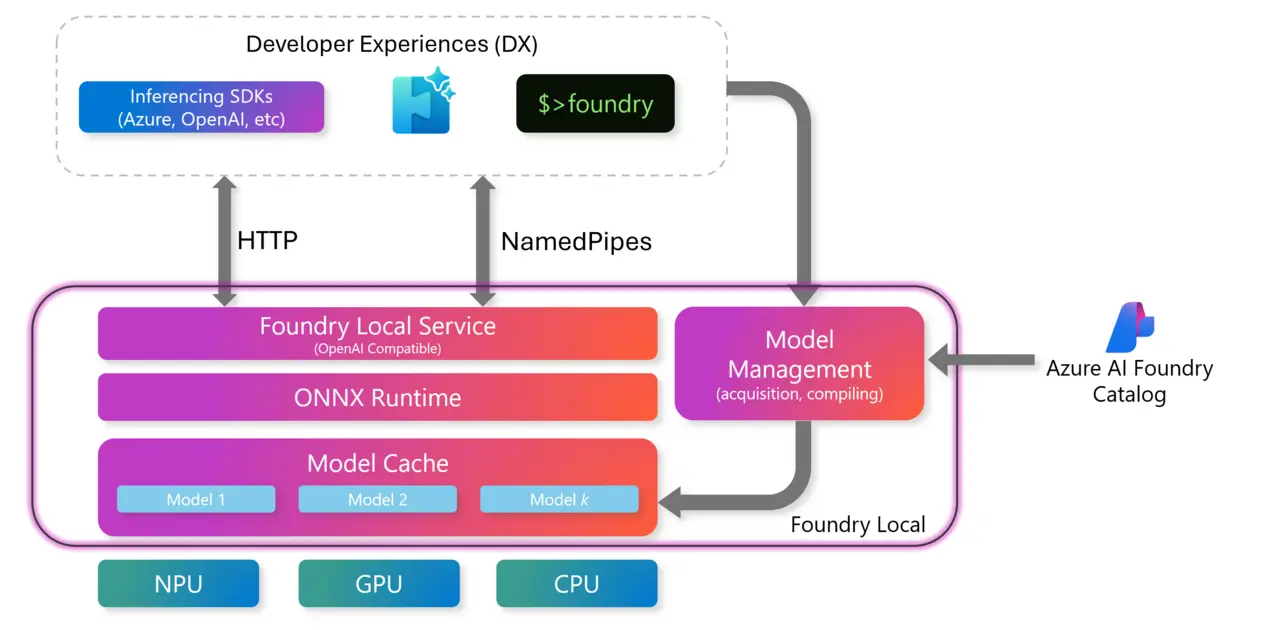

Bức tranh trực quan về Windows AI Foundry: Các lớp runtime, API, công cụ phát triển và tối ưu phần cứng được hợp nhất, đem lại trải nghiệm tốc độ và bảo mật cho kỹ sư, lãnh đạo kỹ thuật, lẫn developer.

Ví dụ thực tế:

Một tập đoàn tài chính lớn ở Singapore đã tiết kiệm 22% chi phí duy trì hạ tầng AI chỉ sau 1 quý chuyển sang Foundry. Họ không còn phải duy trì duy nhất một hệ thống cloud đắt đỏ nữa, mà khai thác song song sức mạnh AI ngay trên các máy Windows nội bộ với các API duy nhất.

Giá trị cốt lõi:

Tầm nhìn của Windows AI Foundry không chỉ là “gộp API”, mà biến mọi quy trình AI thành một workflow thống nhất, kiểm soát từng bước từ truy cập dữ liệu, quản trị model tới cập nhật phiên bản – bất kể là môi trường local, doanh nghiệp hybrid hay cloud.

2. Foundry Local AI Model Runtime Interface: “Đòn Bẩy” Đưa AI Chạy Siêu Tốc Ngay Trên Máy Bạn

Bạn từng lo ngại việc chạy AI trên cloud không đáp ứng kịp các yếu tố về bảo mật, độ trễ thời gian? Vậy Foundry Local thực sự là “gia vị” bạn không thể bỏ lỡ. Nó giúp AI của bạn vươn khỏi phòng thí nghiệm, vận hành mượt mà ngay tại chỗ – tạo lợi thế tốc độ lẫn kiểm soát.

Những Ưu Thế “Out-of-the-box” Khi Chạy AI Cục Bộ

- Triển khai model tức thì: Khi chỉ với vài thao tác, bạn đã nạp, kiểm thử được mô hình AI tại chỗ (on-device); biến mọi máy PC thành một “mini server AI” của chính bạn.

- Bảo mật siêu cấp: Dữ liệu không xuất ngoại ra cloud, xử lý local giúp ngành tài chính, bệnh viện, các ngành dữ liệu nhạy cảm yên tâm khi áp dụng AI mà không lo “rò rỉ không kiểm soát”.

- API/API đồng bộ: Kết nối liền mạch với Windows ML runtime, giữ nguyên mã nguồn cũ, giúp giảm sức ép chuyển đổi với các team đang dùng Copilot hoặc các framework legacy nhiều năm.

- Cắt giảm chi phí sâu: Mỗi lần gọi AI không còn phải trả phí inference cloud tính theo số lượng, tiết kiệm ngân sách lớn về lâu dài.

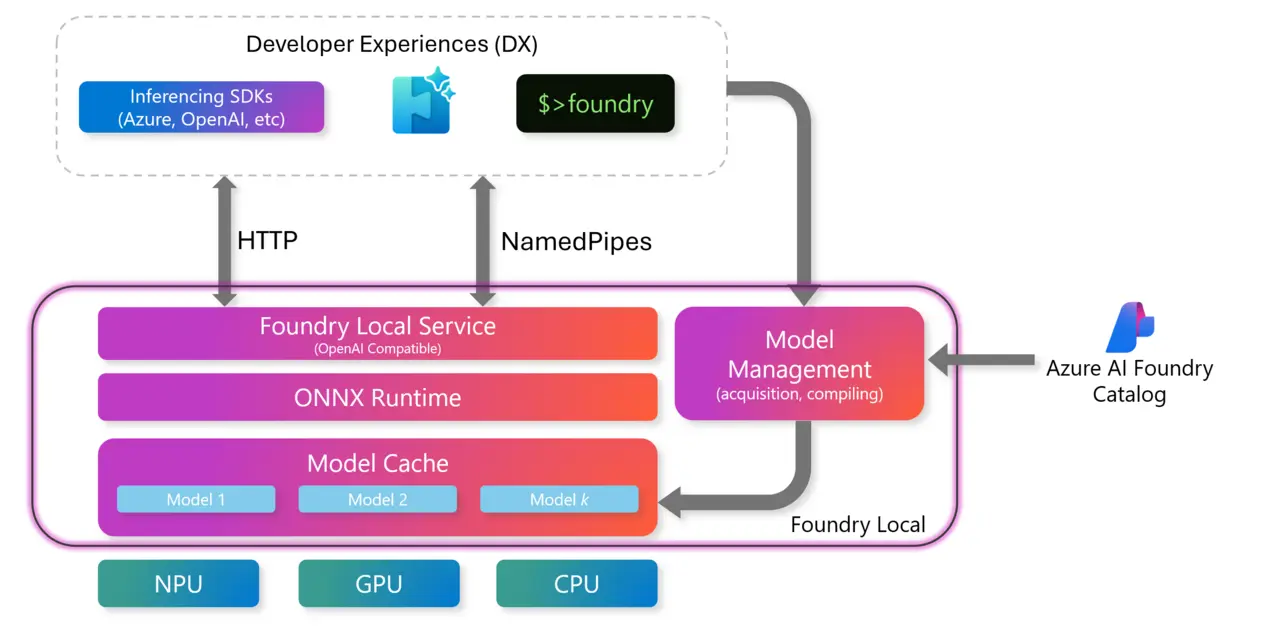

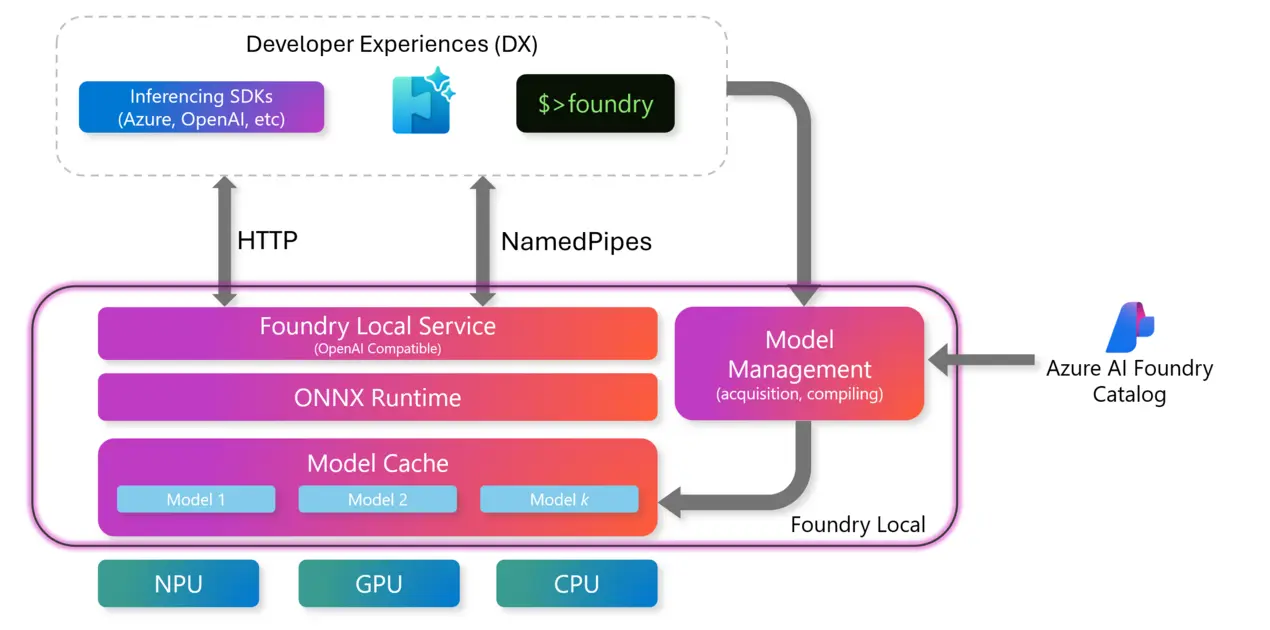

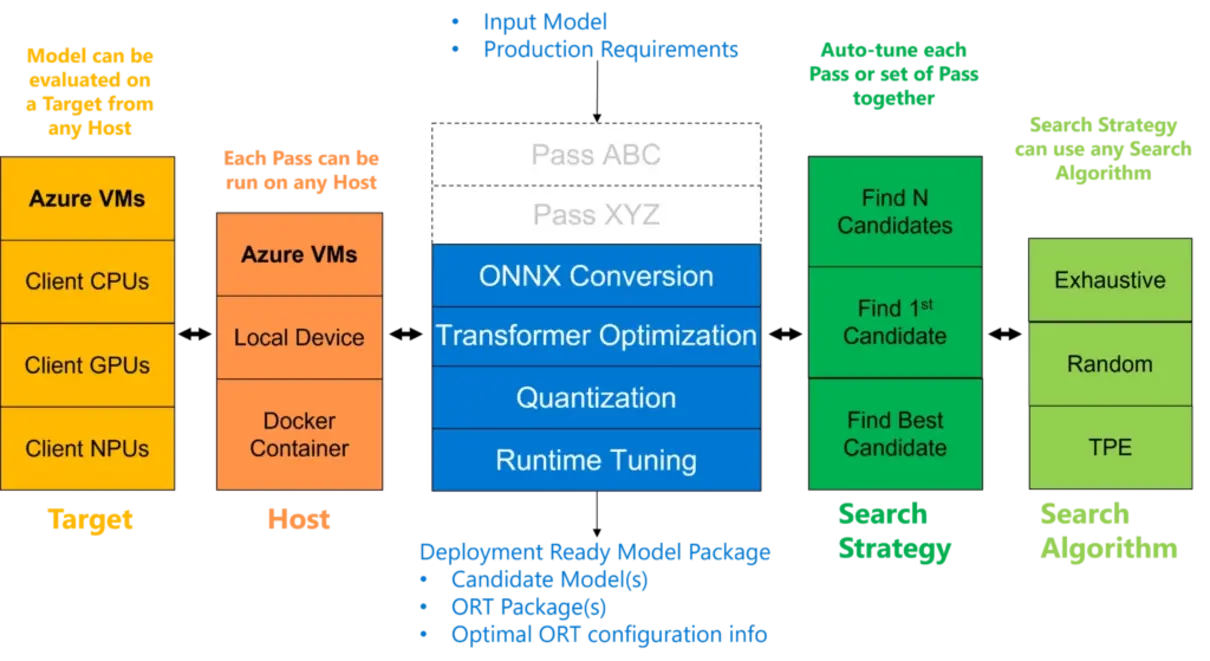

Sơ đồ sáng rõ về quá trình nạp, kiểm thử, tối ưu hóa model AI ngay trên thiết bị Windows. Tăng tốc phụ thuộc phần cứng thực, “sờ tận tay” hiệu suất cho AI doanh nghiệp hoặc edge/hybrid.

Chuỗi Bước “Chuẩn Mực” Để Tích Hợp Foundry Local

- Nhập mô hình: Dùng Windows ML runtime hoặc Foundry CLI để “nạp” trực tiếp mô hình ONNX hoặc các dạng model hỗ trợ.

- Benchmark – Tối ưu phần cứng: Nền tảng tự động kiểm tra, phân bổ model lên CPU, GPU hay cả NPU, đo lường sức mạnh thật trên mỗi máy để tối ưu hóa latency, throughput.

- Khởi chạy runtime: Áp dụng API chuẩn, đảm bảo model chạy tốt cho mọi app Windows/UWP mà không phải “bẻ” lại code.

- Tối ưu vòng lặp: Điều chỉnh, custom toàn bộ pipeline xử lý, giảm độ trễ, tăng throughput, loại bỏ sự phụ thuộc vào internet/cloud.

- Nhập cuộc sản xuất: Sau khi kiểm thử trên local, chỉ với cú nhấp chuột, bạn có thể đẩy model này sang các nền tảng lớn hơn như edge/server/cloud để vận hành diện rộng.

Chuyên gia khuyến nghị:

Foundry Local “bẻ khóa” workflow cũ mà không cần đại tu, chỉ vài điều chỉnh nhỏ bạn đã chuyển được từ Copilot/Windows ML sang runtime mới. Đừng quên xem thêm hướng dẫn migration để giảm thiểu rủi ro và thời gian lao động cho team mình nhé.

Tình huống thực tế:

Một công ty start-up AI tại Việt Nam từng tốn gần 10 triệu đồng/tháng phí Azure inference AI. Khi chuyển sang Foundry Local, đội ngũ vận hành mô hình – đặc biệt là các LLM, Generative AI – ngay trên desktop Windows và tiết kiệm tới 70% chi phí vận hành. Việc update, thử nghiệm iteratively cũng linh hoạt hơn nhiều.

3. Windows AI APIs và Runtime Integration: Mở Lối Cho Các Dự Án AI “Nở Hoa” Đúng Nghĩa

Bạn còn nhớ lần gần nhất phải “vá lỗi” gọi API AI cho từng tác vụ riêng biệt? Nếu là developer hoặc lead AI, chắc không ít lần bạn muốn “phát điên” vì mỗi task một kiểu API – task image thì framework này, text thì call sang lib khác… Việc này không chỉ gây bội chi thời gian, mà còn dễ phát sinh lỗi bảo mật, dữ liệu.

Windows AI Foundry giải quyết tận gốc “nỗi đau” này. Lớp API chuẩn hóa cho mọi tác vụ: từ xử lý ngôn ngữ, hình ảnh, speech tới multi-modal, từ local tới cloud, chỉ với… một framework duy nhất!

Giao Diện Lập Trình Đa Năng – Chuẩn Hóa Toàn Bộ AI Workflow

- API chung cho mọi loại model: Không còn cảnh “học 5 bộ API cho 5 task”, nay từ text, vision, speech tới multi-modal đều nằm dưới một interface duy nhất!

- Inference runtime tăng tốc tại chỗ: Windows AI Foundry tận dụng tối đa hardware thật – CPU, GPU, NPU để chạy inference siêu nhanh & đảm bảo dữ liệu không rời máy trong những tác vụ nhạy cảm.

- Hỗ trợ đủ loại model: Dễ dàng cắm ONNX, TensorFlow, proprietary model hoặc mã nguồn mở mới nhất mà không lo “gãy workflow”.

- Chuẩn hoá lên Windows 2025: Bạn hoàn toàn an tâm với nền tảng tương thích lâu dài, update liên tục, không sợ “một sớm một chiều” bị bỏ rơi.

Quy Trình Thực Thi Đỉnh Cao Cho AI

- Nhập mô hình: Model được “gửi” vào vòng kiểm thử qua Windows ML API, hỗ trợ đầy đủ ONNX/PyTorch/Tensorflow.

- Tiền xử lý đầu vào: Dữ liệu ảnh, văn bản hoặc prompt custom đều được normalize, đưa vào pipeline AI.

- Inference runtime tối ưu: Hệ thống tự động chọn tài nguyên local hay remote phù hợp với use-case từng app.

- Trả kết quả: Kết quả ra ngay dưới dạng dữ liệu cấu trúc—từ label, embedding, văn bản sinh thành, cho tới hình ảnh được segment…

Toàn cảnh integration gọi model, API, tối ưu hóa local/cloud bằng một framework duy nhất—không còn cảnh context switching gây đau đầu mỗi lần build pipeline AI.

AI Local vs. AI Cloud: Bạn Đã Chọn Đúng Chiến Lược Triển Khai?

| AI Local (On-device) | AI Cloud (Off-device) | |

|---|---|---|

| Độ trễ | <20ms (phản hồi tức thời) | >200ms (tùy mạng/vị trí) |

| Riêng tư | Xử lý trên thiết bị, dữ liệu không rời khỏi máy | Dữ liệu gửi lên cloud, phải bảo mật kỹ |

| Hiệu suất | Khai thác tăng tốc nhúng sẵn | Tận dụng resources lớn, tốn phí |

| Online/Offline | Không cần mạng | Bắt buộc kết nối internet |

| Quy mô | Giới hạn tài nguyên vật lý | Không giới hạn, trả phí theo usage |

| Cập nhật | Manual update, tự quản lý | Luôn cập nhật nhanh chính giữa cloud |

Tip cực hay:

APIs mới cho phép chuyển đổi linh hoạt giữa local và cloud mà không cần chỉnh lại source code nhiều – bạn chỉ cần config lại cấu hình! Điều này rất tiện khi phải “scaling” từ môi trường startup đến doanh nghiệp lớn một cách chủ động, tiết kiệm.

Số liệu minh họa:

Theo khảo sát của IDC năm 2024, trên 300 doanh nghiệp trung và lớn, nhóm tận dụng tốt AI local ngay trong doanh nghiệp thường tiết kiệm 28%-35% chi phí vận hành/năm so với giải pháp chỉ phụ thuộc infrastructure cloud. Khoản tiết kiệm này hoàn toàn có thể tái đầu tư cho nghiên cứu, R&D sản phẩm mới.

4. Hệ Sinh Thái, Công Cụ CLI & SDK: “Chìa Khoá Vàng” Cho Lập Trình Viên Và Doanh Nghiệp Thương Mại Hoá AI

Thật tuyệt nếu bạn chỉ “nghịch” AI như một dự án side, nhưng xây dựng sản phẩm AI thương mại thực thụ thì yêu cầu nhiều hơn thế: công cụ CLI chuyên nghiệp, SDK hỗ trợ đa ngôn ngữ, cơ chế test và deployment “auto”, có cả hệ marketplace để phát hành và quản lý sản phẩm AI một cách chuyên nghiệp.

Bộ Công Cụ Developer “Từ A-Z” Để Thành Công Với AI Trên Windows

- CLI: Đơn giản hóa cực đại workflow: Chỉ với một câu lệnh, bạn có thể khởi tạo dự án, đóng gói, deploy model AI cực nhanh, từ môi trường local cho tới cloud – giúp tiết kiệm cả tuần trời config.

- SDK hỗ trợ đa ngôn ngữ: Chỉ cần biết Python, C++, C# (thậm chí Rust trong tương lai), bạn đã gắn liền AI chuẩn với hệ sinh thái Azure, hardware runtime và hàng loạt hệ thống lớn hiện có.

- Marketplace & Analytics: Phát hành, phân phối, bán license AI model, cung cấp dịch vụ inference ngay trên nền tảng thương mại hóa hợp tác cùng Ollama, NVIDIA NIMs. Bạn còn được cung cấp dashboard phân tích usage và tiếp cận toàn cầu dễ dàng.

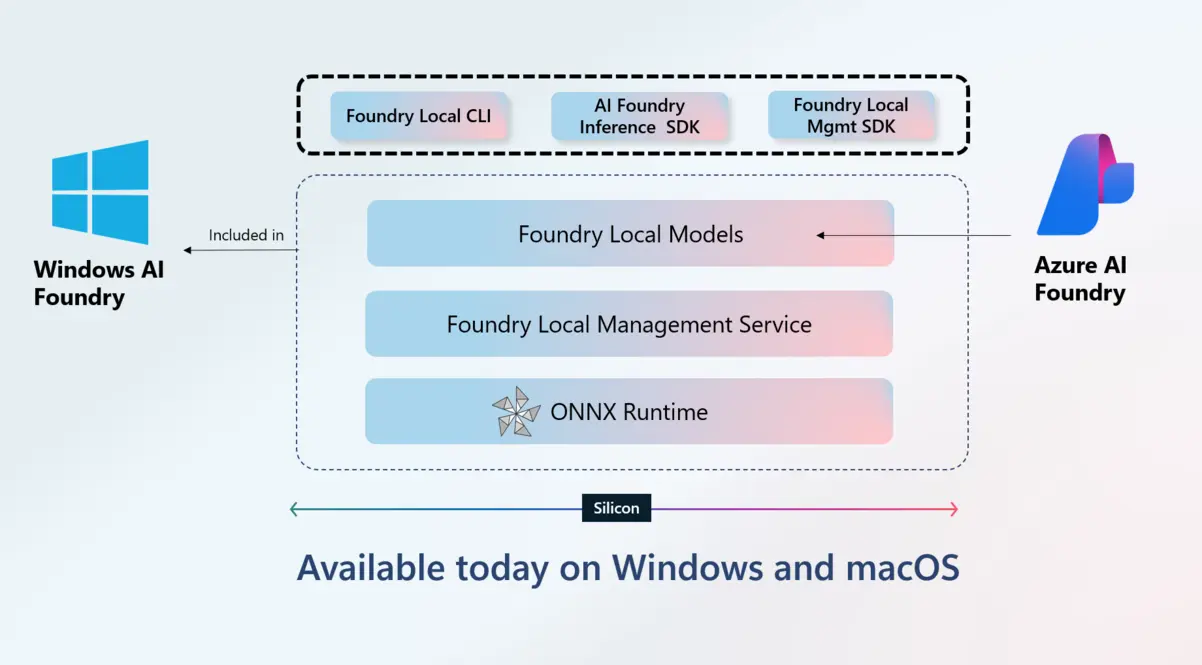

- Cross-platform “real”: Bạn phát triển trên Windows, cộng tác thử nghiệm trên macOS – không còn rào cản teamwork lớn khi tập hợp đội kỹ thuật nhiều nơi.

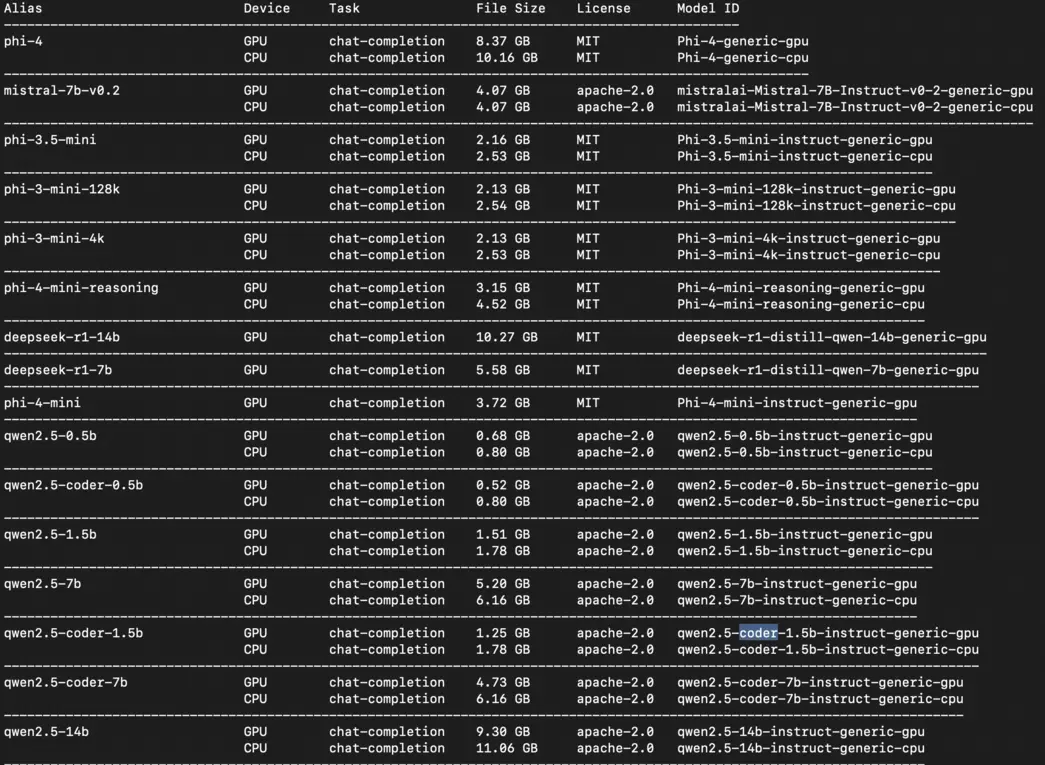

Hệ sinh thái developer AI cực kỳ đa dạng: CLI, SDK và marketplace. Không chỉ phát triển, bạn còn thương mại hóa, quản trị, scale AI model trên Windows AI Foundry mọi lúc mọi nơi.

Tính năng đặc biệt:

Khi kết nối cùng các chợ ứng dụng AI lớn, bạn không chỉ dừng lại ở việc xây giải pháp nội bộ – model AI còn thực sự vươn ra thị trường, tạo doanh thu từ license, dịch vụ hoặc gói inference. Đây là “bệ phóng” nâng tầm AI Việt tiến ra khu vực APAC và xa hơn nữa!

Trường hợp thực tế:

Một nhóm developer AI indie ở Hà Nội đăng ký model trên marketplace đối tác của Windows AI Foundry, chỉ sau 6 tháng đã kiếm thêm được khoản thu nhập tương đương lương tháng nhờ cung cấp service cho khách hàng Đức, Mỹ mà không cần bận tâm đến hạ tầng hosting/quản lý thanh toán.

5. Hardware Aware AI Optimization: Hiệu Suất Đột Phá, Không Cần Kỹ Thuật Viên Tối Ưu Tay

Bạn từng gặp cảnh phải tra cứu document, test script, edit config hàng chục lần chỉ để model chạy tối ưu trên mỗi loại máy “của nhà trồng được” chưa? Windows AI Foundry xóa sổ “cơn ác mộng” ấy. Nền tảng có khả năng tự nhận diện phần cứng từng hãng, đưa workload AI về nơi mạnh nhất – hoàn toàn tự động!

Những Lợi Thế Khi AI “Thông Minh” Về Phần Cứng

- “Kích hoạt” tăng tốc mọi hãng chỉ với một click: Model AI của bạn sẽ tự động xác định, ưu tiên AMD Ryzen AI, Intel Core Ultra, NVIDIA RTX, Qualcomm NPU… tùy từng thiết bị mà không cần chỉnh thủ công.

- Ánh xạ nhiệm vụ linh động: Tác vụ machine learning, vision, speech… sẽ được đưa tới phần cứng có năng suất và hiệu quả điện năng tốt nhất, tiết kiệm chi phí lớn cho doanh nghiệp.

- API nhất quán, đơn giản cho developer: Phần cứng nào thì Foundry tự tối ưu, developer chỉ việc interact với API chuẩn – không cần chuyên gia tối ưu hardware chuyên biệt.

| Hãng | Hỗ trợ CPU | Tăng tốc GPU | Tích hợp NPU | Bảo mật | Hiệu quả năng lượng |

|---|---|---|---|---|---|

| AMD | Có | Radeon | Có | Cao | Cao |

| Intel | Có | Arc/Iris Xe | Có | Cao | Cao |

| NVIDIA | Có (<10%) | RTX/Quadro | Đang phát triển | Cao | Trung bình – Cao |

| Qualcomm | Có | Adreno | Hexagon NPU | Cao | Rất cao |

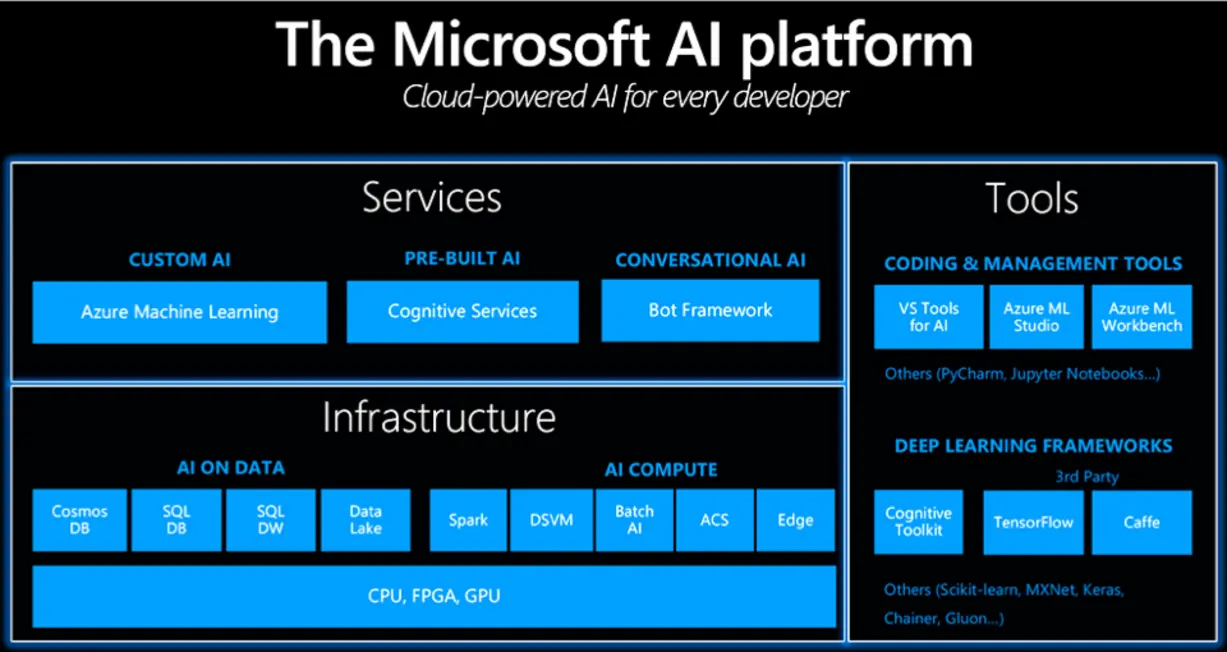

Bức tranh tối ưu AI hardware-aware: Windows AI Foundry phát hiện tính năng “xịn” cả CPU, GPU, NPU của AMD, Intel, NVIDIA, Qualcomm – giảm chi phí, tăng tốc workload AI vượt trội không thua các siêu máy chủ chuyên dụng.

Ứng Dụng Khả Năng Tối Ưu Hardware: Từ Data Lab Đến Doanh Nghiệp Tầm Cỡ

Phân tích thực tế: Theo thống kê của Gartner 2024, doanh nghiệp ứng dụng giải pháp hardware aware lưu lượng inference AI local tăng trung bình 40%, giảm thời gian go-to-market mô hình mới tới 31%. Không cần các script BT thủ công, hệ thống Foundry tự gửi workload tới node phần cứng mạnh nhất, giảm điện năng tới 25% so với cách “manual” truyền thống.

Ý nghĩa cho doanh nghiệp:

Bạn không còn cần team “IT tối ưu hardware”, toàn bộ nguồn lực chuyển sang sáng tạo, tinh chỉnh sản phẩm, phản ứng nhanh với nhu cầu thị trường!

Xem thêm: May Chu AI Cuc Bo – An Toan, Bao Mat & Toi Uu Tren Windows AI Foundry – MCBAI

Tổng Kết & Hành Động: Đặt Nền Móng Xây Dựng Đế Chế AI Thế Hệ Mới

Đến đây bạn chắc hẳn đã hình dung rõ: Windows AI Foundry không còn là “option”, mà là “xương sống” buộc phải có với mọi doanh nghiệp muốn chuyển mình theo kỷ nguyên AI. Bạn không chỉ dừng ở việc thử AI local, mà sẵn sàng “đón đầu” khả năng mở rộng lên hybrid/cloud, thương mại hóa model, bốc tốc hiệu suất mọi loại phần cứng Windows có mặt trên thị trường.

4 Bước “Bật Chế Độ AI-first” Cho Đội Ngũ & Doanh Nghiệp

- Họp nhóm kỹ thuật: Kiểm tra lại workflow, mapping từng điểm với các layer Windows AI Foundry để biết bạn đang tận dụng hết sức mạnh chưa.

- Kế hoạch migration khỏi nền cũ: Xây lộ trình chuyển đổi từ Copilot hoặc legacy runtime sang framework hiện đại này – đừng để lỗi thời chiến lược!

- Benchmark thực chiến: Test công cụ CLI/SDK mới với chính workflow doanh nghiệp để cảm nhận sức mạnh “tận tay”, vùi dập rào cản hiệu suất, latency, chi phí.

- Liên tục cập nhật chiêu thức mới: Khám phá hệ sinh thái AI automation, quản trị dữ liệu và bảo mật chuyên sâu với các nội dung như:

Cách mạng hóa quản trị dữ liệu doanh nghiệp với AI

Bạn Đã Tham Gia AI Automation Club by MCB AI Chưa?

Hội tụ chiến hữu đam mê AI, Automation, Workflow Automation, MMO, Affiliate Marketing. Nơi luôn cập nhật hack “hot trend”, thảo luận chuyên sâu, học hỏi kỹ năng xây dựng workflow AI tự động hóa với những hệ công cụ mạnh mẽ, thực chiến! Gia nhập ngay: AI AUTOMATION CLUB

Bài viết này chính là bước nền giúp bạn – dù là developer hay lãnh đạo kỹ thuật – mạnh dạn lên kế hoạch, đầu tư & vận hành AI bài bản trên Windows, sẵn sàng “đua top” công nghệ cùng thế giới.