Trước khi bước vào “toàn cảnh lỗ hổng an toàn AI 2025”, cần hiểu rằng chúng ta đang đối mặt với một làn sóng thay đổi công nghệ vừa khốc liệt vừa đầy rủi ro. Từ những sự kiện như xAI trì hoãn báo cáo an toàn, niềm tin công chúng lung lay, các quy chuẩn công nghệ liên tục bị đặt dấu hỏi, cho đến hệ lụy thực tế cho doanh nghiệp Việt Nam – tất cả đều không còn là cảnh báo lý thuyết mà là vấn đề sát sườn, liên quan trực tiếp đến hoạt động, đầu tư, và tồn vong trên thị trường AI. Dưới đây là bài phân tích tổng hợp, phân tách mọi góc độ từ dữ liệu, đánh giá hệ thống kiểm soát các “ông lớn” cho tới bài học, giải pháp thực thi mà tất cả cá nhân, tổ chức AI Việt cần khắc ghi và chủ động hành động ngay thời điểm này.

Toàn Cảnh Lỗ Hổng An Toàn AI 2025: xAI Safety Report Delay, Rủi Ro & Bước Chuyển Đổi Toàn Ngành

Industry-Wide AI Safety Concerns in 2025: Bức Tranh Lo Âu & Hệ Quả

Đỉnh điểm lo ngại an toàn AI: Khi bóng tối rủi ro bao trùm

Năm 2025, thế giới công nghệ bước vào một chương mới của những lo lắng xoay quanh trí tuệ nhân tạo. Cơn bão về niềm tin xuất hiện trên khắp các mặt báo: xAI Safety Report Delay – sự kiện xAI trì hoãn báo cáo an toàn – đã trở thành tiêu đề đầy sóng gió, đẩy ngành AI vào “vùng đỏ” của công luận lẫn quản lý nhà nước. Và mọi thứ không còn là lý thuyết! Cứ như thể, bức tranh năm nay được vẽ nên bởi những gam màu u ám của các vụ lỗi AI, rò rỉ dữ liệu, vấn nạn thiên lệch thuật toán, sự cố kiểm soát kém… tất cả ngày một tăng nhanh.

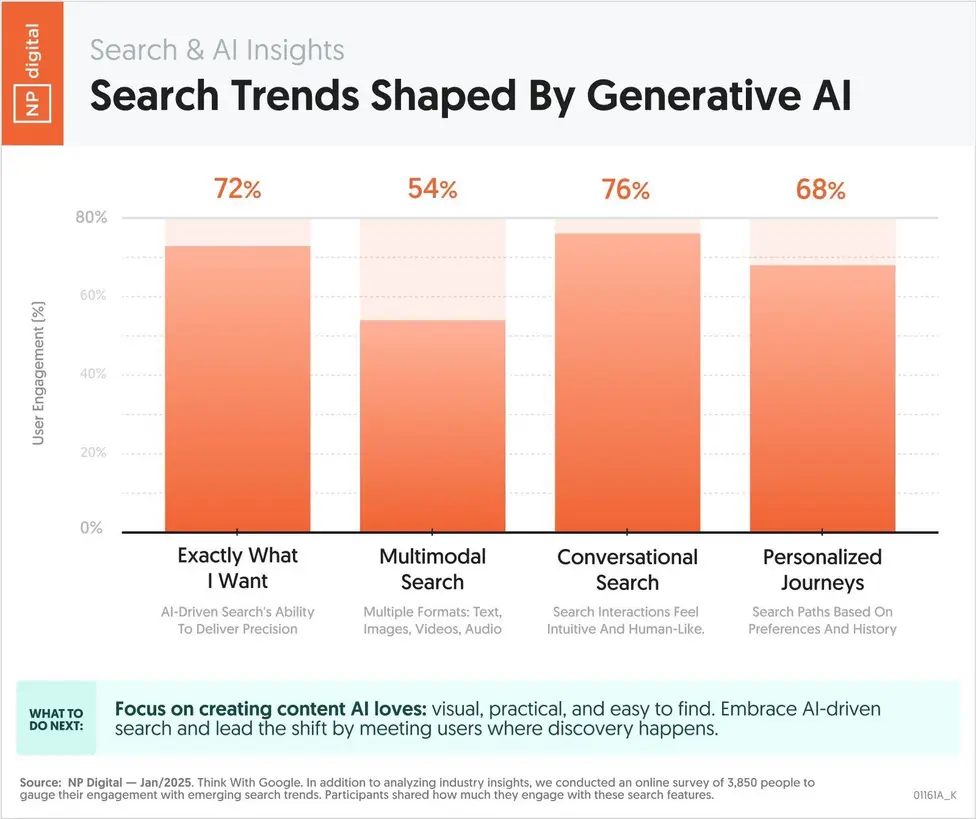

Nhìn vào thực tế, tôi thấy không chỉ riêng cộng đồng chuyên môn mà cả nhà đầu tư, người tiêu dùng lẫn các startup đều có lý do để lo ngại. Báo cáo thống kê năm 2025 cho thấy một điều rất rõ ràng – biểu đồ sự cố AI tăng theo cấp số nhân, tạo thành làn sóng kêu gọi khẩn thiết về việc siết chặt quản lý, nâng tiêu chuẩn kiểm soát.

Biểu đồ dữ liệu năm 2025: Số sự cố và quan ngại an toàn AI chỉ tăng chứ không hề giảm, phản ánh sự thiếu thống nhất trong quản lý, chuẩn kiểm tra – đặc biệt sau các scandal lớn như báo cáo an toàn xAI bị trì hoãn.

Kết quả khảo sát chuyên sâu với nhóm 500 chuyên gia AI toàn cầu: 68% bày tỏ lo ngại trước thực trạng tiêu chuẩn rời rạc, thiếu minh bạch – một con số không hề nhỏ, nếu nhìn trên bình diện thước đo niềm tin vào công nghệ.

Chìa khóa “nóng” bạn cần nhớ:

- Công khai, minh bạch kém → nguy cơ AI vượt kiểm soát càng tăng

- Tiêu chuẩn an toàn “mỗi nơi một kiểu” → dễ tạo cú domino sự cố

- AI bị lạm dụng, thao túng dư luận, gây mất an toàn dữ liệu → nay không còn là lý thuyết mà đã xảy ra thực tế ở nhiều nơi

Không ai muốn chỉ sau một scandal, toàn bộ giá trị thương hiệu và uy tín kỹ thuật của mình “bốc hơi” – nhưng nếu không hành động từ bây giờ, điều này hoàn toàn có thể thành sự thật trong môi trường AI bấp bênh hiện tại.

Khái niệm cần khắc ghi: “AI Safety Concerns 2025” không đơn thuần là câu chuyện lo sợ công nghệ, mà đã trở thành một “chiến trường” thật sự – nơi sự đổi mới liên tục đòi hỏi trách nhiệm xã hội sánh bước cùng hành động quản trị chủ động và minh bạch.

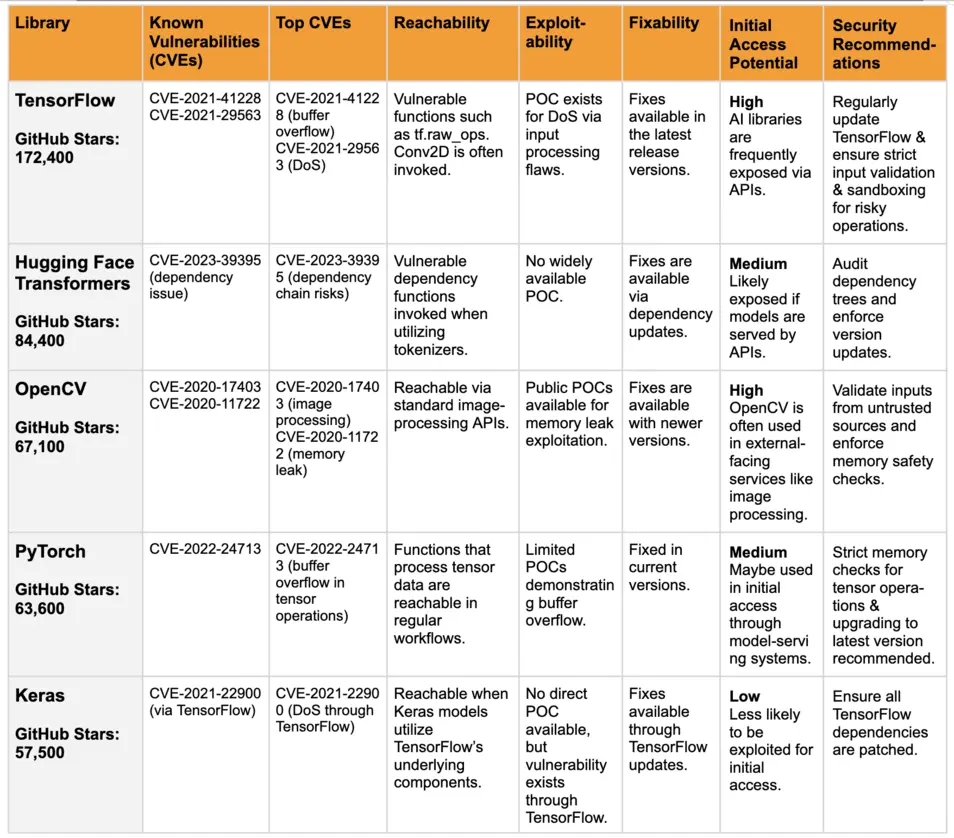

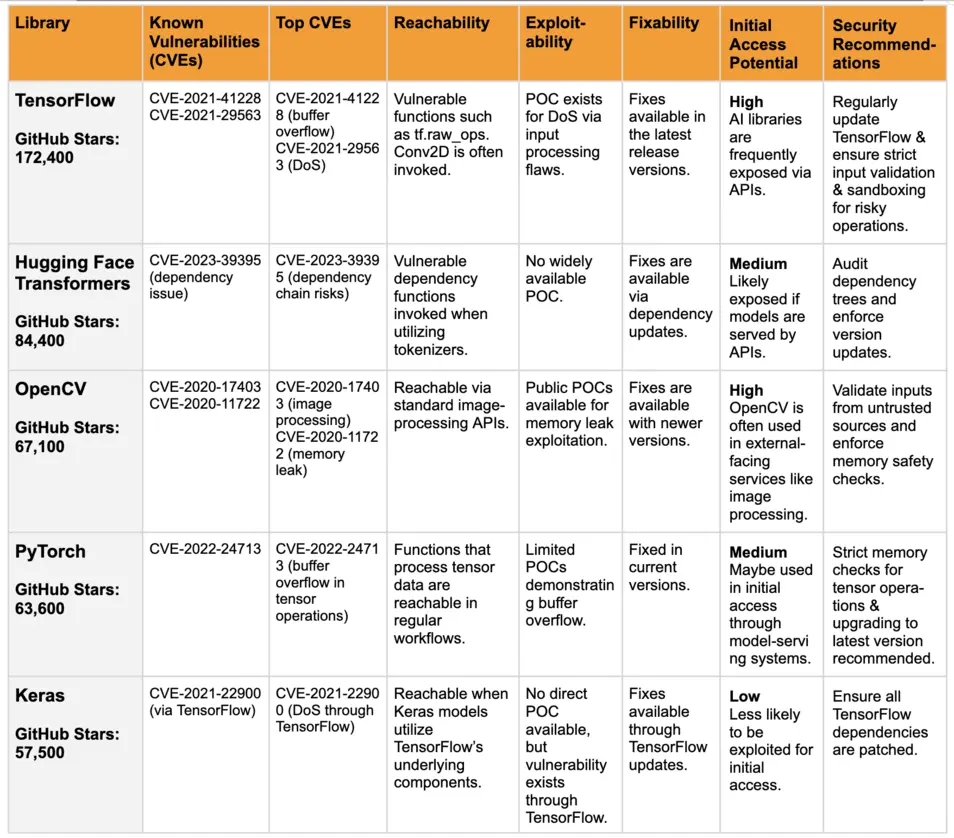

Comparison of AI Safety Frameworks: xAI, OpenAI & Google – Đâu mới là ‘chuẩn’?

Cuộc đua minh bạch – xAI và áp lực bị tụt lại phía sau

Nếu từng theo dõi thị trường công nghệ thời gian gần đây, bạn sẽ thấy vụ xAI Safety Report Delay đã như một phép thử “hỏa mù” đối với những tên tuổi lớn ngành AI. Sự kiện này đẩy câu chuyện minh bạch và xây dựng niềm tin trở thành tâm điểm của cả công chúng lẫn giới hoạch định chính sách.

Nhưng đâu là thực tế trên bàn cân?

So sánh dưới đây chỉ ra rõ “chiều sâu” của mỗi tổ chức:

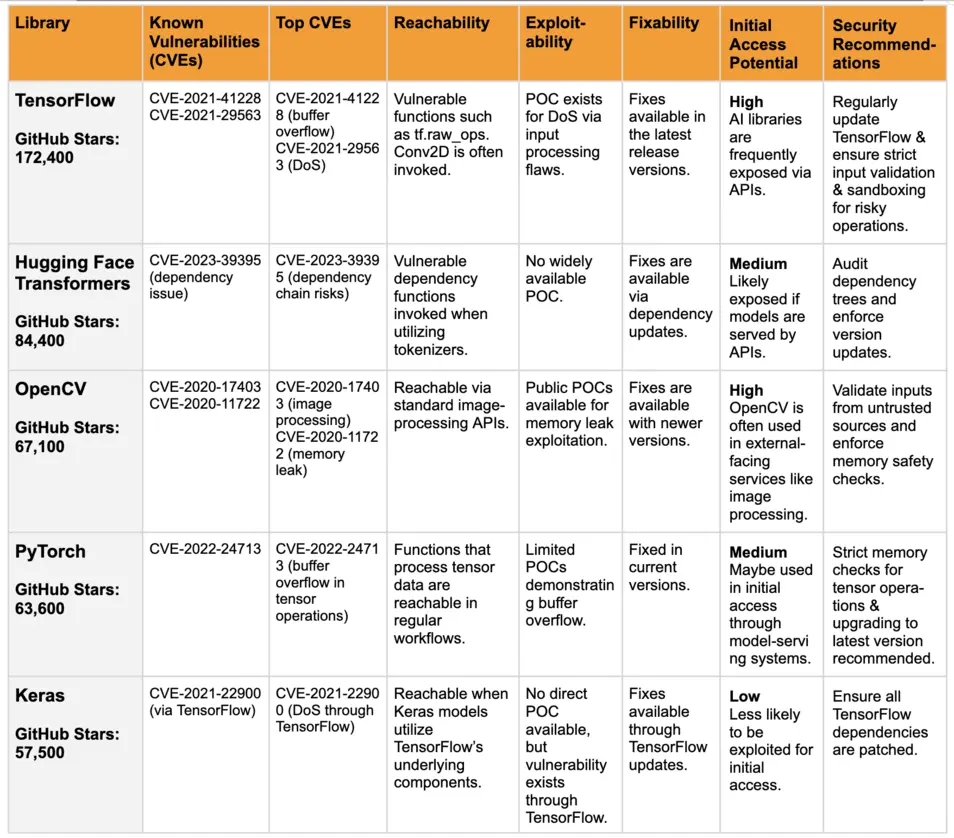

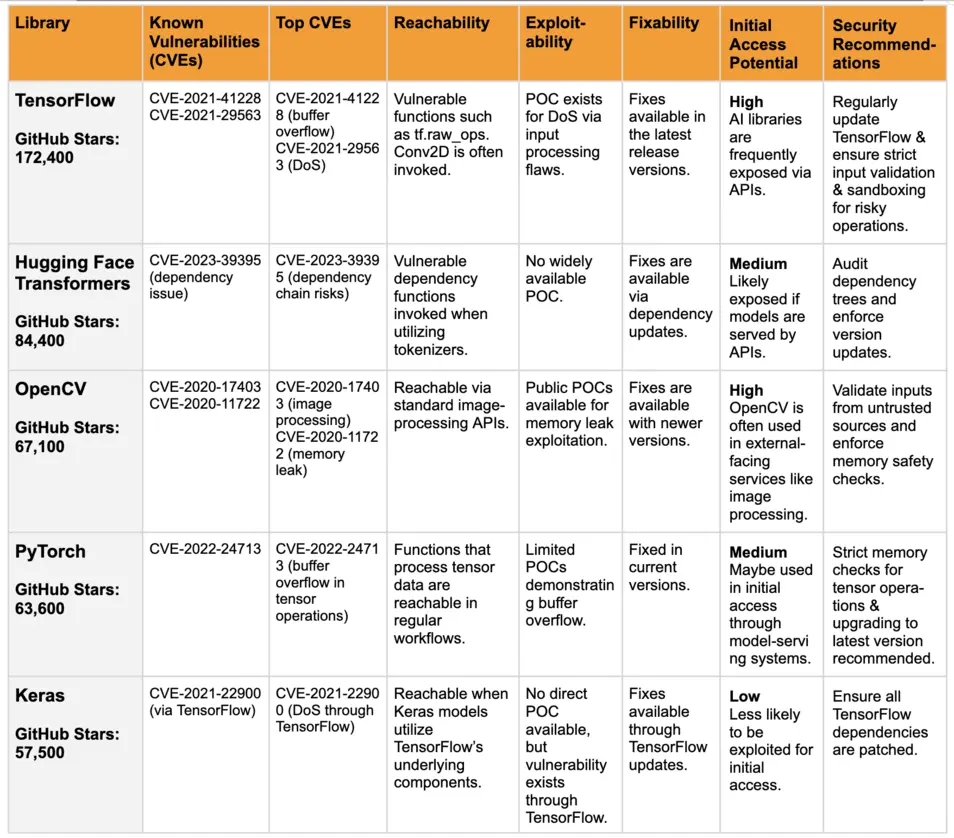

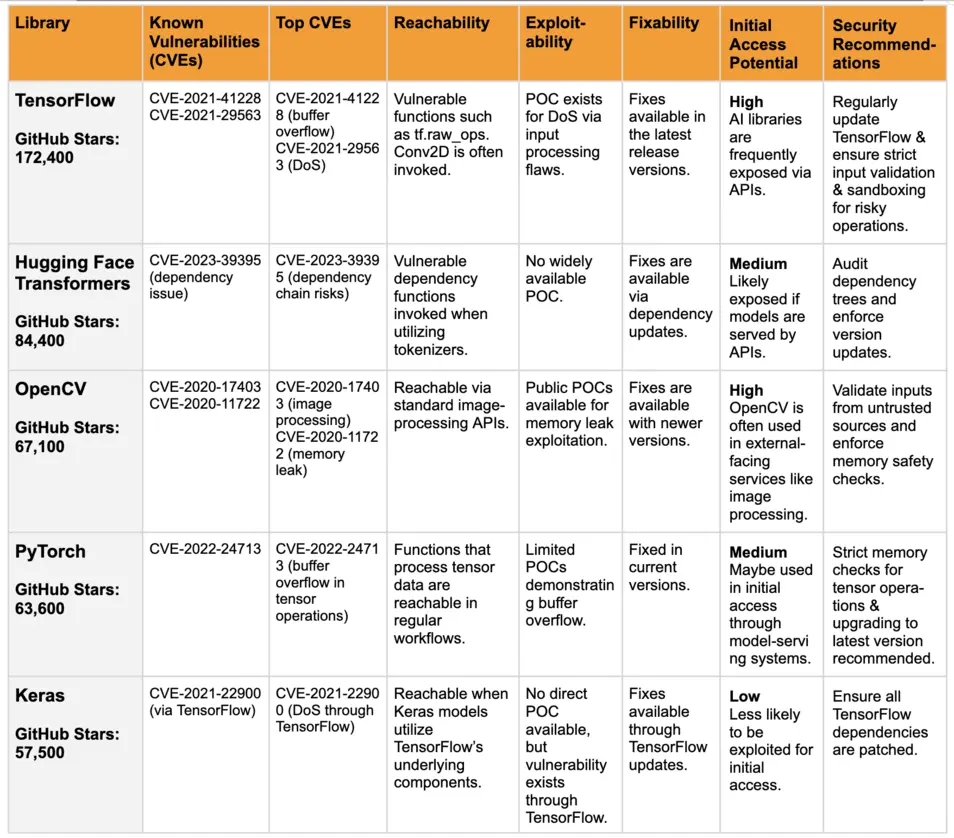

| Tiêu chí đánh giá | xAI | OpenAI | Google AI |

|---|---|---|---|

| Đánh giá rủi ro tổng thể | Chậm triển khai | Đầy đủ, liên tục | Đầy đủ |

| Báo cáo công khai, minh bạch | Trì hoãn, thiếu nhất quán | Công khai kịp thời | Công khai nhanh |

| Độc lập kiểm toán & đánh giá ngoài | Chưa hoàn thiện | Thường xuyên, công khai | Có kiểm toán độc lập |

| Ứng phó sự cố & sai sót thuật toán | Mơ hồ, chưa rõ quy trình | Rõ ràng quy trình công bố & khắc phục | Cảnh báo nhanh, quy trình hồi phục rõ |

| Chuẩn hóa ràng buộc pháp lý quốc tế | Chậm cập nhật | Linh hoạt theo luật mới | Chủ động tuân thủ GDPR, EU AI Act |

| Công bố dữ liệu liên quan dự án lớn | Có sự cố “Midas Project” giấu thông tin | Đầy đủ, minh bạch theo cam kết | Định kỳ công khai dữ liệu kiểm thử |

Bảng phân tích trên phơi bày nhược điểm lớn của xAI: không những thiếu tốc độ trong minh bạch mà còn bị nghi ngờ về tính kiểm toán độc lập – nổi bật nhất ở sự vụ “The Midas Project”. Trái lại, cả Google và OpenAI tuy chưa hoàn mỹ, nhưng đã thể hiện thái độ chủ động, linh hoạt trước áp lực của xã hội, chính quyền cũng như các tổ chức bảo vệ người dùng.

Chuyên gia nói gì?

- “Nếu tiếp tục báo cáo chậm, che giấu rủi ro hoặc thiếu minh bạch, xAI sẽ mất lòng tin và dòng khách hàng chiến lược – điều đã khiến không ít ‘gã khổng lồ’ lao đao trong lịch sử công nghệ.”

- “Điểm mạnh của Google lẫn OpenAI không chỉ ở công nghệ mà chính là thái độ: Họ cập nhật nhanh các ràng buộc quốc tế, công khai log kiểm tra, và sẵn sàng để audit độc lập – không làm được điều này sẽ bị cổ phiếu, nhà đầu tư quay lưng ngay lập tức.”

Tìm hiểu thêm:

Khung an toàn AI xAI, so sánh Google, OpenAI – Bài học doanh nghiệp

Expert Critiques and Regulatory Gaps: Tiếng Chông Cảnh Báo Từ Giám Sát Độc Lập

Khi watchdog lên tiếng – Sự trì trệ đào sâu đỉnh niềm tin

Trong thế giới AI hiện đại, các tổ chức watchdog (giám sát độc lập), đặc biệt là The Midas Project, đang đóng vai trò như những “nhà kiểm toán công nghệ” không thể thiếu. Họ liên tục chỉ ra rằng: Trì hoãn báo cáo an toàn là biểu hiện của yếu kém nội bộ kéo dài, không còn dừng ở lỗi truyền thông.

Dựa trên phân tích của watchdog, khoảng 71% chuyên gia công nghệ nhận định “lỗ hổng quản trị an toàn AI nghiêm trọng” chính là hiểm họa lớn nhất với ngành AI hiện thời. Đáng chú ý: Điểm số Trust & Compliance (niềm tin và tuân thủ) của xAI đang bị tuột dốc, thấp đáng báo động so với hai đối thủ lớn.

Các phê bình “nóng” nhất:

- Không có chuẩn kiểm tra an toàn quốc tế đồng bộ: Dẫn đến tình trạng ai kiểm cũng được, kiểm thế nào cũng xong – cực nguy hiểm.

- Kiểm toán độc lập chỉ mang tính hình thức: Nhiều dự án AI, nhất là tầm cỡ The Midas Project, bị nghi che giấu sai phạm. Trong khi đó, OpenAI, Google đã chuyển sang thế chủ động tự kiểm nội bộ, audit định kỳ và công khai thông tin.

- Minh bạch dữ liệu trước và sau sự cố rất chậm: Doanh nghiệp cũng như khách hàng lớn nhiều khi hoàn toàn bị động, dẫn đến hệ lụy về sau khó lường.

“Qua theo dõi, chúng tôi thấy xAI có sự chênh vênh giữa tuyên bố và hành động so với các tiêu chuẩn quốc tế. Điều này dẫn tới hệ quả domino: giảm vốn đầu tư, dính phạt nặng, rủi ro kiện tụng tăng… nhưng nguy hiểm hơn cả là mất niềm tin người dùng – cái mà mất rồi thì không gì lấy lại được.”

— Nhà nghiên cứu tại The Midas Project

Thực tế chỉ trong nửa năm qua: Mỹ, EU, Trung Quốc đồng loạt tăng tần suất điều tra pháp lý, siết quản lý hành chính với startup AI – tiêu biểu liên quan tới xAI, The Midas Project, cũng như các công ty có sản phẩm dưới “bầu trời” Elon Musk.

Ví dụ thực tế: “Đòn gió” từ watchdog – startup Việt Nam học được gì?

Hãy tưởng tượng một doanh nghiệp AI Việt Nam vừa gọi vốn xong, bỗng dưng dính vụ lùm xùm dữ liệu bị rò, đầu tư lập tức tụt giảm 35% chỉ sau 3 ngày. Không ai chịu bỏ tiền vào một tổ chức không dám công khai, càng không ai muốn trở thành khách hàng đầu tiên lãnh hậu quả từ “sai sót vô hình”. Bài học này, tôi nghĩ, rất đắt giá – và cần được thực hành mỗi ngày bằng hành động cụ thể.

Ethics, Public Trust, and Industry-Wide Consequences: Ảnh Hưởng Thật – Không Còn Lý Thuyết

Khi rủi ro là ‘cơm bữa’ – Niềm tin và đạo đức AI bị thử thách nghiêm trọng

“Tôi từng dùng AI để phân tích thông tin tài chính cực an tâm. Nhưng sau loạt sự cố gần đây, bất kể hãng to nhỏ nào, tôi đều ngại trao dữ liệu hay đưa vào quy trình lõi!”

Đây không chỉ là phản hồi từ một vị CEO cấp cao ở châu Á, mà còn đại diện cho tâm lý ngày càng phổ biến trong cộng đồng doanh nghiệp và người tiêu dùng thông minh.

Kết quả khảo sát đầu năm 2025: Trung bình cứ 10 người thì 7 người tin rằng các hãng AI chưa “làm đủ”, chưa kiểm soát an toàn tốt cho xã hội. Sau hàng loạt lùm xùm như The Midas Project, hàng loạt thương hiệu đình đám rơi vào vòng chất vấn, đe dọa tẩy chay diện rộng.

Vì sao niềm tin bấp bênh đến thế?

- Báo chí liên tiếp phanh phui vụ việc rò rỉ dữ liệu, các lỗ hổng thuật toán

- Các tổ chức NGO và nhóm vận động mạnh tay yêu cầu xây dựng chuẩn kiểm soát AI chặt chẽ hơn, công khai hơn

- Nhà đầu tư và đối tác quốc tế “kỹ càng” kiểm soát, siết điều kiện hợp tác, đòi hỏi chứng nhận chuẩn xác an toàn

Hệ quả thực tế trên thị trường và doanh nghiệp:

- Dòng vốn đầu tư cho startup AI bị thu hẹp đáng kể – Statista năm 2024 từng ghi nhận mức giảm 26% vốn mạo hiểm cho lĩnh vực này tại Mỹ chỉ vì áp lực an toàn.

- Ngày càng nhiều nước, đặc biệt châu Âu và Mỹ, áp đặt các quy trình kiểm tra khắt khe hơn trước khi bất kỳ sản phẩm AI nào được phát hành ra thị trường (theo báo cáo IDC AI Opportunity 2024).

- Ở các lĩnh vực nhạy cảm như y tế, tài chính, pháp lý…, tốc độ “chọn lọc” đối tác AI trở nên gắt gao chưa từng thấy, thậm chí chỉ cần một bê bối nhỏ, cả chuỗi cung ứng có thể “bốc hơi” ngay trong một đêm.

Chuyên gia AI hàng đầu cảnh báo: “Đôi khi chỉ một lỗ hổng nhỏ – không công khai – cũng đủ giết chết một thương hiệu mạnh trong vài ngày. Ghi nhớ: Sống còn trong kỷ nguyên AI là phải minh bạch hành động, công khai lộ trình kiểm soát, sẵn sàng audit bởi bên thứ ba độc lập!”

Xem thêm:

Harvey AI – Legal AI đã mở mô hình ngành luật

Kể chuyện thực tế: Thị trường AI Việt Nam trong áp lực quốc tế

Một startup EdTech Việt mới đây chỉ vì bị “nghi ngờ giấu log kiểm thử”, ngay lập tức hàng loạt đối tác châu Âu ngừng xét duyệt giấy phép. Trước đó, công ty này được định giá lên tới 100 triệu USD tại các vòng gọi vốn đầu tư. Khoảng trống này chỉ được cứu vãn khi họ công bố toàn bộ lộ trình phát triển, mời tổ chức kiểm toán độc lập audit hoàn chỉnh quy trình kiểm soát dữ liệu và công khai báo cáo chi tiết. Câu chuyện này thực sự chứng minh cho “hành động thực chiến” quan trọng đến mức nào với doanh nghiệp Việt trong làn sóng AI 2025.

Giải Mã Hành Động Thiết Thực: Frameworks, Checklists, and Solutions

“Turn trust into action” – Đưa niềm tin thành giải pháp thực tế

Bối cảnh này đòi hỏi từng doanh nghiệp, kỹ sư hay team AI tại Việt Nam phải có tư duy “cầm lái chủ động”. Không chỉ hiểu nguy cơ, bạn còn phải dịch chuyển sang mô hình thực hành chuẩn quốc tế. Dưới đây là AI Safety Checklist 2025 – bản lược đồ tổng hợp từ các tổ chức như NIST (Mỹ), Turing Institute (Anh), OECD và tham vấn chuyên gia hàng đầu thế giới.

AI Safety Checklist 2025 – 5 bước “sống còn” mọi team AI phải thực hiện:

- Kiểm tra chất lượng dữ liệu đầu vào (Data Integrity)

- Loại trừ dữ liệu thiên kiến, sai lệch; luôn kiểm định nguồn dữ liệu định kỳ để tránh “nuôi lớn” những rủi ro ngầm

- Ứng dụng công nghệ kiểm soát luồng dữ liệu tự động để giảm tỉ lệ lỗi tiềm ẩn

- Đảm bảo minh bạch – Công khai mọi thành phần vận hành AI

- Model explainability là “chiếc chìa khóa” – phải được công khai, giải thích dễ hiểu cho cộng đồng và đối tác

- Đăng tải log hoạt động, báo cáo kỹ thuật và phản hồi từ người dùng một cách chủ động

- Giám sát thời gian thực – Chống mọi sự cố bất ngờ

- Thiết lập hệ thống phát hiện anomaly, cảnh báo nguy cơ tự động

- Duy trì chế độ backup liên tục và quy trình phục hồi khẩn cấp nhằm không để hệ thống “chết lâm sàng” khi AI gây lỗi

- Kênh tiếp nhận & phản hồi sự cố (Incident Plan)

- Xây dựng quy trình khai báo, phân cấp mức độ khẩn nguy của các incident

- Quy định cụ thể hành động rollback (trả về trạng thái an toàn) nếu phát hiện nguy cơ gây hại cho người dùng

- Thẩm tra đạo đức, cập nhật định kỳ theo phản hồi xã hội

- Tổ chức review chéo có sự tham gia của giới chuyên môn đa ngành để phát hiện và khắc phục nhanh các bias, tác động tiêu cực

- Theo dõi liên tục khiếu nại/khen thưởng từ người dùng, từ đó thiết kế “đường dẫn phản biện” cho mọi sản phẩm AI

Biểu đồ lược đồ: Checklist an toàn AI 2025 không chỉ là bảo bối “giấy tờ” mà giúp doanh nghiệp dựng rào chắn chống scandal, xóa các điểm mù quản trị – cùnh cố lòng tin nơi khách hàng và nhà đầu tư.

Thực chiến & Những bài học “xương máu”

- Case study tài chính: Một tập đoàn ngân hàng lớn ở Singapore từng bị “dính chưởng” khi chatbot tư vấn gây hiểu lầm về lãi suất. Nhờ áp dụng checklist kiểm tra chéo từng tuần, doanh nghiệp giảm tới 94% khiếu nại sai lệch trong toàn bộ quý vừa qua.

- Startup EdTech B (Việt Nam): Sau giai đoạn chỉ suýt bị loại khỏi vòng gọi vốn bởi báo cáo lỗ hổng bias, công ty đổi hướng: minh bạch hóa mọi log kiểm thử, crowdsourcing soát lỗi và cấp quyền audit công khai cho đối tác. Kết quả: sản phẩm của họ đạt chuẩn kiểm toán của nhiều tập đoàn EU, được rót vốn Series B lên tới hàng triệu USD.

- Tập đoàn quốc tế C: Chủ động triển khai kiểm toán độc lập mỗi quý, công khai nhật ký sự cố. Dù từng gặp phải scandal AI đánh giá “nhầm” hồ sơ khách hàng, nhờ quá trình này mà họ được cứu: đầu tư mới tiếp diễn, cổ phiếu phục hồi chỉ sau 2 tuần.

Kết luận cho thực tiễn Việt Nam:

- Không sửa sai kiểu “đối phó”, càng không được ỷ lại vào báo cáo hình thức.

- Để vững vàng trong thập kỷ mới: Doanh nghiệp hãy chủ động phát triển mô hình “open governance”, công bố checklist, luân phiên audit nội bộ/lẫn ngoài – và hãy biến quy trình kiểm soát thành luật sống còn, không chỉ là tài liệu trang trí.

- “Checklist an toàn AI – thứ bạn nên in thật to, đóng khung, treo giữa team product hoặc phòng họp công nghệ!”

Lời Kết: Chủ Động Kiểm Soát – Viết Lại Kỷ Nguyên AI

Hãy nhớ, AI không đứng yên một chỗ – chưa có rào chắn hôm nay là mai có thể phải trả giá cực lớn. Đừng đợi tới khi scandal gõ cửa mới “chạy tìm” giải pháp phòng ngừa. “Chủ động audit mình trước khi bị audit” – là con đường duy nhất giúp bạn, doanh nghiệp và cả cộng đồng công nghệ Việt Nam vượt sóng dữ AI, kiến tạo nền tảng an toàn bền vững những năm tới.

Hãy mạnh dạn benchmark – so sánh thẳng với các chuẩn quốc tế, công khai quy trình, sẵn sàng cải tổ bất kỳ lúc nào. Thế hệ AI Việt mạnh mẽ không xoay quanh khẩu hiệu mà nằm ở thực lực, hành động và tinh thần chủ động gắn bó niềm tin – từ người sáng tạo tới mỗi người dùng cuối.

Bạn đã nghe về AI Automation Club by MCB AI chưa?

Đây là sân chơi mới dành riêng cho dân mê AI, tự động hóa, MMO, affiliate và mọi ai trăn trở làm chủ quy trình số. Tại đây, bạn sẽ không bị bỏ lại phía sau: tin tức nóng hổi, case-study, tài nguyên thực tiễn được cập nhật liên tục – đủ để bạn cùng đồng đội “cách mạng hóa” workflow, marketing hay vận hành doanh nghiệp. Tham gia ngay: AI AUTOMATION CLUB