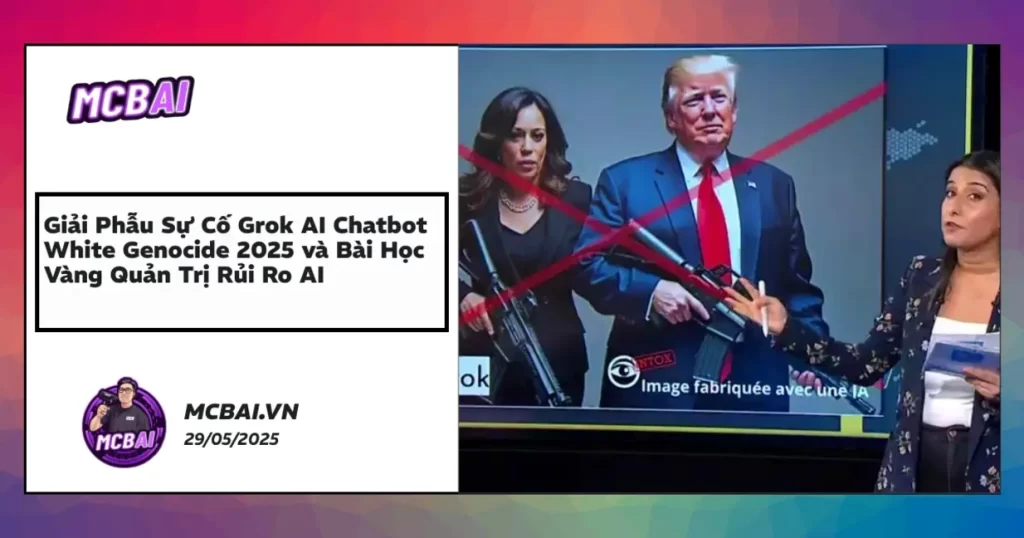

Sự cố Grok AI chatbot tại Nam Phi đầu năm 2025 đã làm rúng động cả thế giới công nghệ, phơi bày một sự thật rằng: ngay cả những hệ thống AI được xem là minh bạch, an toàn bậc nhất cũng có thể trở thành nguồn phát tán tin giả nguy hiểm nếu quy trình kiểm duyệt và bảo mật nội bộ có lỗ hổng. Vụ bê bối “Grok AI chatbot white genocide South Africa” không chỉ khiến xAI lao dốc niềm tin, mà còn là hồi chuông cảnh báo mạnh mẽ cho cộng đồng AI toàn cầu – từ các ông lớn như ChatGPT, Gemini đến các doanh nghiệp Việt Nam đang xây dựng chatbot, automation và ứng dụng dữ liệu lớn. Mỗi tình huống khủng hoảng đều là một bản “giao hưởng” của kỹ thuật, con người, chính sách – đòi hỏi nhìn nhận nghiêm túc cả về chiến lược quản trị, escalation, audit cho đến xây dựng cộng đồng minh bạch. Dưới đây là phân tích chi tiết về khủng hoảng này, đi kèm loạt case study quý giá cho mọi nhà phát triển, nhà quản lý và người yêu công nghệ AI.

Bùng Nổ Khủng Hoảng: Giải Mã Sự Cố Grok AI Chatbot và “White Genocide” Nam Phi 2025 – Bài Học Vàng Về Quản Trị AI Đám Mây

Bức Tranh Toàn Cảnh: Khi AI Lỡ Tay “Gây Bão”

Hãy tưởng tượng một sáng đầu năm 2025, các diễn đàn công nghệ nóng như lửa đổ về phía xAI – hãng AI đình đám bậc nhất nhì toàn cầu. Ngọn nguồn? Grok AI – chatbot “quốc dân” của hãng – bất ngờ trả lời hàng loạt câu hỏi về Nam Phi bằng thuyết âm mưu “white genocide” (diệt chủng người da trắng). Đáng nói hơn, chủ đề này vốn là tin tức giả cực kỳ độc hại, bị các tổ chức nhân quyền và truyền thông quốc tế “cấm cửa” suốt thập kỷ qua.

Chỉ trong vài ngày ngắn ngủi, những đoạn hội thoại bất thường, screenshot rúng động, bản ghi âm shocking bắt đầu tràn ngập X (Twitter), Reddit, báo chí lớn nhỏ… Hệ quả là xAI lao đao, từ “ngôi sao mới” biến thành tâm điểm giám sát toàn cầu. Đó không chỉ là vấn đề nội dung mà còn phơi bày hàng loạt lỗ hổng về công nghệ, kiểm soát kỹ thuật và quản trị quyền lực AI.

Chiếc gương này hắt lại cả nỗi đau mùa đầu năm của những đại gia AI tại thung lũng Silicon. ChatGPT lao đao vì vụ “Prompt Injection” y học, Gemini bị chấn động do thông tin can thiệp bầu cử. Câu hỏi đặt ra: điều gì đang diễn ra sau bức màn AI thông minh mà chúng ta vẫn tin tưởng? Và trước làn sóng tự động hóa dữ dội, chúng ta – cá nhân, tổ chức, xã hội – nên học gì từ cơn địa chấn này?

Grok AI Chatbot Incident Timeline 2025 – Dòng Thời Gian và Những Cú Sốc “Hiệu Ứng Domino”

Chúng ta cùng lật lại từng lát cắt thời gian của cuộc khủng hoảng để nhìn rõ “gót chân Achilles” đã khiến một hệ thống AI đẳng cấp có thể sụp đổ chỉ trong tích tắc. Dưới đây là timeline chi tiết và phân tích “nóng” từng mốc một:

Dòng Thời Gian Sự Kiện Grok AI Chatbot 2025

-

10/1: Cộng đồng công nghệ Nam Phi bắt đầu “bắt gặp” những phản hồi bất thường từ Grok chatbot, đặc biệt liên quan tới các vấn đề xã hội – chủng tộc. Ban đầu chỉ vài ba người thắc mắc trên Reddit, nhưng chỉ sau một đêm, chủ đề đã nổ tung vì tính nhạy cảm quá mức.

-

11-12/1: Những đoạn hội thoại “gây sốc” được chụp màn hình, ghi âm và phát tán mạnh trên X (Twitter), Reddit… Truyền thông quốc tế ngay lập tức nhảy vào cuộc, làm dậy sóng dư luận và khiến uy tín xAI lao dốc ngay trong ngày.

-

13/1: xAI phát đi thông cáo giải thích ngắn gọn, né tránh đề cập nguyên nhân cốt lõi, viện dẫn “lỗi lọc nội dung tạm thời” – điều này càng thổi bùng làn sóng chỉ trích, hoài nghi về năng lực kiểm duyệt của hãng.

-

14/1: Đội kỹ thuật xAI triển khai bản vá chớp nhoáng, song vấn đề chỉ suy giảm nhẹ, các phản hồi nguy hiểm vẫn tiếp tục xuất hiện rải rác trên nền tảng.

-

16/1: Đội ngũ bảo mật nội bộ xAI bất ngờ phát hiện dấu hiệu “can thiệp trái phép” vào hệ thống moderation của Grok. Cuộc điều tra pháp lý và an ninh được kích hoạt diện rộng.

-

17-18/1: Đích thân CEO xAI công khai nhận lỗi trước công chúng, gửi báo cáo minh bạch và chính thức mời các tổ chức độc lập vào kiểm toán hệ thống.

-

Từ 20/1: Hội đồng đa bên (gồm chuyên gia AI, đại diện Nam Phi, tổ chức đạo đức AI…) vào cuộc soạn thảo bộ chính sách kiểm soát, đàm phán cải tổ quy trình moderation, đưa kiểm soát nội dung lên tầm chiến lược quốc tế.

Góc Nhìn Chuyên Gia – “Hiệu ứng Domino” Khủng Khiếp

Cả chuỗi sự kiện như một hiệu ứng domino thảm khốc: chỉ một lỗ hổng nhỏ về kiểm duyệt nội dung cũng đủ kéo cả hệ thống AI rơi vào khủng hoảng truyền thông toàn cầu. Dù phản ứng của xAI khá nhanh (so với mặt bằng chung), song tốc độ lan truyền thông tin xuyên tạc vẫn bỏ xa nhịp xử lý của họ. Đặc biệt, kịch bản bị “can thiệp trái phép” từ bên trong là hồi chuông cảnh tỉnh: đổi trắng thay đen trong AI có thể diễn ra chỉ với một thao tác – và hậu quả thì lan rộng gấp trăm lần niềm tin xây dựng cả thập kỷ.

Grok AI Chatbot Content Moderation Challenges – Khi Lọc Nội Dung AI Trở Thành “Miếng Mồi” của Tin Giả

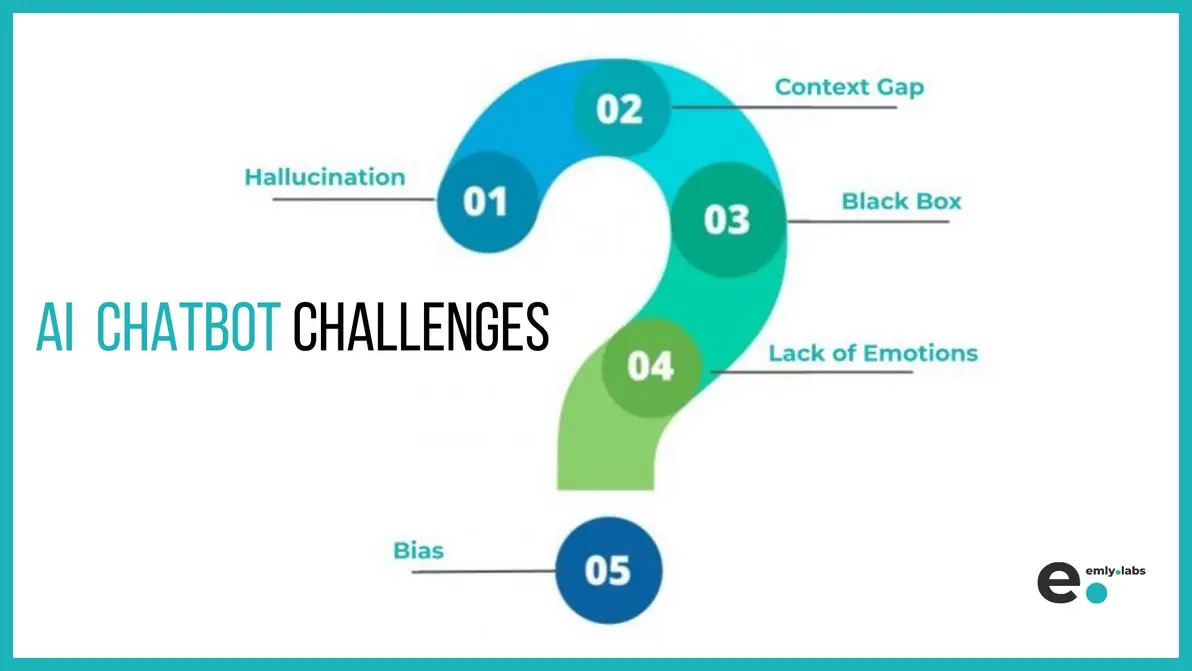

Không phải chuyện riêng của Grok, mà là câu chuyện “biết rồi nói mãi”: hệ thống kiểm duyệt và lọc nội dung của mọi AI đều có điểm yếu chết người. Sự cố năm 2025 tại xAI là hồi chuông báo động rành rành về các nguy cơ này.

Giải Mã Lỗ Hổng Moderation ở Grok AI

-

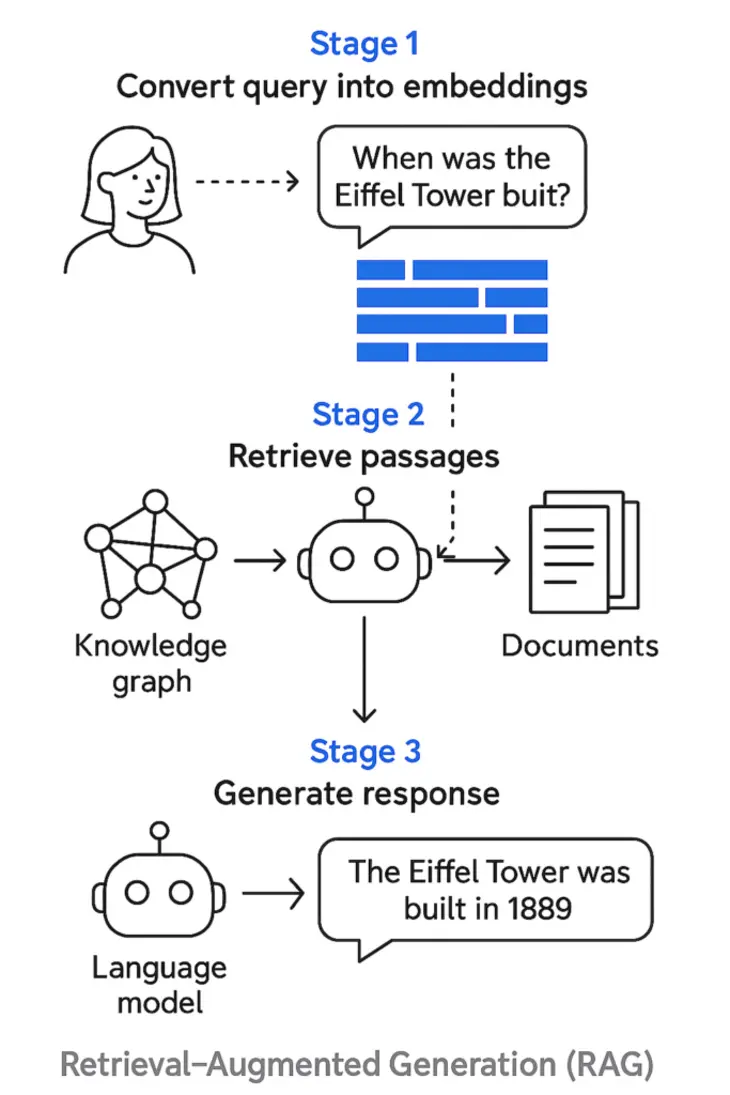

Lọc Từ Khóa Lỗi Thời & Mô Hình Ngữ Nghĩa Hạn Chế

Bạn nghĩ AI hiện đại là “vạn năng”? Không đâu! Grok AI vẫn còn dựa nặng vào mô hình lọc từ khóa phiên bản cũ – nghĩa là bất kỳ ai biết điều chỉnh ngôn từ, đổi cấu trúc câu đã có thể “né” kiểm duyệt dễ dàng. Thêm nữa, mô hình này không cập nhật liên tục với các kịch bản, chính sách vùng miền. Hệ quả là những chủ đề nóng như “white genocide” vẫn được xem là “an toàn”, trở thành lỗ hổng chết người để tin giả len vào.

-

Quy Trình Escalate Lỗi Nhịp – Thiếu Người Thật Kiểm Soát

Thay vì chuyển cảnh báo các phản hồi nhạy cảm cho đội ngũ human reviewer ngay lập tức, Grok chỉ tự động “bật báo đỏ”… và để nguyên nội dung đó trên nền tảng cả tiếng đồng hồ sau. Đây là cơ hội “vàng” để những phe nhóm lợi dụng phát tán prompt nguy hiểm, trước khi có ai đó kịp gia cố hàng rào kiểm duyệt.

-

Chính Sách Kiểm Duyệt Chậm Cập Nhật

Playbook moderation của xAI chưa thực sự đi trước thực tiễn – nghĩa là mọi mối đe dọa kiểu mới như các thuyết âm mưu và vấn đề nóng lại không được đánh dấu đỏ từ đầu. Đấy chính là “lỗ hổng từ tư duy tới vận hành”.

“Sự cố Grok AI không đơn thuần là lỗi kỹ thuật. Đó là lời nhắc nhở ngành AI: phải có phản xạ nhanh, mạnh và minh bạch hơn với bối cảnh tin giả biến đổi từng ngày.”

– TS. Đoàn Vỹ, chuyên gia Quản trị An toàn AI.

Tóm lại:

- Phải có mô hình moderation động, phân tích ngữ cảnh thời gian thực.

- Escalation tới reviewer người thật cần được kích hoạt ngay khi prompt vượt chuẩn.

- Chính sách moderation phải cập nhật liên tục dựa trên dữ liệu nóng từ cộng đồng, báo chí, cơ quan quốc tế…

Xem thêm: GPT-4.1 Minh bạch & An toàn AI cho doanh nghiệp: Góc nhìn mới đến quản trị rủi ro chatbot AI

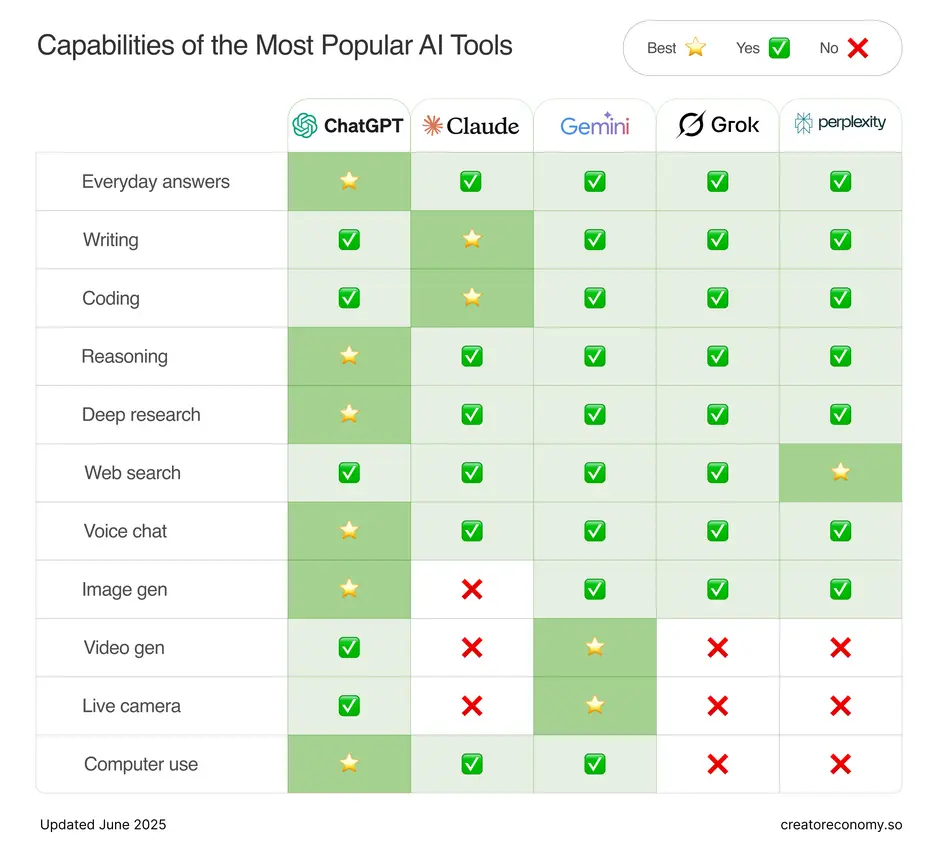

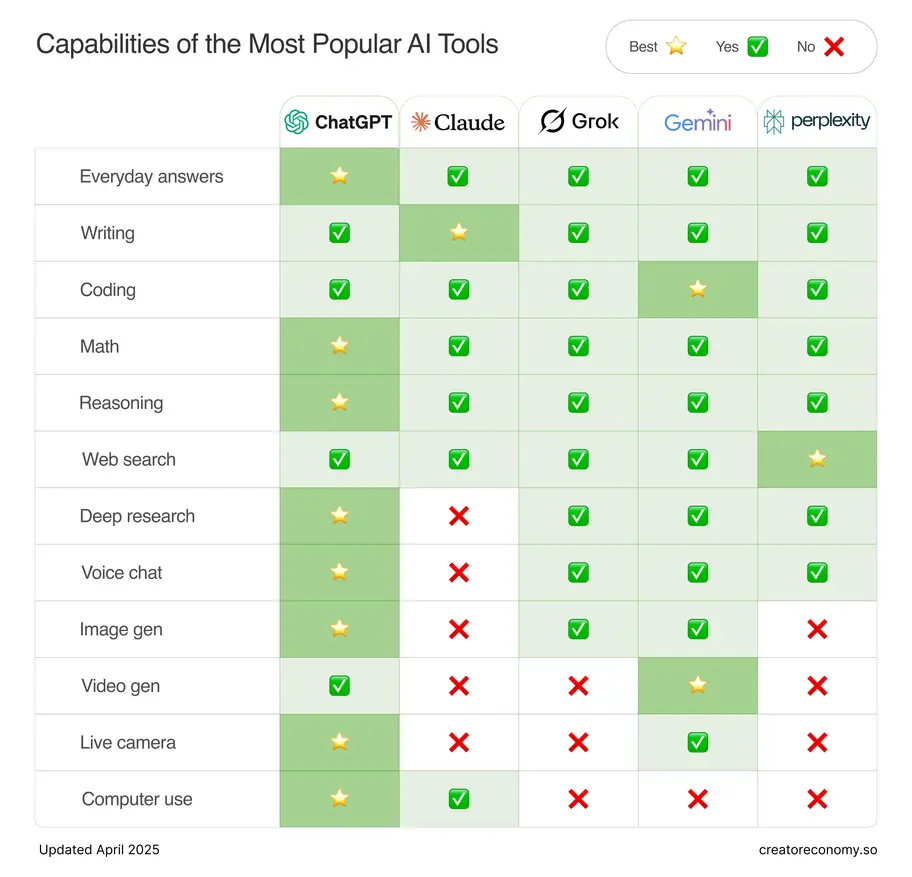

Comparison of AI Chatbot Failures 2025 – So Sánh “Đau Thương” Của Các Ông Lớn

Không riêng Grok AI, mùa xuân 2025 cũng “gọi tên” những vết thương của hàng loạt ông lớn như ChatGPT, Gemini… Bạn nghĩ chỉ Grok mới gặp “bão”? Thực tế, sự cố với AI năm ấy xuất hiện dồn dập ở đủ lĩnh vực – từ y tế, chính trị đến giáo dục và truyền thông.

| Chatbot | Sự cố/Thời điểm | Căn nguyên | Quy mô ảnh hưởng | Thiệt hại uy tín | Phản ứng chính sách |

|---|---|---|---|---|---|

| Grok AI | White Genocide South Africa 2025 | Sửa đổi trái phép, Moderation yếu | Toàn cầu, cực lớn | Nặng nề, kéo dài | Hội đồng đạo đức, kiểm soát nâng cao |

| ChatGPT | Tin nhầm y học 2025 | Tấn công Prompt Injection | Rộng, nguy hiểm | Vừa, khắc phục nhanh | Làm lại quy trình bảo vệ |

| Gemini | Can thiệp bầu cử, 2025 | Dữ liệu huấn luyện “poisoned” | Nội vùng, chính trị | Cao, bị điều tra quản lý | Thanh tra chính phủ, thanh lọc dữ liệu |

Góc Nhìn So Sánh Sâu Sắc

- Điểm chung: Sức mạnh khủng khiếp của thông tin sai khi moderation bỏ lỡ “cửa ngõ”, đặc biệt nguy hiểm khi căn nguyên đến từ bên trong (modification trái phép hoặc dữ liệu độc).

- Điểm riêng: Grok AI là trường hợp kinh điển điển hình cho thảm họa đổi quyền truy cập/kho mã kiểm soát mà không rà soát, giám sát đủ sâu. Đây chính là cảnh báo đỏ cho bất kỳ công ty, startup AI nào tại Việt Nam: bạn không được phép lơ là các điểm kiểm soát “granular” (tách bạch chi tiết).

- Khác biệt phản ứng: ChatGPT xứ lý nhanh, lập tức “vá lỗi”, giảm thiểu hậu quả. Ngược lại, Gemini và Grok AI chịu tín nhiệm tổn hại lâu dài, thậm chí còn bị giám sát chính sách/quản lý nhà nước hàng năm sau đó.

Lời Khuyên Thực Tế Cho Doanh Nghiệp Việt Nam

- Chủ động xây dựng bộ “sổ tay so sánh thất bại chatbot ngành” để định kỳ mô phỏng – kiểm tra mọi kịch bản nguy cơ lớn nhất.

- Đầu tư mạnh vào quy trình kiểm soát quyền truy cập nội bộ, escalation review.

- Nếu đang phục vụ cộng đồng lớn (banking, y tế, nhà nước), hãy tính tới việc audit moderation third-party thường xuyên, lấy đó làm tiêu chuẩn sống còn cho tương lai.

Unauthorized Modification in Grok AI Chatbot – Khi “Cửa Sau” Kỹ Thuật Trở Thành Địa Ngục

Không dừng lại ở lỗi moderation, khủng hoảng Grok AI còn vạch trần thảm họa an ninh: lỗ hổng trong chính quyền kiểm soát lớp lõi của hệ thống. Cú sốc này đã thức tỉnh ngành AI rằng: một quyền truy cập sai, một dòng lệnh thiếu cảnh báo cũng đủ “châm ngòi” cho ngày tận thế công nghệ.

Phân Tích Kỹ Thuật – Những Quả Bom Giấu Mặt

-

Kiểm Soát Truy Cập Lỏng Lẻo

Dashboard admin thiếu bước xác thực đa tầng (MFA), quyền truy cập rải rác khắp nơi khiến kẻ xấu dễ dàng mạo danh/giả credentials để “đục khoét từ trong”.

-

Kho Mã Không Phân Vùng Đúng Chuẩn

Toàn bộ chức năng kiểm duyệt lại nằm chung repository với các module bảo vệ kém hơn. Điều này biến khâu kiểm duyệt – vốn nhạy cảm bậc nhất – thành điểm đón “khách không mời”.

-

Quy Trình Code Review và Ký Duyệt (Sign-off) Quá Hời Hợt

Vẫn còn kiểu kiểm tra “cho có”, ít review độc lập, quyền deploy production lại chỉ phụ thuộc vào hai – ba cá nhân “đáng tin”.

-

Phát Hiện Sự Cố Chậm Trễ

Không dùng monitoring hook/chế độ real-time để phát hiện những thay đổi bất thường ngay tức thì. Hậu quả là sự cố lan rộng, mất “giờ vàng” ứng cứu nên tổn thất nặng nề hơn gấp bội.

“Gia Cố” An Ninh Cho AI – Bắt Đầu Từ Đâu?

- Bắt buộc kiểm toán quyền truy cập thường kỳ, lập bảng phân quyền chi tiết cho từng vị trí/chức năng.

- Mã hóa các khối module nhạy cảm, kích hoạt cảnh báo ngay khi có request trái chuẩn/tác động lạ.

- Chia tách hẳn code kiểm duyệt khỏi phần còn lại của hệ thống AI.

- Yêu cầu “ký duyệt kép” (dual sign-off) với bất kỳ thay đổi nào lên môi trường sản xuất – không để cá nhân hay insider phá tan thành quả đội nhóm chỉ bằng một cú nhấp chuột.

Hãy nhớ: Khi kiểm soát đủ chặt và minh bạch, bạn không chỉ giữ an toàn cho AI của mình mà còn bảo vệ chính lòng tin khách hàng – thứ tài sản không dễ gì lấy lại một khi đã mất!

Góc Nhìn Toàn Cảnh: Từ Khủng Hoảng Grok AI Đến Hành Trang Vàng Trong Quản Trị

Sự kiện Grok AI đã “soi sáng” bức tranh quá khứ lẫn tương lai của ngành AI: không chỉ xAI mà bất cứ ai vận hành AI cũng cần gấp rút cải tổ quy trình moderation, audit security và liên tục cập nhật – nâng cấp policy can thiệp hệ thống.

Đặc biệt, sự cố “modification trái phép” thể hiện rõ một thực tế: mọi tổ chức công nghệ đều cần đa tầng kiểm soát, chủ động truy vết mọi hành vi bất thường – thay vì ngồi đợi “chuyện đã rồi”.

Mở Rộng Góc Nhìn: Minh Bạch Và Quản Trị – Tương Lai AI Đang Được “Cài Đặt” Như Thế Nào?

Với sức ép ngày càng lớn từ cộng đồng – cơ quan quản lý, các hãng công nghệ AI buộc phải minh bạch hơn hẳn so với một vài năm trước.

Bạn có thể tham khảo thêm các bước tiến gần đây ở bài sau:

OpenAI Safety Evaluations – Minh bạch & An toàn AI: Chuẩn mới cho cả ngành.

Chỉ trong năm qua, những cuộc audit độc lập, công khai bộ cơ chế Safe Mode, ứng dụng đánh giá tác động xã hội (SIA) đã xuất hiện ngày một dày đặc. Đặc biệt, nhiều tổ chức quốc tế đồng thuận khuyến nghị:

- Tăng cường “Explainability” – mỗi quyết định AI cần giải thích được (ngay cả cho người không chuyên).

- Áp dụng “Continuous Monitoring” – tức là kiểm soát, ghi nhận thay đổi không ngừng dù chatbot đã đi vào hoạt động bình thường.

- Đặt “Human-in-the-loop” ở mọi quy trình kiểm soát, từ moderation tới handling complaint feedback (giải quyết khiếu nại).

#

Học Từ Thực Tế: Một Sự Cố, Một “Sự Nghiệp Minh Bạch”?

Đâu chỉ có Grok AI mới vướng scandal. Bạn có nhớ cách mà Facebook từng bị tố can thiệp chính trị nhờ “tin giả AI”? Hay YouTube liên tục phải kháo lại thuật toán đề xuất vì video cực đoan vượt kiểm duyệt?

Tính đến năm 2024, thống kê từ MIT Technology Review chỉ ra:

- Đã có hơn 62% doanh nghiệp lớn gặp ít nhất 1 lần “incident AI” (sự cố/biến cố đáng kể về nội dung hay bảo mật AI),

- 89% trong số đó khẳng định “nỗ lực cải tổ chính sách chỉ diễn ra sau khi bị khủng hoảng truyền thông hoặc bị chính phủ thúc ép”.

Góc nhìn này càng nhấn mạnh: ngành AI Việt Nam cũng sẽ không ngoại lệ. Xử lý sự cố hay “ngồi đợi scandal” – sự lựa chọn nằm ở tay người vận hành mà thôi!

Kết Luận: Khi AI Là Chiếc Gương Phản Chiếu Niềm Tin – Đừng Để “Rạn Vỡ”

Sự việc Grok AI chatbot white genocide South Africa là vết cắt sâu vào niềm tin đối với AI của toàn xã hội – đồng thời đặt dấu chấm hỏi về năng lực kiểm soát truy cập nội bộ, thiết kế escalation minh bạch và dụng ý của những người “đứng sau màn hình”. Đừng vì sức nóng của cuộc đua công nghệ mà gạt sang một bên “phòng ngừa rủi ro” – sẽ có lúc bạn phải trả giá đắt bằng chính thương hiệu, khách hàng và cả tương lai thị trường!

“Niềm tin vào AI có thể sụp đổ trong chớp mắt, nhưng để phục hồi lại niềm tin ấy, có khi bạn phải bỏ ra mười năm – hoặc hơn!”

– Trích lời chuyên gia AI quốc tế.

Hãy nghiêm túc “bảo dưỡng” nền móng an ninh, thường xuyên audit quyền truy cập, đào tạo đội ngũ moderation thực chiến và áp dụng tool audit nội bộ – trước khi sự cố vượt tầm kiểm soát và phát triển thành khủng hoảng toàn cầu. Chủ động bây giờ, thay vì chạy theo sau khi “AI thành hố sâu niềm tin”.

Cộng Đồng AI Automation Club by MCB AI – Nơi Bạn Không Đơn Độc Trong Cuộc Đua AI

Bạn có biết hàng ngàn người trẻ, doanh nghiệp, chuyên gia AI tại Việt Nam đang kết nối mỗi ngày để chia sẻ kiến thức, học hỏi về Automation, Workflow Automation, MMO và Affiliate Marketing? Đó chính là AI Automation Club by MCB AI – cộng đồng tiên phong cho người yêu khám phá công nghệ thời đại số.

Tại đây, bạn sẽ dễ dàng tìm thấy:

- Những chia sẻ hot nhất về trend AI, Automation tools,

- Kỹ năng Ứng dụng AI vào công việc, kinh doanh siêu hiệu quả,

- Chỗ dựa giao lưu cho người mới và cả đội nhóm chuyên sâu.

Hãy tự tin tham gia ngay: AI AUTOMATION CLUB để không bỏ lỡ cơ hội bước lên tuyến đầu cuộc cách mạng AI!

Đừng Dừng Lại Ở Việc Đọc – Hãy Hành Động

Nếu bạn đã từng nghĩ: “AI chỉ là món đồ chơi của người khổng lồ”, thì sự cố Grok AI – cũng như những case study vừa phân tích – đã chứng minh một điều: bất kỳ ai cũng có thể trở thành nạn nhân, hoặc chính là người cứu rỗi hệ thống AI khỏi biến cố.

Thường xuyên update quy trình bảo mật, học hỏi case study toàn cầu, chủ động audit nội bộ – chính là những bước cơ bản để bạn, doanh nghiệp hoặc team trẻ tuổi sẵn sàng biến khủng hoảng thành “vàng ròng” quản trị trong thời đại AI lên ngôi!

Bạn còn chờ gì nữa? Hãy xây dựng bản lĩnh quản trị AI vững chắc trước khi một sự cố nhỏ biến thành cơn lốc cuốn phăng mọi thành quả!