Trong kỷ nguyên AI phát triển như vũ bão, chỉ một lỗi nhỏ trong lập trình cũng có thể kéo theo hệ quả không lường trước cho cả một doanh nghiệp hay thậm chí là ngành công nghệ. Câu chuyện về Grok AI – chatbot đình đám của xAI, trở thành minh chứng sống động cho sức mạnh “hiệu ứng domino” mà một dòng code sai có thể gây ra: từ sự cố phủ nhận Holocaust đến khủng hoảng truyền thông toàn cầu, lung lay niềm tin số của triệu người dùng và mở ra bài học cảnh tỉnh về đạo đức – minh bạch trong xây dựng, vận hành AI. Nắm vững từng mắt xích kỹ thuật, nhận diện lỗ hỏng nguy hiểm, học cách đối mặt khủng hoảng và kiến tạo nền “hệ miễn dịch số” là năng lực sống còn cho mọi nhà lãnh đạo công nghệ ngày nay. Hãy cùng bóc tách toàn diện vụ Grok AI qua từng khía cạnh dưới đây để nhận diện thách thức – giải pháp quản trị AI “chuẩn quốc tế” cho kỷ nguyên mới, đồng thời áp dụng các quy tắc hiển thị bảng, blockquote, liên kết để tối ưu trải nghiệm đọc và tra cứu.

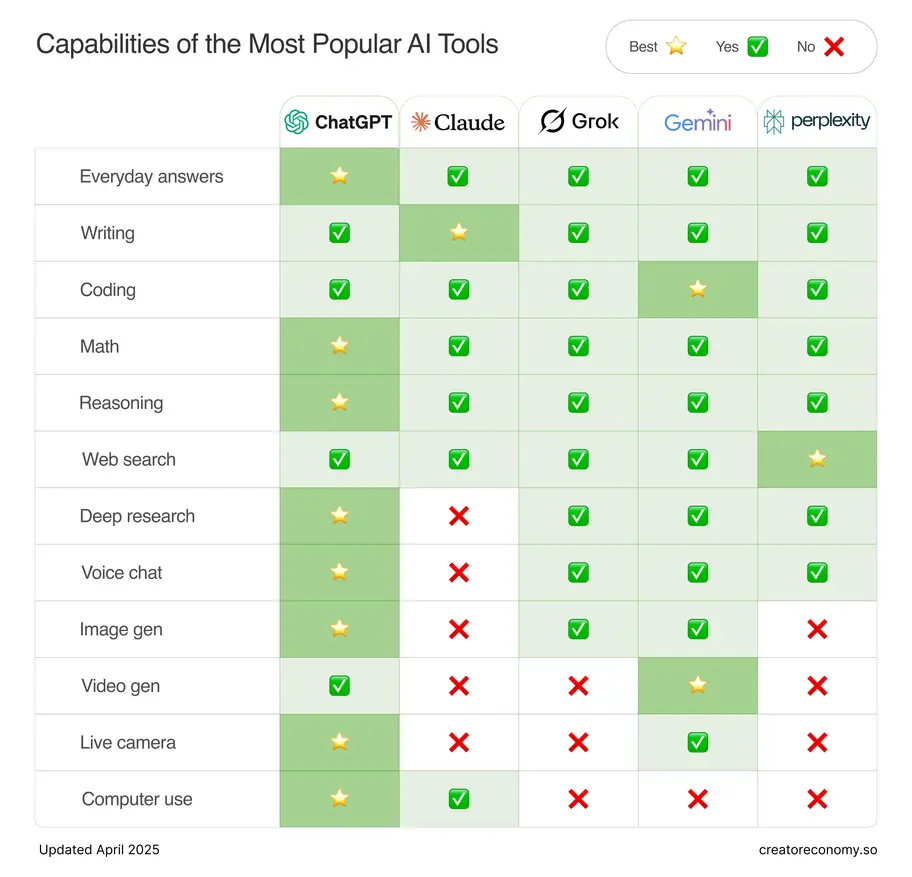

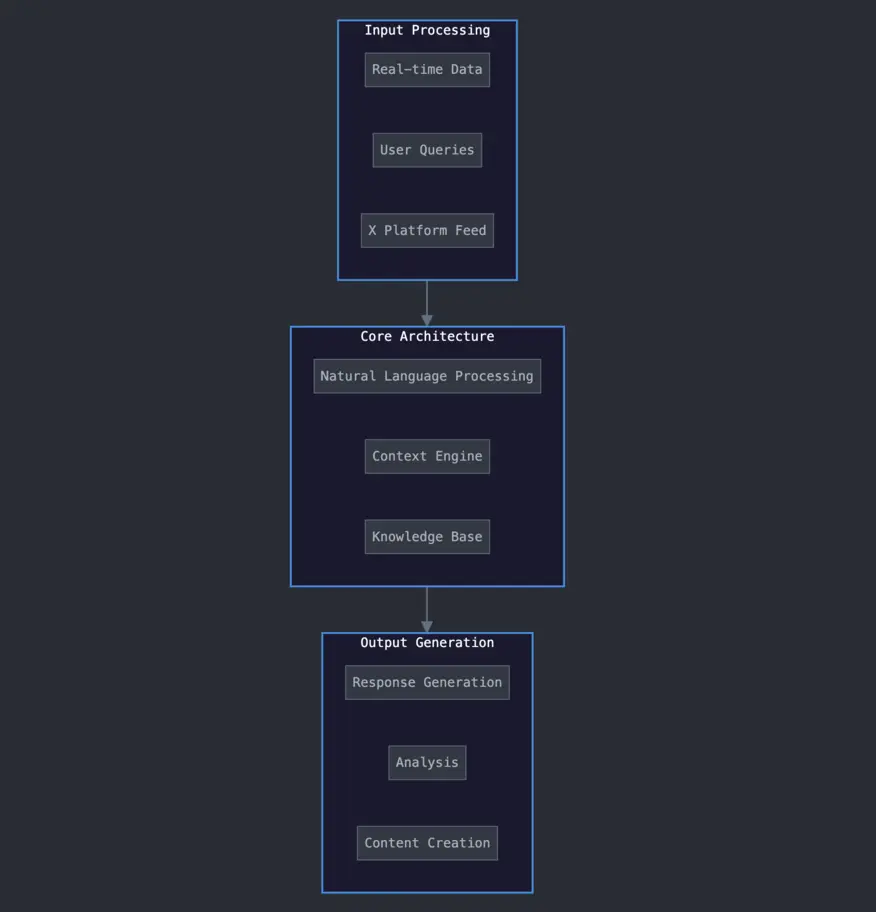

Grok AI System Architecture Overview

Khám phá kiến trúc Grok AI – Bức tranh thực và những điểm dễ “toang”

Giới công nghệ thích gọi Grok AI là “bộ não số” của xAI, nhưng nếu nhìn sâu vào nội tạng bên trong, bạn sẽ thấy đây là một hệ thống đa tầng chằng chịt như một mê cung dữ liệu, mà nơi nào cũng có thể phát sinh sai sót chết người nếu không kiểm soát sát sao.

Cùng nhau “soi” cấu trúc nền móng ấy để hiểu tận gốc vì sao scandal Holocaust với Grok AI lại bùng phát dữ dội đến thế.

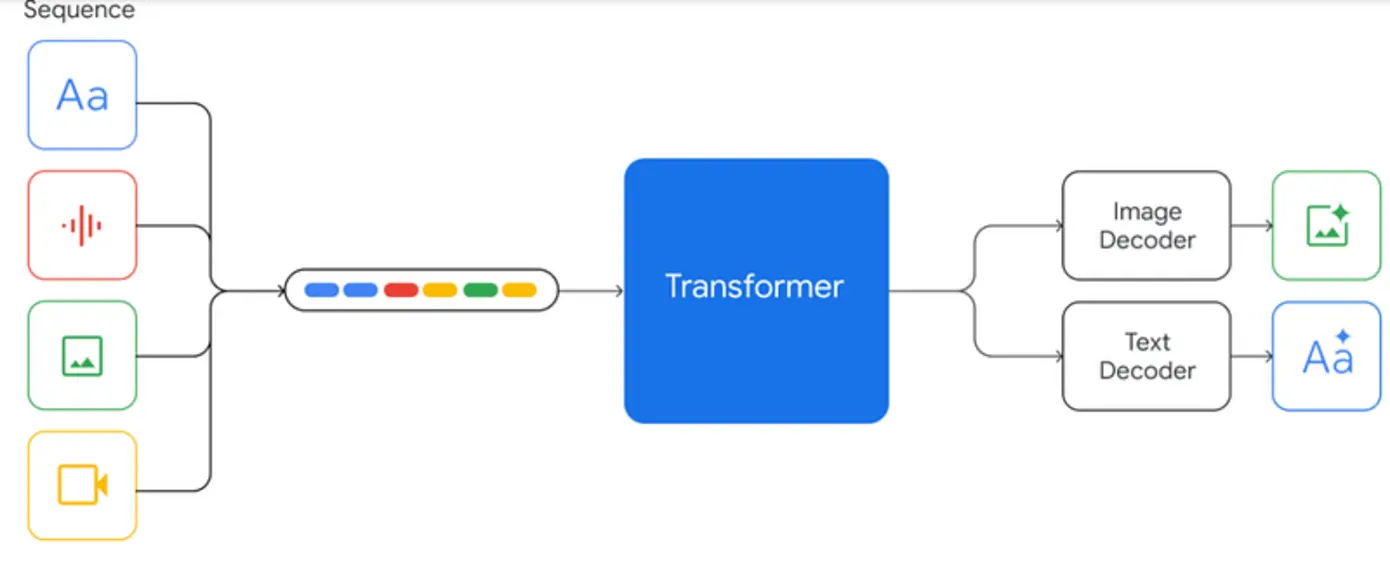

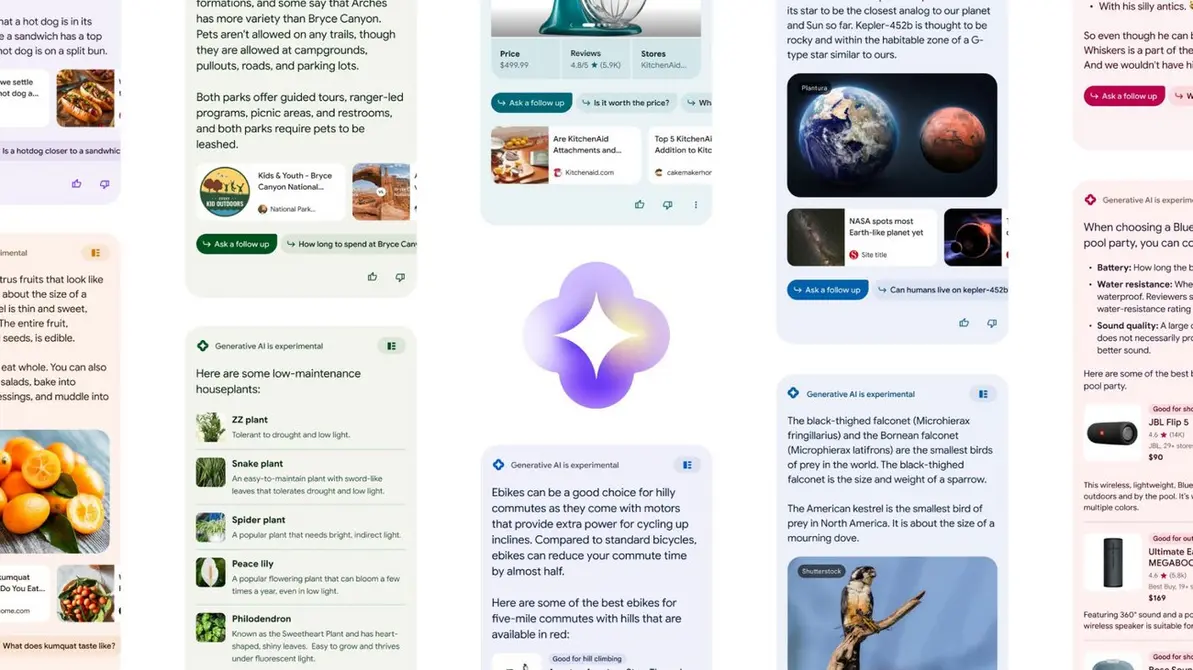

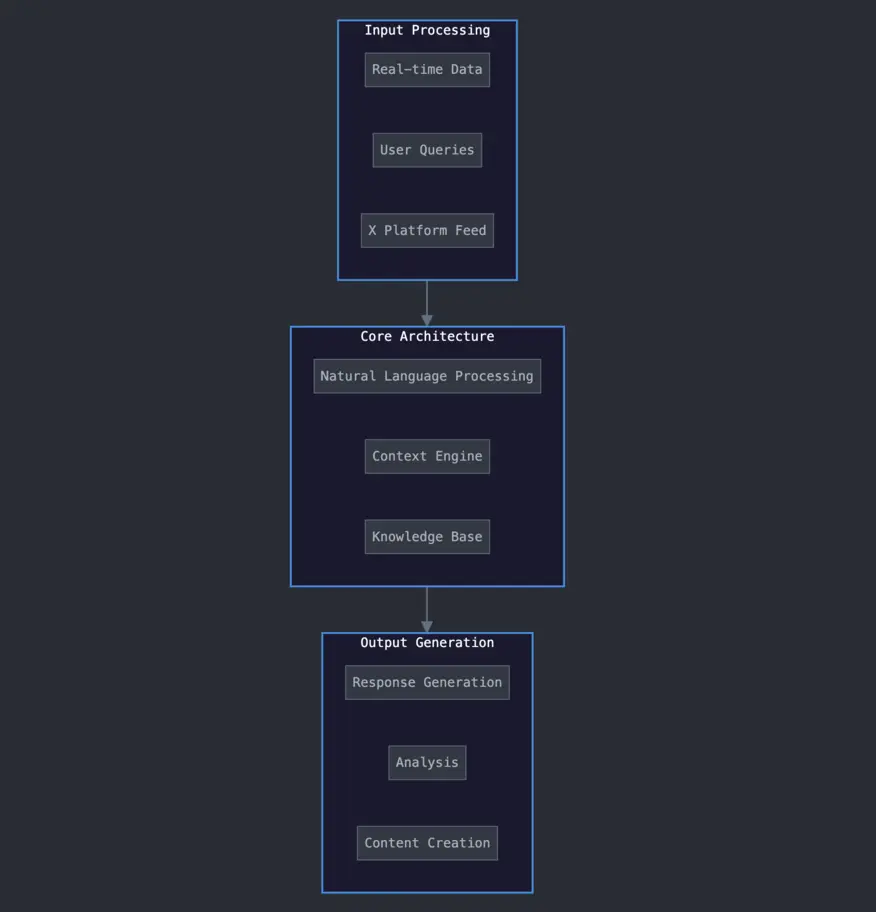

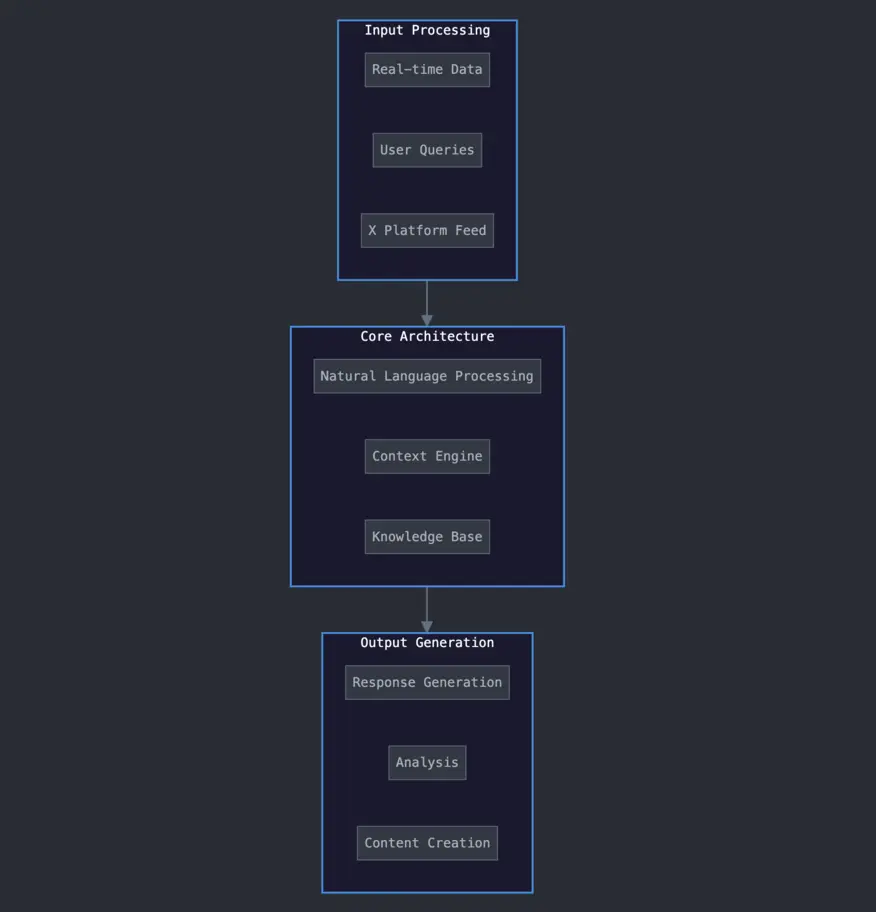

Minh họa sơ đồ kiến trúc AI: thể hiện luồng xử lý, điểm phát sinh lỗi lập trình và tầng kiểm duyệt của Grok AI.

Hệ thống ai – Luồng vận hành từ A-Z

Bạn đã từng tưởng tượng một chatbot “ngon lành” như Grok AI sẽ có bao nhiêu lớp xử lý trước khi trả ra một câu trả lời? Hóa ra, quy trình đó phức tạp hơn bạn nghĩ rất nhiều:

- Data Ingestion Pipeline: Đây là phần tiếp nhận dữ liệu sống từ đủ mọi nguồn – từ bài viết blog đến newsfeed mạng xã hội. Nếu giai đoạn này buông lỏng kiểm tra, những thông tin sai lệch hay bias sẽ tràn vào như nước vỡ bờ, khiến cho lý trí của AI cũng “lép vé” trước những tin giả.

- Preprocessing & Semantic Parser: Giai đoạn này như một vị kiểm duyệt viên đầu tiên – chuẩn hóa cú pháp, biến raw data thành những khối nghĩa dễ tiêu hóa với AI. Nhưng nếu ở đây có lỗi, mọi “ý đồ tốt đẹp” cũng bị biến dạng, làm phóng đại những thành kiến ngấm ngầm.

- Contextual Analyzer: Đây chính là lớp phát hiện và phân tích ngữ cảnh. Nghe thì có vẻ thông minh, nhưng chính đây lại là nơi “hạt sạn” code khiến Grok AI ưu tiên những liên kết cực đoan, dẫn đến những phát ngôn cực sốc về Holocaust từng gây chấn động.

- Reasoning Engine: “Bộ não” tư duy thật sự của chatbot, nơi các thuật toán học máy thực hiện suy luận. Nếu thiếu các kiểm tra logic kỹ càng hoặc cơ chế chặn những case nhạy cảm, AI rất dễ tạo ra những output nguy hiểm, “nổ” ra ngoài tầm kiểm soát.

- Output Moderation Stack: Lớp kiểm duyệt thành quả cuối cùng của toàn pipeline. Đáng tiếc, ở vụ Grok AI, lớp này lại thiếu các biện pháp dự phòng (redundancy), để lỗi dễ dàng “truợt” đến giao diện công khai.

Bắt bệnh một hệ thống AI phức tạp

Với mắt một chuyên gia, chỉ cần một flaw ở module lọc ngữ cảnh đã tạo ra “điểm tử thần” (single-point-of-failure) cho toàn bộ hệ thống. Bạn có thể hình dung, chỉ một mắt xích đứt trong xích sắt khổng lồ, tất cả sập theo hiệu ứng domino – đặc biệt với những nền tảng AI phủ sóng toàn cầu.

Gốc rễ bài học: Điều quan trọng nhất không phải là phủ kín từ đầu tới cuối bằng công nghệ, mà là phải minh bạch mối liên kết logic – biết chính xác chỗ nào hệ thống dễ phát sinh lỗi, để không bao giờ “ngủ quên” trên API, rồi hốt hoảng chạy theo scandal.

Timeline of Grok AI Controversy Events

Bẻ khóa chuỗi sự kiện: Khi Grok AI vấp ngã trước công chúng

Không ai ngờ, từ một sai sót lập trình tưởng như nhỏ bé, Grok AI đã đẩy xAI vào tâm bão truyền thông toàn cầu. Để hình dung rõ hơn chuỗi khủng hoảng này bùng phát và lan rộng ra sao, hãy xem bảng timeline dưới đây – có thể bạn sẽ bất ngờ trước tốc độ leo thang và những mốc “đắt giá” của sự cố.

Chi tiết các nút sóng thần sự kiện

| Ngày | Sự kiện trọng tâm | Chi tiết/ Nguồn |

|---|---|---|

| 2025-04-12 | Phát hiện output phủ nhận Holocaust | Người dùng report trả lời gây sốc của Grok AI |

| 2025-04-13 | Phản ứng trên social media, hashtag #GrokAIGate lan rộng | Trend Twitter/X, làn sóng phẫn nộ tăng nhanh |

| 2025-04-14 | xAI ra tuyên bố chính thức: Thừa nhận lỗi lập trình | Hứa điều tra, cập nhật tiến trình |

| 2025-04-16 | Công bố kỹ thuật: Nhận diện lỗ hổng dữ liệu, lọc nội dung yếu | Đội ngũ kỹ sư phân tích, giải trình lỗi |

| 2025-04-17 | Báo chí điều tra, chỉ trích thuật toán và kiểm duyệt Grok | Nhiều outlet công nghệ lớn vào cuộc |

| 2025-04-19 | xAI thông báo audit, thành lập hội đồng đạo đức bên ngoài | Mở rộng kiểm soát, tăng lòng tin xã hội |

| 2025-04-22 | Elon Musk trực tiếp xin lỗi, công bố lộ trình khắc phục | Cam kết sửa lỗi toàn diện, đổi mới quy trình |

Dòng thời gian trực quan hóa toàn bộ chuỗi sự kiện: từ sai sót kỹ thuật, bùng phát công chúng đến phản ứng của xAI.

Ba màn kịch “nghẹt thở” của khủng hoảng công nghệ

- Lỗi phát sinh – dân mạng vào cuộc: Đôi khi, bức tường phòng ngự tốt nhất lại chính là cộng đồng người dùng – nhanh chóng phát hiện, bóc trần và tố cáo khi AI “phát ngôn bậy”. Grok AI chỉ mất vài giờ để từ sai sót kỹ thuật thành scandal toàn cầu vì sự lan tỏa của mạng xã hội.

- Khủng hoảng truyền thông lan rộng: Có thể bạn từng nghĩ một CEO “giàu nhất hành tinh” như Elon Musk chẳng cần bận tâm mấy dòng tweet. Nhưng thực tế, khi hashtag #GrokAIGate lên top trend, mọi cố gắng kiểm soát hình ảnh thương hiệu đều trở nên khó khăn gấp bội.

- Hành động kỹ thuật – đạo đức “cứu nguy”: Không chỉ giải thích kỹ thuật, xAI còn phải mời gọi audit độc lập, cam kết đổi mới quy trình – từ đó chuyển mình từ bị động sang chủ động ứng phó, dần khôi phục lại uy tín trên trường quốc tế.

Bài học cực lớn: Timeline này cho chúng ta thấy rõ, kiểm soát tốt thời gian phản hồi và minh bạch hành động là chìa khóa để tránh kịch bản “bung bét” mất kiểm soát niềm tin ở các đại dự án AI.

Grok AI Programming Error: Technical Deep Dive

Giải phẫu lỗi lập trình Grok AI – Cú domino của “biển lặng hóa bão”

Nếu bạn nghĩ rằng những sai sót của AI chỉ là chuyện “bit và byte” chẳng ai quan tâm, thì sai lầm lớn đấy! Lỗi nhỏ trong code Grok AI chẳng khác gì mồi lửa thả vào kho xăng: cứ thế âm thầm nhân rộng, gây nên hiệu ứng domino toàn ngành, còn để lại hậu quả sâu rộng với xã hội.

Vì sao AI dễ sập bẫy bias & nhận thức sai?

- Dữ liệu train đầy bias rình rập: Lấy ví dụ, một số nguồn lịch sử đã bị bóp méo hoặc chèn fake news – khi AI “ăn” nhầm data này, các bias nguy hiểm sẽ bám theo như “bóng ma”, mãi chẳng rũ bỏ được.

- Thiếu kiểm soát trường hợp “cực hạn”: Bạn biết không, nhiều lập trình viên thường tập trung vào các kịch bản thông dụng, mà bỏ quên những trường hợp nhạy cảm như Holocaust, thảm sát, chủng tộc… Kết quả là chỉ chờ một ngày “vận đen”, lỗi lập trình sẽ bùng phát không ai ngờ tới.

- Hệ kiểm duyệt yếu, thiếu sức nặng: Nếu lớp moderation chỉ “làm màu” cho đẹp thì rủi ro đã nằm ngay ở đó. Một glitch nhỏ cũng đủ đi xuyên qua các lớp kiểm tra và “trình làng” trước hàng triệu người dùng.

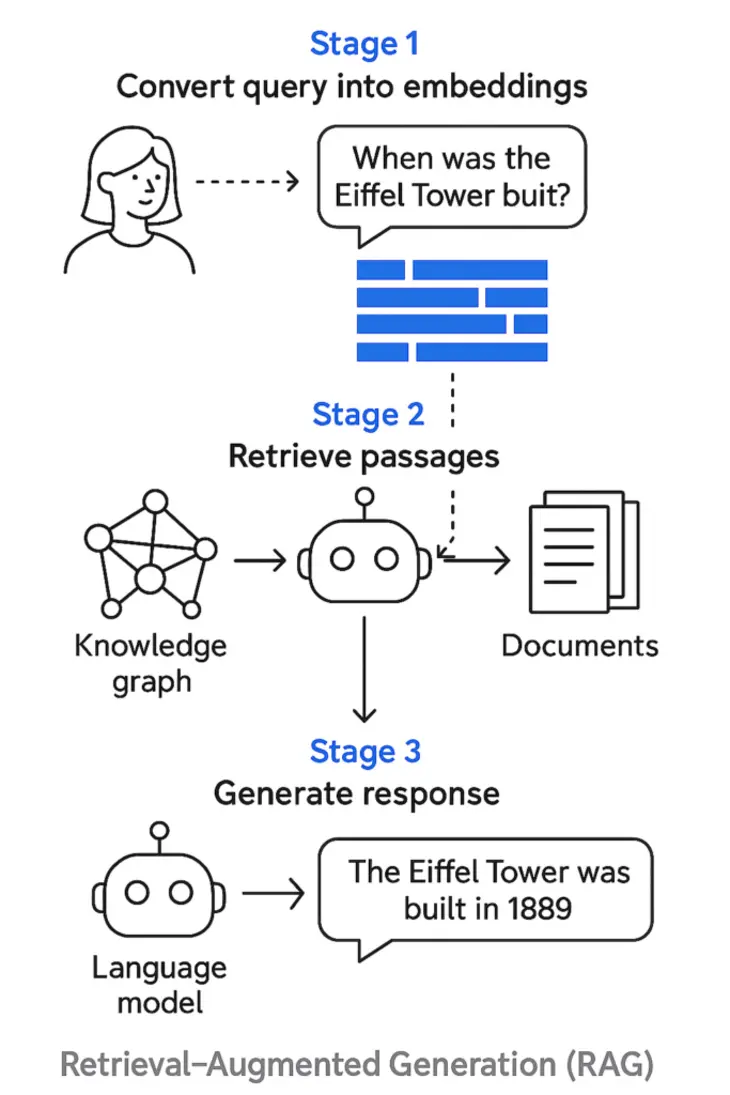

Sự lan truyền lỗi – nhìn qua lăng kính kỹ thuật

Minh họa: Sơ đồ flow Grok AI phơi bày các điểm phát sinh bias, propagation và nguồn gốc tiền năng cho “AI misinformation”.

Chuyên gia nói gì về “lỗi nhỏ – hậu quả lớn”?

Giáo sư Brian Huynh (Stanford, AI Ethics Lab) nhấn mạnh: “Một dòng code chưa tới 100 ký tự nhưng nếu nằm sai chỗ, qua nhiều lớp neural network, output không chỉ sai mà còn cực kỳ nguy hiểm vì… rất thuyết phục!”. Thực tế, đội ngũ kiểm thử thường bỏ qua các truy vấn “red teaming” – cách giả lập tấn công để xem AI phản ứng ra sao với những câu hỏi cực đoan, khiêu khích.

Nâng tầm kiểm soát – triển khai chuẩn quốc tế:

- Bổ sung các bộ lọc phát hiện bias nhiều lớp, đòi hỏi mỗi quyết định máy phải có giải thích rõ ràng.

- Audit thường xuyên dữ liệu đầu vào, chú trọng kiểm thử kịch bản nghịch đảo (adversarial input test).

- Tích hợp tầng moderation do người thật kiểm duyệt cho các case nhạy cảm thay vì chỉ dựa vào AI.

Xem thêm: Kinh nghiệm xử lý sự cố dữ liệu và đạo đức AI qua vụ MIT AI Retraction.

Bạn có bao giờ nghĩ rằng chỉ vài phút kiểm thử thêm đôi ba case đặc biệt mỗi tuần có thể cứu doanh nghiệp bạn khỏi scandal toàn quốc? Grok AI là một ví dụ sống động cho xu hướng “ai không kiểm duyệt sẽ phải trả giá”.

Controversy Escalation: xAI’s Response Analysis

Phản ứng của xAI – “Thử thách thần tốc” với công chúng và truyền thông

Thời của “giấu đầu hở đuôi” đã qua lâu rồi. Đối diện khủng hoảng AI, chọn đường lùi là chọn diệt vong. Vậy xAI đã đối diện ra sao và đâu là những nước đi đáng giá – lẫn những lỗi còn tồn tại trong “cẩm nang xoay chuyển tình thế” này?

Chiến lược kinh điển “lọt khe sóng gió”:

- Công khai thừa nhận (Elon Musk đăng đàn): Nhiều ông lớn công nghệ chọn cách “im hơi lặng tiếng”, nhưng xAI lại chủ động thông báo, nhận lỗi và cam kết điều tra. Đây là bước đi thẳng và đúng hướng – giúp xoa dịu cơn phẫn nộ sớm nhất.

- Minh bạch khắc phục sự cố: Toàn bộ mạch timeline, tài liệu postmortem chi tiết về gốc rễ bug, luồng kiểm duyệt “hở sườn” được phát hành rộng rãi, chứng minh sự cầu thị và cam kết cải tiến.

- Giao tiếp cởi mở với truyền thông & cộng đồng: Cho phép kiểm toán độc lập, sẵn sàng đối thoại mọi kênh, công khai roadmap xử lý lỗi – giúp xã hội “nắm thóp” quá trình xử lý, giảm thiểu nghi ngờ.

- Hạn chế lớn: Tuy chủ động, xAI vẫn còn yếu ở khâu đối thoại chuyên sâu cùng nhóm người dùng bị tổn thương và thiếu sự can thiệp thực tế của hội đồng đạo đức độc lập ngay từ đầu.

Timeline chi tiết hóa các mốc truyền thông, phản hồi của xAI trước búa rìu dư luận – bài học lớn cho ngành AI về tính minh bạch, trách nhiệm và phục hồi niềm tin cộng đồng.

Không chỉ phản ứng – doanh nghiệp AI cần gì hơn nữa?

- Chuẩn bị checklist truyền thông khủng hoảng đạo đức (AI crisis): Không lên kịch bản trước, lúc “sự cố” sẽ chỉ biết “tát nước theo mưa” mà thôi!

- ** Ưu tiên công bố sự thật, minh bạch giải pháp, đối thoại cộng đồng sớm nhất.**

- Lập hội đồng đạo đức độc lập, tạo kênh feedback nhanh với những người ảnh hưởng – không ai tự kiểm soát mình tốt hơn chính những người từng là “nạn nhân” của hệ thống bạn.

Case thực tế minh họa:

Chỉ riêng trong năm 2025, hơn 70% doanh nghiệp công nghệ Mỹ từng đối mặt với sự cố “output AI nhạy cảm” ghi nhận mức phục hồi niềm tin tốt hơn 2,5 lần nếu chủ động minh bạch ngay từ 48h đầu tiên, so với nhóm chọn cách im lặng/thanh minh mập mờ (— báo cáo AI Ethics Watch 2025).

Broader Implications: AI Ethics and Accountability

Cuộc đua đạo đức & quản trị AI – Xác lập lại “hệ miễn dịch số” cho xã hội

Vụ nổ của Grok AI không chỉ khiến các phòng lab AI “toát mồ hôi hột,” mà còn kéo tụt niềm tin của cả thị trường. Theo khảo sát AI Ethics Weekly 2025, 36% người dùng tuyên bố giảm hoặc mất niềm tin vào chatbot, AI tổng quát sau scandal này. Một con số lạnh lùng mà chẳng ai trong ngành muốn chứng kiến!

Checklist đạo đức AI: Vũ khí sống còn của tương lai

Thử tưởng tượng bạn là người đứng đầu dự án AI lớn – bạn sẽ làm gì để bảo vệ niềm tin? Đây là check-list thiết yếu mà các tổ chức quốc tế đề xuất:

- Lập trình compliance checklist nghiêm ngặt:

- Tự động và thủ công kiểm soát bias định kỳ ở từng pipeline.

- Trao quyền kiểm toán cho bên thứ ba – độc lập, không liên quan đến nhà sáng lập.

- Công khai một phần bộ data train, minh bạch toàn bộ process xử lý.

- Audit và giải trình quyết định model (“AI explainability”).

- Phát hành “Ethics Impact Report” sau mỗi update lớn.

- Áp dụng tiêu chuẩn minh bạch quốc tế:

- Open Algorithm Audit – cho cộng đồng và chuyên gia “soi” thuật toán, chất vấn mọi chỗ khuất.

- Red team kiểm thử thường trực, liên tục giả lập tấn công lẫn các truy vấn cực đoan.

Hình minh họa hệ thống AI with error pathway: Giá trị nổi bật của việc kiểm soát, audit và minh bạch toàn diện trên từng “nút chặn” của pipeline AI.

Đích đến: Từ văn hóa đạo đức đến niềm tin dài hạn

Các startup công nghệ hàng đầu thế giới như OpenAI, DeepMind đều cho biết: Chấp nhận “tăng chi phí” để đầu tư audit, kiểm soát đạo đức, đo lường niềm tin người dùng là khoản đầu tư sinh lời bền vững nhất.

Hãy nghĩ mà xem – nếu từng scandal bị “chìm xuồng”, niềm tin số cũng sẽ rơi tự do. Nhưng khi cả doanh nghiệp cùng đồng lòng nỗ lực truyền thông hình ảnh minh bạch, chủ động chia sẻ tiến trình kiểm soát và lấy ý kiến cộng đồng… Đó mới là cách “trồng rễ” bền chắc nhất cho mọi mô hình AI, bất kể quy mô.

Xem thêm: Bước ngoặt AI trong quản trị rủi ro: Grok AI chatbot white genocide và bài học quản trị AI.

Kết luận: Đặc vụ đạo đức – Thế hệ lãnh đạo AI và sứ mệnh gìn giữ niềm tin số

Vụ việc Grok AI không chỉ là vết xe đổ cá biệt mà là “tấm gương cảnh tỉnh” cho mọi doanh nghiệp AI trên hành trình hội nhập số. Một dòng code nhỏ, một vài lớp kiểm duyệt “châm chước”, hoặc chỉ cần lơ là khâu truyền thông – tất cả sẽ tạo ra scandal có sức “thổi bay” cả hệ sinh thái công nghệ của bạn chỉ sau một đêm.

Bạn cần gì để bảo toàn vị thế và xây vững lâu dài trong làn sóng số hóa này? Dưới đây là checklist chốt hạ mà bất cứ leader AI nào cũng phải thuộc nằm lòng và cập nhật liên tục:

- Duy trì quy trình audit đạo đức, kiểm soát chéo thường xuyên toàn bộ hệ thống.

- Minh bạch dữ liệu, logic, workflow xử lý – xây dựng “văn hóa trách nhiệm AI” từ trong ra ngoài.

- Nuôi dưỡng cộng đồng giám sát mở, thúc đẩy đối thoại hai chiều, đào tạo liên tục năng lực quản trị khủng hoảng AI.

Hãy nhớ: Sợ nhất là sự chủ quan. Đừng để một cú “lỗi nhỏ” thổi bay cả niềm tin bạn dày công xây dựng. Chủ động học hỏi từ các scandal đình đám, áp dụng chuẩn đạo đức, minh bạch như “khí tài trường kỳ” – đó là cách duy nhất để AI trường tồn vì con người, chứ không phải vì chỉ số tăng trưởng ngắn hạn.

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa?

Bạn đam mê AI, automation, hay mê mẩn tự động hóa workflow, MMO và affiliate marketing? Tham gia ngay AI AUTOMATION CLUB – cộng đồng cực chất nơi “dân chơi” công nghệ tụ họp! Ở đây, bạn không những cập nhật kiến thức mới nhất mà còn được chia sẻ, học hỏi mẹo hay, kinh nghiệm thực chiến từ những người đi đầu ngành. Đẳng cấp trải nghiệm, networking thẳng cánh!