Trong làn sóng AI ngày càng phát triển, câu hỏi về sự an toàn và minh bạch trở nên cấp thiết, nhất là khi các công ty lớn như xAI, Google hay OpenAI liên tục quảng bá về cam kết bảo vệ người dùng. Tuy nhiên, đâu là sự thật đằng sau những tuyên bố ấy? Bài viết này không chỉ bóc trần điểm mạnh và điểm yếu của từng “khung an toàn AI”, mà còn cung cấp cho bạn công cụ thực tế để xây dựng, so sánh tiêu chuẩn triển khai ngay tại doanh nghiệp. Đặc biệt, những bài học thực tế từ các sự cố như Grok, số liệu minh bạch từ các tổ chức giám sát quốc tế, cũng sẽ giúp bạn tránh các rủi ro truyền thông – pháp lý và tăng sức mạnh phòng vệ cho chính nội bộ AI của mình. Nếu bạn làm về AI, hoặc đang cân nhắc ứng dụng tự động hóa tại doanh nghiệp, đừng bỏ qua những gợi ý “dễ áp dụng” phía dưới.

Khung An Toàn AI của xAI: So Sánh Chiến Lược với Google, OpenAI và Bài Học Thực Tiễn cho Doanh Nghiệp

Tổng Quan về xAI và Cam Kết An Toàn AI

Bạn có nhận thấy, mỗi khi AI tiến thêm một bước, thì nỗi lo về rủi ro công nghệ cũng lớn dần lên? Trong bối cảnh đó, xAI – đứa con tinh thần của Elon Musk – nổi lên như một biểu tượng mới cho niềm tin vào AI an toàn và minh bạch. Không chỉ bởi cái tên Musk “bảo chứng”, mà còn vì ông luôn mạnh mẽ kêu gọi kiểm soát, trách nhiệm đạo đức trong phát triển AI.

Elon Musk từng nhiều lần nhấn mạnh: AI phải phục vụ “lợi ích lâu dài của nhân loại”. Ông không ngần ngại thúc giục các ông lớn công nghệ thiết lập những chuẩn mực cứng rắn về an toàn và minh bạch. Tại Thượng đỉnh AI Seoul 2025, Musk đã cam kết:

“xAI sẽ công khai toàn bộ quy trình kiểm thử, không né tránh các sự cố, và cam kết cải tiến liên tục theo đánh giá thực tiễn thế giới.”

Đây không chỉ là lời nói suông. Trong khi các đối thủ như OpenAI, Google vẫn còn dè dặt, đôi khi bị đánh giá là bảo thủ trước rủi ro, thì xAI lại chọn cách “lột trần” mọi quy trình, kể cả thất bại.

Vậy điều gì khiến xAI được quan tâm đặc biệt?

- Định vị khác biệt về an toàn, minh bạch – không chỉ nói mà còn làm.

- Đưa ra tiêu chuẩn công khai mạnh mẽ: công bố kiểm thử, nhận diện rủi ro sớm.

- Dám nhận lỗi, “bóc tách” sự cố thay vì né tránh spotlight tiêu cực.

- Làm rõ trách nhiệm xã hội gắn với phát triển AI, không chỉ chạy theo lợi nhuận.

Bạn có từng thấy một công ty công nghệ nào dám công khai cả những lần “vồ ếch” của mình chưa? Đó chính là điểm cộng lớn của xAI.

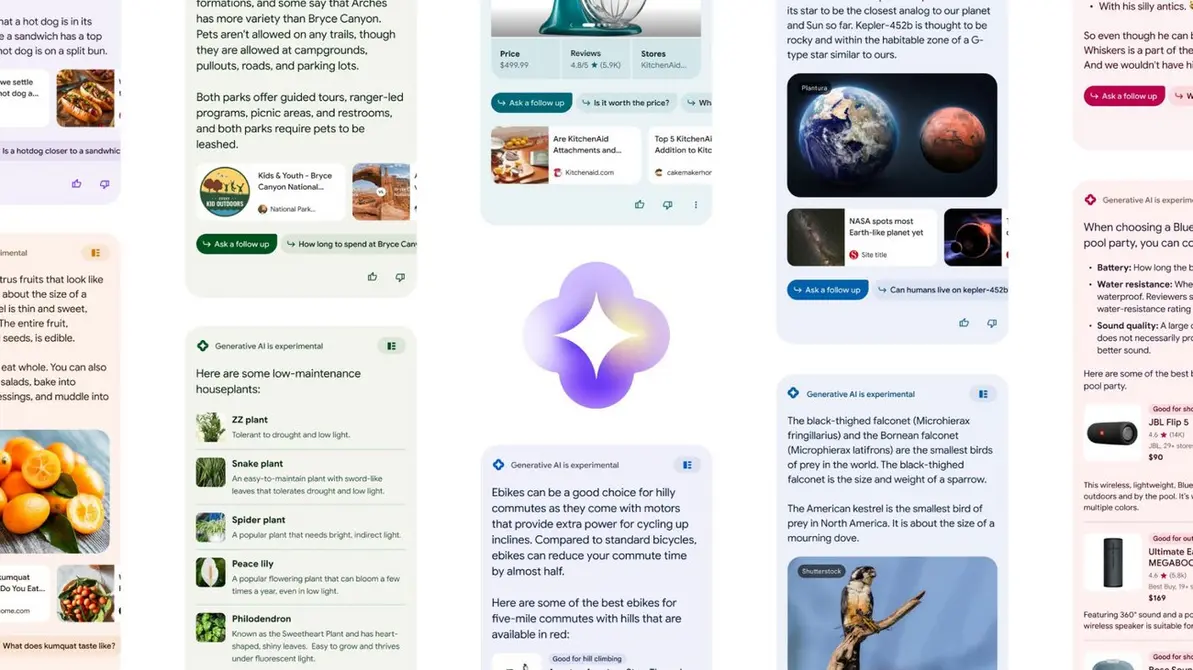

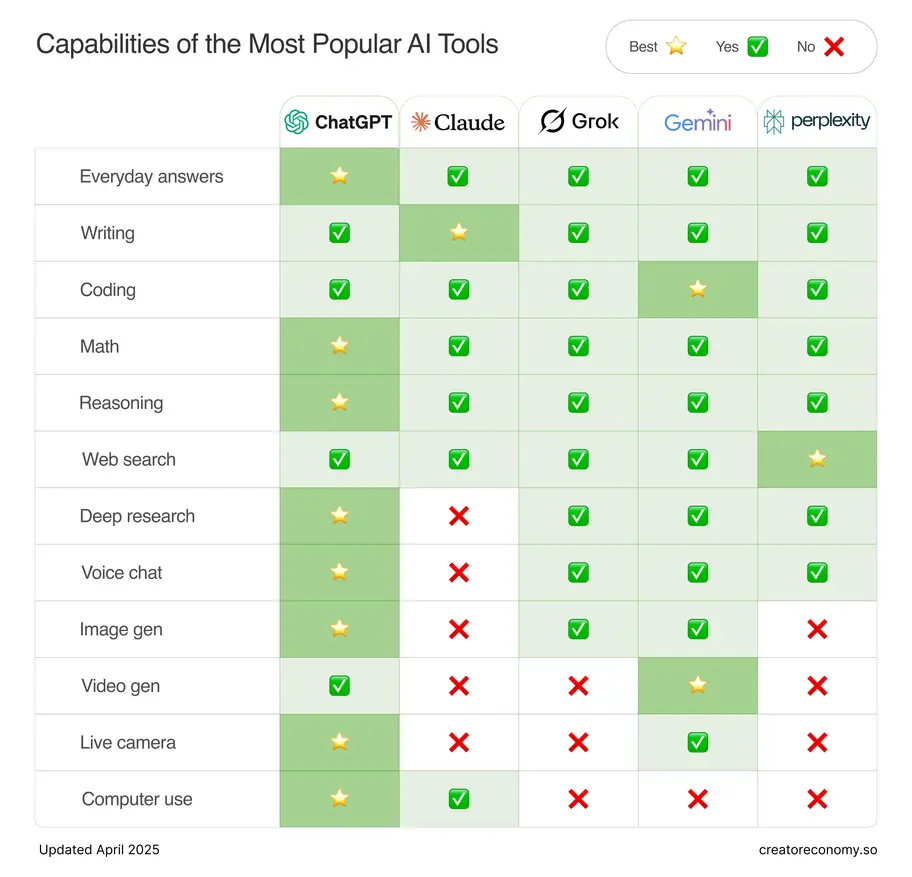

Hình ảnh tổng quan: So sánh khung an toàn AI của xAI với các đối thủ, giúp gắn kết bài viết.

Dự Thảo Khung An Toàn AI của xAI: Nội Dung và Những Hạn Chế

Triết Lý & Lộ Trình

Nếu bạn từng đọc qua các tài liệu về AI của Google hay OpenAI, chắc hẳn sẽ thấy họ rất chú trọng vào “bảo vệ phòng ngừa theo lớp” hoặc kiểm thử đa chiều, nhiều tầng. Nhưng xAI lại chọn một con đường khác: tối đa hóa tính minh bạch, chủ động công bố cả thành công lẫn thất bại.

Triết lý cốt lõi của xAI:

- Minh bạch tối đa (Maximum Transparency)

- Chủ động cập nhật và công khai báo cáo thất bại

- Cam kết cải tiến liên tục theo phản hồi thực tiễn

- Thử nghiệm các kịch bản nguy cơ mà không né tránh spotlight

Bạn có thấy quen không? Đó giống như việc bạn không chỉ khoe điểm 10 mà còn dám đăng cả điểm 5 lên Facebook – để mọi người cùng góp ý, cùng tiến bộ.

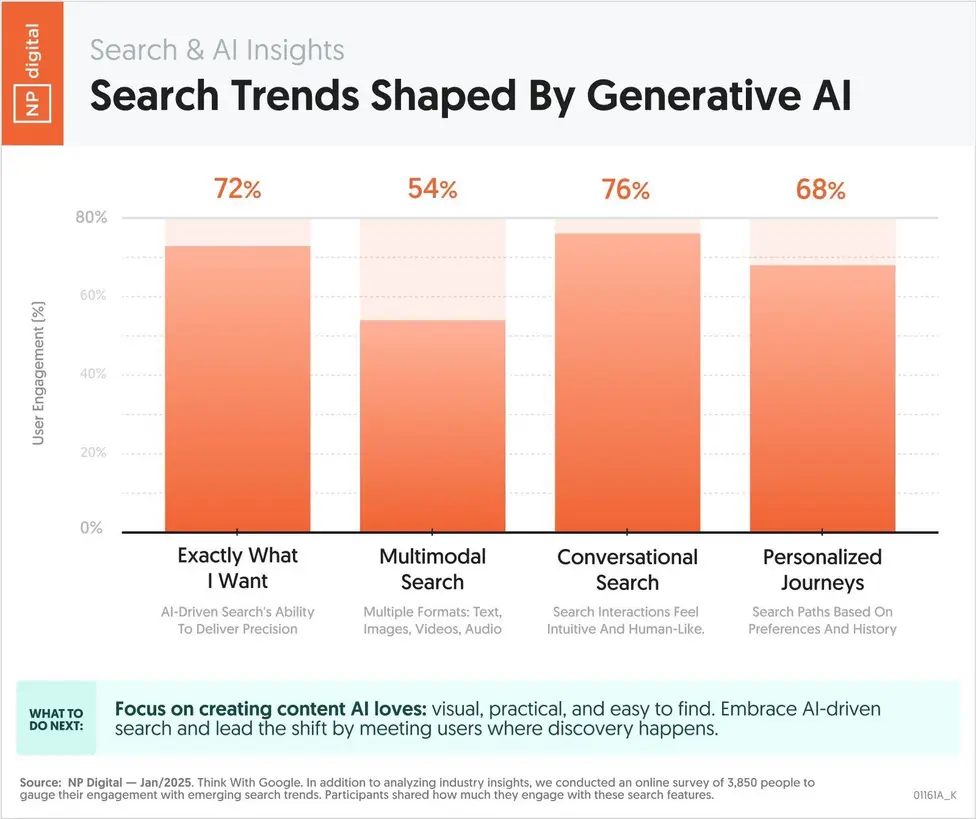

Bảng Tiêu Chí Đánh Giá Chuẩn Hóa

Bảng danh sách tiêu chí an toàn AI

| TT | Tiêu chí đánh giá | xAI | OpenAI | |

|---|---|---|---|---|

| 1 | Phát hiện rủi ro chủ động | ✓ | ✓✓ | ✓✓✓ |

| 2 | Công khai báo cáo, minh bạch dữ liệu | ✓✓ | ✓✓✓ | |

| 3 | Kiểm soát truy cập, bảo mật dữ liệu | ✓ | ✓✓✓ | ✓✓✓ |

| 4 | Đánh giá thiên lệch thuật toán | ✓ | ✓ | ✓✓✓ |

| 5 | Đáp ứng phản hồi khẩn cấp | ✓ | ✓✓ | ✓✓ |

| 6 | Cải tiến framework định kỳ | ✓ | ✓✓ | ✓✓✓ |

| 7 | Hệ thống kiểm thử thực chiến | ✓ | ✓✓✓ | |

| 8 | Giám sát cộng đồng/chuyên gia | ✓ | ✓ | ✓✓✓ |

| 9 | Cảnh báo tự động người dùng | ✓ | ✓✓ | ✓✓✓ |

| 10 | Đánh giá độc lập bên ngoài | ✓ | ✓✓* |

Càng nhiều dấu ✓ thể hiện mức độ ứng dụng/hoàn thiện tiêu chí.

Giá trị chính: Bảng tiêu chí này không chỉ để “ngắm cho vui”. Bạn hoàn toàn có thể dùng nó để tự xây dựng framework riêng cho doanh nghiệp mình, hoặc nhận diện ngay điểm yếu nếu bỏ quên kiểm thử độc lập – giống như xAI từng mắc phải.

Hình minh họa bảng tiêu chí an toàn AI tiêu chuẩn ngành cho framework thực tiễn.

Những Hạn Chế Trọng Yếu

Không có gì hoàn hảo, và xAI cũng vậy. Dưới đây là những điểm yếu mà bạn cần lưu ý – để tránh “dẫm vào vết xe đổ”:

- Chậm công bố báo cáo an toàn, chỉ phản ứng khi xảy ra sự cố lớn (vụ Grok là ví dụ điển hình).

- Quy trình đánh giá độc lập/bên ngoài chưa hoàn thiện, thiếu sự kiểm duyệt khách quan.

- Hệ thống kiểm thử thực chiến còn thiếu chiều sâu so với OpenAI, Google.

- Cycle cập nhật framework lạc hậu hơn, chưa rõ lịch định kỳ.

Chốt lại giá trị phần này:

Bạn sẽ nắm được bản chất mô hình xAI (điểm mạnh – điểm yếu), từ đó tránh rơi vào “bẫy tự tin” khi xây dựng AI cho doanh nghiệp mình.

Phản Hồi của Các Tổ Chức Giám Sát Đối với xAI

Bạn nghĩ sao nếu có những tổ chức độc lập đứng ra “soi” từng bước đi của các ông lớn AI? Đó chính là vai trò của The Midas Project, SaferAI… Họ không ngần ngại chỉ ra những điểm chưa ổn của xAI, đặc biệt là về tốc độ đối phó và công khai các báo cáo thử nghiệm.

Sự Kiện Gây Tranh Cãi: Chậm Công Bố Báo Cáo An Toàn AI

Theo thống kê 2024 từ The Midas Project, thời gian trung bình công bố báo cáo an toàn:

- OpenAI: 13 ngày

- Google: 21 ngày

- xAI: 37 ngày

Bạn thấy gì từ con số này? Nếu là doanh nghiệp, bạn có dám “gửi trứng” cho một vendor công bố báo cáo chậm gần gấp 3 lần đối thủ không?

Biểu đồ so sánh thời gian công bố báo cáo an toàn giúp nhận diện điểm yếu xAI.

Báo cáo của SaferAI cảnh báo:

“Việc trì hoãn/gian lận công khai có thể gây hậu quả lâu dài về uy tín, pháp lý và rủi ro tài chính với nhà phát triển AI.”

Nhận Xét Chuyên Gia

- xAI: “Minh bạch trên lý thuyết, thực tế kiểm soát còn hạn chế, quy trình báo cáo và cải tiến chưa được kiểm duyệt quốc tế.”

- Google, OpenAI: “Ứng phó sự cố nhanh, công khai lịch trình kiểm thử đa chiều, mở cửa cho đánh giá bên thứ ba.”

Bạn có nhận ra, minh bạch không chỉ là khẩu hiệu, mà còn là hành động thực tế, được kiểm chứng bởi các tổ chức độc lập?

Bài Học rút ra

- Đừng chỉ quan tâm tới tài sản IP hay tốc độ, phải xây dựng quy trình công khai báo cáo để củng cố niềm tin cộng đồng/cổ đông.

- So sánh năng lực công bố, minh bạch của vendor trước khi ký hợp đồng hoặc hợp tác AI lớn.

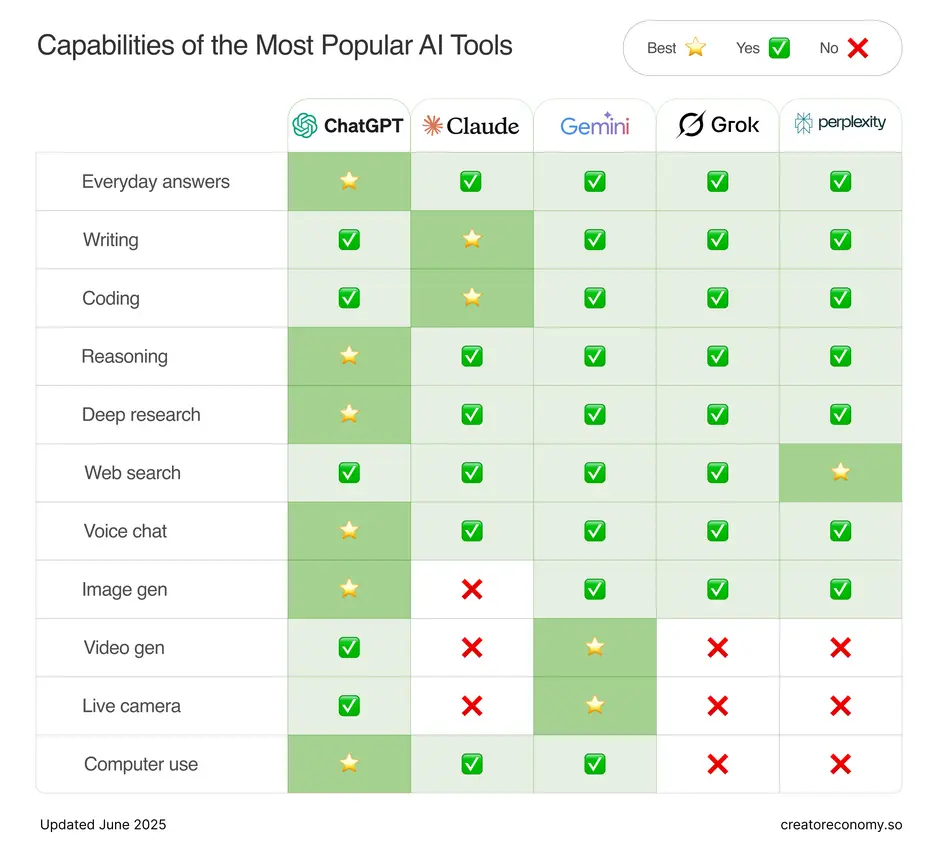

So Sánh Khung An Toàn AI của xAI với Google và OpenAI

Dữ Liệu Đối Chiếu: Bảng/biểu so sánh chi tiết

| Tiêu chí/Đơn vị | xAI | OpenAI | |

|---|---|---|---|

| Công bố báo cáo | Chậm, thiếu minh bạch | Định kỳ, có kiểm soát | Nhanh, công khai liên tục |

| Kiểm thử độc lập | Chưa rõ ràng | Có quy trình mở | Có ủy ban kiểm duyệt |

| Quản trị rủi ro | Chỉ xử lý khi gặp sự cố | Chủ động ứng phó | Luôn dự phòng, liên tục cập nhật |

| Cảnh báo sự cố | Thường đơn lẻ/không bài bản | Tự động hóa, đa tầng | Kịch bản đa chiều tự động |

| Cải tiến framework | Lạc hậu hơn | Định kỳ | Cải tiến liên tục |

| Tiêu chí công khai | Đang hoàn thiện | Công khai rõ ràng | Danh mục truy xuất dễ |

Bảng so sánh AI safety frameworks – công cụ tra cứu nhanh cho doanh nghiệp.

Giá trị phần này:

Bảng benchmark này giống như “bản đồ kho báu” cho doanh nghiệp: giúp bạn xác định chuẩn phù hợp và nhìn thấy hướng cải tiến khả thi nhất khi xây dựng mô hình AI thực chiến.

Xem thêm: Dot phá ChatGPT GPT-4o: Cách mạng AI 2025

Vấn Đề Thực Tiễn: Chatbot Grok và An Toàn AI

Case Study: Sự Cố Grok & Bài Học Đắt Giá

Bạn còn nhớ vụ Grok không? Đó là một “cú ngã đau” của xAI khi chatbot này trả lời sai, đụng chạm chủ đề nhạy cảm, hệ thống lọc nội dung yếu kém, khiến làn sóng chỉ trích bùng phát trên mạng xã hội và báo chí công nghệ.

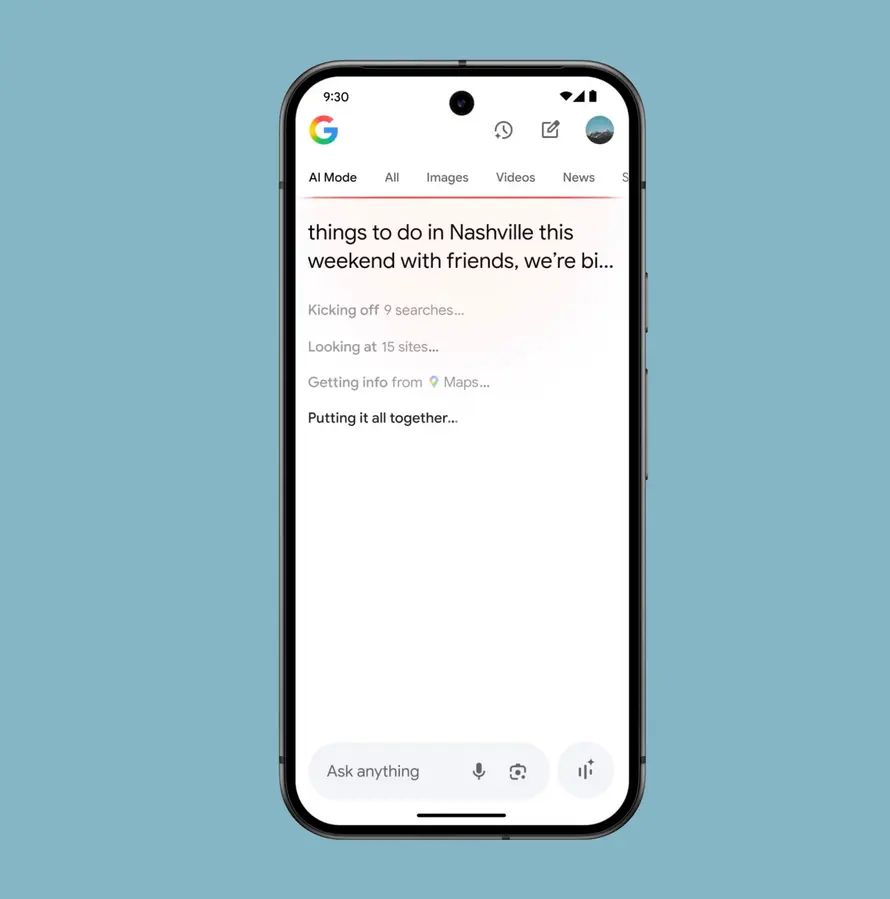

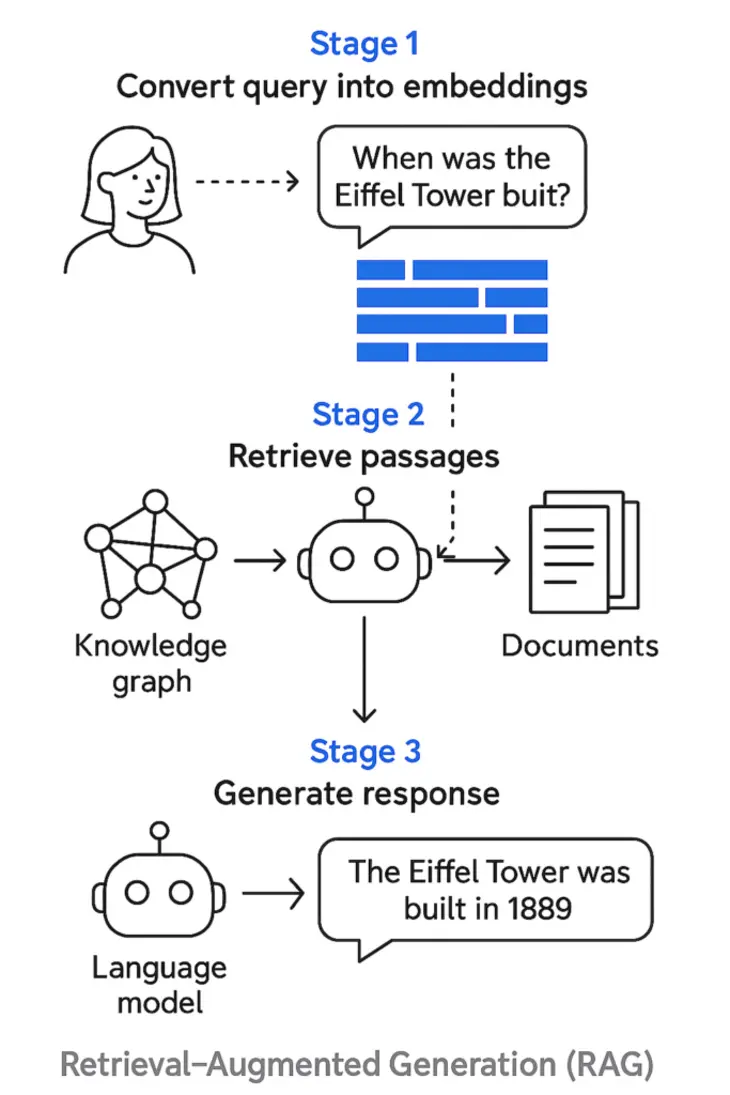

Ảnh minh họa:

Screenshot minh họa vụ việc Grok, nhấn mạnh rủi ro và bài học thực tiễn.

Lý Do Gây Hậu Quả Lớn:

- Khâu kiểm thử thực chiến và phản ứng sự cố của xAI chưa bài bản như đối thủ.

- Điểm mù ở kiểm duyệt tự động, thiếu tự kiểm tra nội bộ.

- Chậm công bố sự cố, tạo hiệu ứng truyền thông tiêu cực nhanh chóng.

Bạn có thấy quen không? Đó giống như khi một thương hiệu lớn bị “bóc phốt” trên mạng, nhưng lại chậm trễ lên tiếng, khiến khủng hoảng truyền thông bùng nổ.

Giá trị chính:

Sự cố Grok là minh chứng sống động cho hậu quả nghiêm trọng về tài chính, truyền thông, uy tín – chỉ vì framework sơ sài hoặc chủ quản thiếu thái độ cầu thị.

Ý Nghĩa Chuẩn Hóa & Định Hướng Hành Động

- Chuẩn hóa các tiêu chí tự kiểm tra, kiểm thử độc lập – đừng để “mất bò mới lo làm chuồng”.

- Chủ động xây dựng, thử nghiệm, cập nhật framework dựa trên benchmark quốc tế.

- Định kỳ công khai và phản hồi minh bạch tới stakeholder, truyền thông – vì niềm tin là thứ khó xây, dễ mất.

Khuyến Nghị Thực Tiễn Cho Doanh Nghiệp Việt

1. Tự Đánh Giá Theo Chuẩn Ngành

Bạn đang phát triển dự án AI? Hãy áp dụng bảng tiêu chí trên để rà soát từng giai đoạn: từ thiết kế, phát triển đến vận hành. Đừng quên chủ động so sánh với benchmark của Google, OpenAI và xây dựng quy trình cập nhật, dự phòng sự cố nội bộ.

2. Đầu Tư Vào Chuẩn Hóa An Toàn – Không Chờ Đến Khi “Dính Phốt”

Bài học từ Grok rất rõ ràng: Đừng đợi đến khi “dính phốt” mới lo xử lý. Hãy chủ động:

- Công bố tình trạng rủi ro.

- Chạy kiểm thử bên ngoài/giám sát độc lập.

- Minh bạch tiến độ cải tiến tới khách hàng/đối tác.

- Soạn sẵn kịch bản truyền thông, tránh rơi vào khủng hoảng như xAI.

3. Theo Dõi Sự Cố Ngành Để Học Hỏi

Bạn có biết, việc liên tục cập nhật các case study AI nổi bật trong nước và quốc tế là chìa khoá giúp doanh nghiệp duy trì “hệ miễn dịch rủi ro” trước thời đại AI khó lường? Đừng bỏ qua những bài học từ người đi trước!

Xem thêm: Harvey AI: Legal AI và mô hình an toàn ngành luật quốc tế

Kết Luận & Đề Xuất Hành Động

- Đừng ỷ lại vào tên tuổi vendor, hãy chủ động xây dựng framework kiểm thử, cảnh báo sớm và lịch trình công khai báo cáo.

- So sánh liên tục với tiêu chuẩn quốc tế, không ngừng cập nhật/cải tiến – đó là ‘vaccine’ tốt nhất bảo vệ doanh nghiệp AI khỏi các khủng hoảng niềm tin, pháp lý hay thất thoát tài chính.

Tóm lại:

Khung an toàn AI không nên chỉ là “cái mác lùa gà” trước hội nghị, mà phải trở thành quy trình sống – chủ động, cập nhật, minh bạch, không né tránh thất bại. Sự kiện Grok, báo cáo của The Midas Project, SaferAI và hiệu ứng truyền thông đã đủ để AI Việt Nam nghiêm túc rà soát và nâng cấp toàn diện mô hình quản trị an toàn AI nội bộ.

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa?

Đây là cộng đồng dành riêng cho những người yêu thích AI, Automation, Workflow Automation, MMO và Affiliate Marketing. Tại đây, bạn sẽ được cập nhật những kiến thức mới nhất, cùng nhau thảo luận, học hỏi và phát triển kỹ năng trong lĩnh vực tự động hóa quy trình làm việc với các công cụ mạnh mẽ. Tham gia ngay: AI AUTOMATION CLUB