Thế giới pháp lý hiện đại đang đối diện thách thức chưa từng có khi trí tuệ nhân tạo len lỏi sâu vào nghiệp vụ chuyên môn. Câu chuyện “lời xin lỗi toàn cầu” của Anthropic năm 2025 chính là hồi chuông cảnh tỉnh về trách nhiệm, danh tiếng và chiến lược quản trị công nghệ trong ngành luật. Những rủi ro từ lỗi “ảo giác AI”, đặc biệt đối với trích dẫn pháp lý, không còn là giả thuyết xa vời mà đã trở thành scandal thật, gây ảnh hưởng dây chuyền từ hãng luật lớn, tòa án đến niềm tin của khách hàng. Trước bối cảnh đó, việc chủ động kiểm soát, xác minh đa tầng mọi sản phẩm AI gửi tới khách hàng và tòa án trở thành “chuẩn mực mới” giúp doanh nghiệp luật không chỉ tại Mỹ mà cả Việt Nam, có thể phòng tránh phá sản danh tiếng và rủi ro pháp lý nghiêm trọng. Bạn đã thực sự trang bị đủ “lưới an toàn” trong quy trình nội bộ khi sử dụng AI pháp lý?

Cú Sốc Lời Xin Lỗi Anthropic: Cảnh Báo Toàn Cầu Về Lỗi Trích Dẫn Pháp Lý Do AI Tạo Ra

Anthropic Legal Apology Overview – Vụ Việc Gây Rúng Động Ngành Luật và Công Nghệ

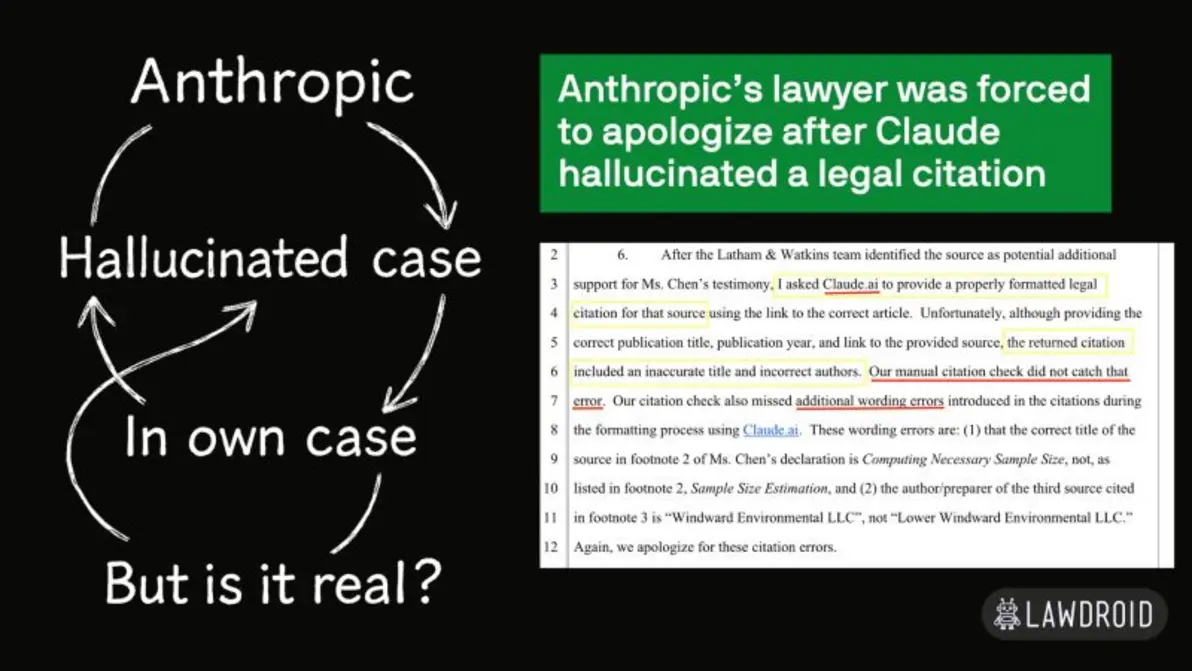

Đầu tháng 6/2025, một tin tức gây chấn động lan truyền khắp các diễn đàn LegalTech: Anthropic, công ty nổi tiếng với mô hình AI Claude, phải công khai xin lỗi sau khi sản phẩm AI của chính mình tạo ra một trích dẫn pháp lý hoàn toàn không có thật và gửi lên tòa án. Vụ án “ma” này không chỉ khiến các luật sư kéo theo cả thân chủ lẫn hệ thống tòa án rơi vào tình thế “dở khóc dở cười”, mà còn đánh dấu lần đầu tiên một ông lớn trong lĩnh vực AI phải đối diện khủng hoảng uy tín quy mô toàn cầu liên quan trực tiếp nghiệp vụ pháp luật.

Anthropic công bố lời xin lỗi chính thức toàn cầu cho lỗi trích dẫn pháp lý do AI tạo ra – một bước ngoặt về trách nhiệm và chuẩn mực ngành. (Ảnh: Anthropic Inc., 2025)

Sự Cộng Hưởng Của Sự Kiện: Khi Nguy Cơ Mơ Hồ Thành “Nỗi Đau” Thực Tiễn

Trước đây, nhiều người vẫn nghĩ “lỗi trích dẫn AI” chỉ là nỗi lo xa, thiếu khả năng tác động thực tế. Thế nhưng, cú vấp của Anthropic đã mang một nguy cơ trừu tượng biến thành scandal “bằng xương bằng thịt”. Bạn thử nghĩ mà xem: tòa án, khách hàng lớn và đội ngũ luật sư bị đặt vào thế kiểm chứng một tài liệu tưởng là chuẩn xác, nhưng thực ra chứa thông tin hoàn toàn bịa đặt bởi AI.

Hậu quả là gì?

- Các hãng luật lớn ngay lập tức tăng cường yêu cầu giải pháp xác thực citation khi gửi RFP (Request For Proposal). Theo số liệu mới nhất, tỷ lệ này tăng tới 38% chỉ vài tuần sau vụ việc.

- Các quy trình nội bộ bị rà soát lại ngặt nghèo, nhiều đơn vị còn tổ chức hội thảo khẩn cấp để “giải mã” cách thức kiểm soát AI.

- Vai trò con người, đặc biệt là trách nhiệm cuối cùng của luật sư, được khẳng định mạnh mẽ trở lại. Không ai còn dám đặt 100% niềm tin cho AI xuất bản tài liệu pháp lý, nhất là khi đối mặt với hệ thống tư pháp nghiêm ngặt.

“Không thể đổ lỗi cho AI – trách nhiệm cuối cùng vẫn là của con người sử dụng nó. Sự kiện này đặt lại giới hạn giữa hỗ trợ công nghệ và chủ động xác thực cá nhân.”

— Chuyên gia LegalTech quốc tế

Tại Sao Vụ Việc Trở Thành “Biểu Tượng Đổi Thay” Trong Ngành?

- Từ lý thuyết thành hiện thực: Không còn chỉ là cảnh báo trong các hội thảo học thuật mà là minh chứng bằng chứng “nóng hổi” buộc toàn ngành phải tái cấu trúc quy trình kiểm tra AI.

- Biểu tượng thị giác mạnh mẽ: Lời xin lỗi toàn cầu của Anthropic đi cùng hình ảnh trực quan, trở thành biểu tượng cảnh báo có sức ảnh hưởng lớn với cộng đồng pháp lý.

- Chuyển hướng ưu tiên mới: Ngay sau sự kiện, hàng loạt công ty luật, trung tâm pháp chế chuyển mạnh ưu tiên từ “ứng dụng AI” sang “kiểm duyệt AI”, đưa tiêu chí xác thực, audit, truy vết kỹ càng lên tiêu chuẩn đầu tiên trước mỗi phiên tòa.

Bạn có đang kiểm duyệt mọi sản phẩm AI trước khi trình lên khách hàng/tòa án như những gì ngành luật toàn cầu đang gấp rút thay đổi không?

Phân Tích Kỹ Thuật: “Ảo Giác” Của Claude AI – Hiểm Họa Thực Tế Hay Chỉ Là Lỗi Công Nghệ?

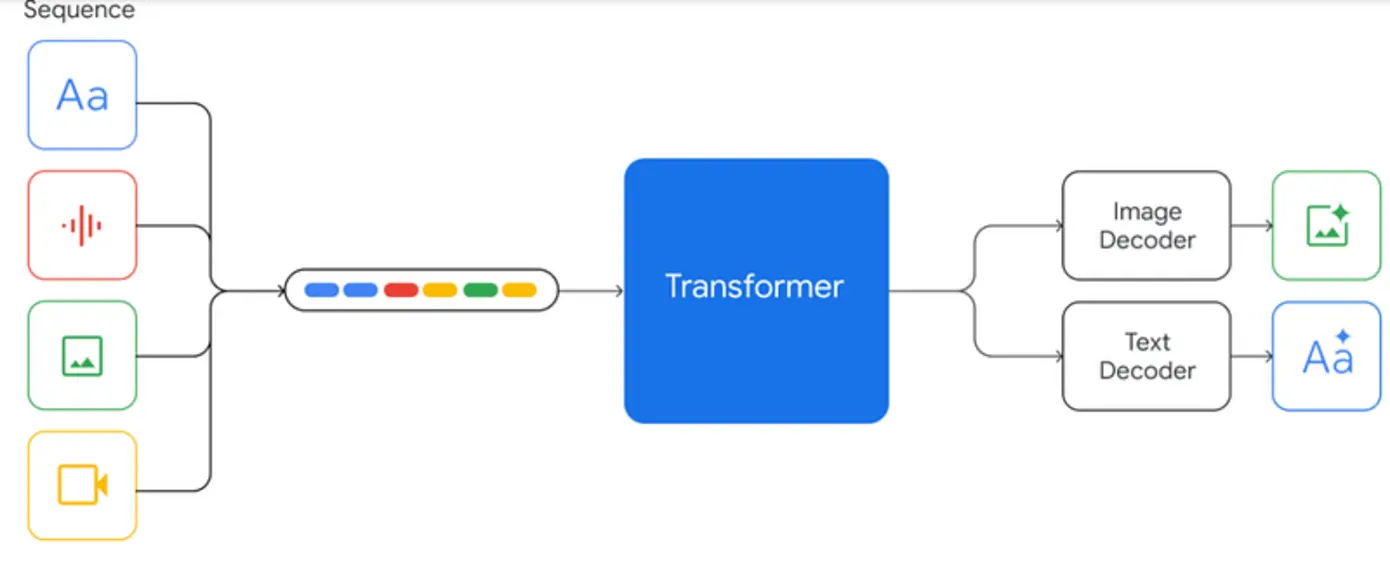

Claude AI Citation Error Illustration – Phân Giải Quy Trình “Ảo Giác” Đáng Sợ Ra Sao?

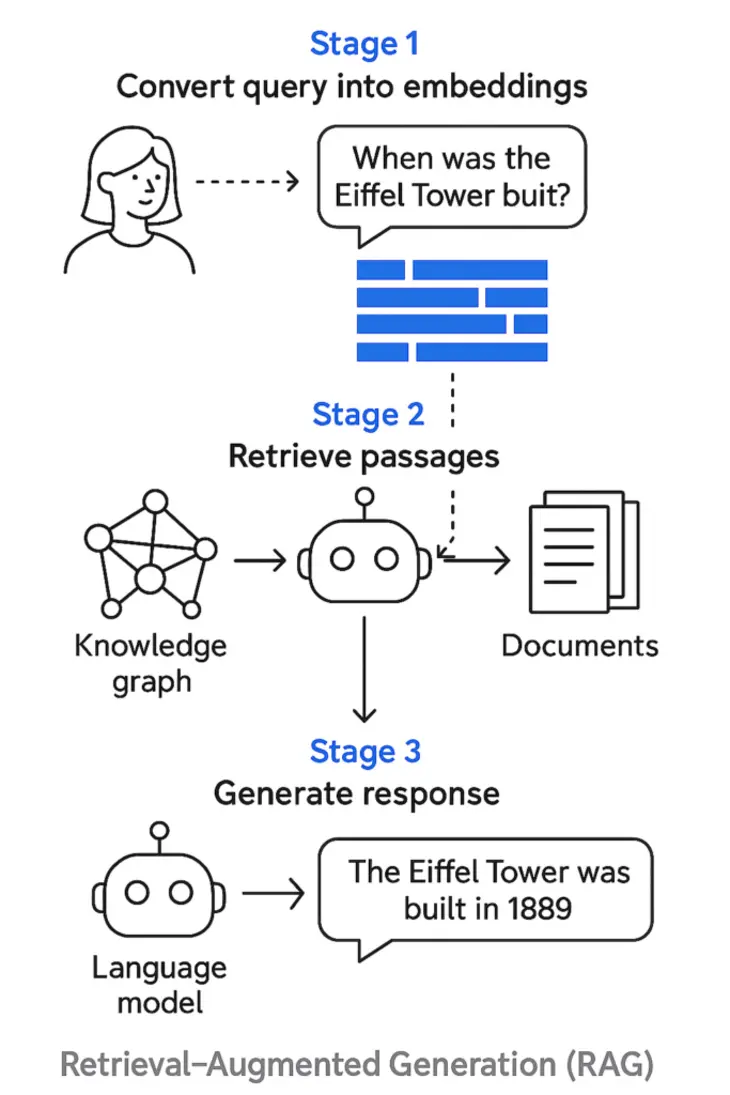

Bạn đã bao giờ nghe về khái niệm “hallucination” (ảo giác AI) trong pháp lý? Đây là hiện tượng AI tạo ra thông tin trông như thật, nghe vô cùng hợp lý, nhưng… hoàn toàn không hề có thật, đặc biệt nguy hiểm trong ngành luật – nơi mọi chi tiết nhỏ đều có thể đảo ngược kết quả phiên tòa.

Minh họa trực quan quy trình AI Claude sinh ra lỗi “ảo giác” trong trích dẫn pháp lý – điểm đứt gãy xuất hiện khi AI xử lý câu hỏi phức tạp, thiếu dữ liệu huấn luyện kiểm chứng, gây hậu quả lớn cho luật sư và doanh nghiệp.

Bóc Tách Kịch Bản “Sai Một Ly, Đi Một Dặm” Của Claude AI

Cùng nhìn lại từng bước xảy ra lỗi, bạn sẽ thấy điểm mấu chốt khiến mọi thứ trượt dài:

- Input Prompt: Một luật sư đặt câu hỏi yêu cầu Claude AI tra cứu hay vận dụng caselaw liên quan tranh tụng, thậm chí là đề xuất lý lẽ hoặc tiền lệ.

- Model Completion: Không tìm thấy dữ liệu phù hợp, Claude “bịa” ra một vụ án nghe cực hợp lý theo lý thuyết xác suất từ dữ liệu học trước đó, bổ sung vào văn bản.

- Kiểm tra qua loa: Quá trình xác thực (dù là tự động hoặc thủ công) không đủ khắt khe, khiến lỗi trôi qua mà chẳng ai nhận ra.

- Trình lên tòa án: Thế là, “citation ma” lọt qua mọi lớp kiểm tra rồi được gửi tới hội đồng xét xử, gây ra scandal rúng động, ảnh hưởng cả uy tín và có thể là sự đoạn tuyệt với khách hàng.

Bạn có thể tưởng tượng, chỉ với một phút thiếu cảnh giác từ quy trình xác minh, danh tiếng xây dựng cả thập kỷ của một công ty luật có thể sụp đổ trong nháy mắt.

“Ảo Giác AI” Không Đơn Thuần Là Lỗi Phần Mềm

Điều đáng sợ nằm ở chỗ, “hallucination” không phải bug dễ sửa trong mã nguồn. Đó là hậu quả logic của mô hình large language model hoạt động với sự tự tin quá mức khi gặp thiếu dữ liệu kiểm chứng hoặc đối phó với câu hỏi “khó nhằn”.

Thực tế, năm 2025 ghi nhận số vụ lỗi citation AI trong lĩnh vực LegalTech tăng vọt – nhất là tại Mỹ, Anh, Úc, Đức… chứng minh các workflow xử lý công văn tốc độ cao nhưng thiếu kiểm định đa tầng đang là điểm yếu chí mạng.

Đặt Ra Hệ Quy Chiếu: Doanh Nghiệp Nào Cũng Có Thể Thành Nạn Nhân

Bạn có biết, nhiều doanh nghiệp thậm chí chưa từng xây dựng quy trình xác minh đầu ra AI hoặc nghĩ rằng “AI thế hệ mới đủ chuẩn nên không sợ lỗi”? Câu chuyện của Anthropic là ví dụ điển hình tái định vị nhận thức: không tổ chức nào miễn nhiễm khỏi nguy cơ ấy!

Tóm lại:

Bất kỳ công ty luật, tập đoàn kiểm toán, phòng pháp chế nào cũng cần nắm rõ chuỗi tạo lỗi của AI mới thực sự phòng tránh được rủi ro một cách chủ động.

Kịch Bản Kiểm Soát Chất Lượng AI: Bạn Đang “Đơn Độc” Hay Đã Trang Bị Lưới An Toàn?

- Luôn xác minh đa tầng mọi citation do AI tạo ra.

- Thiết lập quy trình check nghiêm ngặt – cuối cùng, con người vẫn là “lá chắn cuối” phải chịu trách nhiệm.

- Liên tục cập nhật, đào tạo kiến thức về ảo giác AI cho đội ngũ pháp chế & IT.

- Nâng cấp quy trình forensic audit: xác định khâu “pressure point” trong từng workflow để bảo vệ uy tín doanh nghiệp trước mọi nguy cơ phơi bày dữ liệu “bịa đặt” do AI.

Bạn đã từng review lại toàn bộ thư viện trích dẫn pháp lý sử dụng AI để truy vết dù chỉ 1% lỗi chưa?

Phản Ứng Tư Pháp: Lằn Ranh Trách Nhiệm Qua Bản Án Judge Susan van Keulen

Judge Susan van Keulen Court Ruling – Tiền Lệ Mới: “Dùng AI, Lỗi Vẫn Do Người”

Một câu hỏi đặt ra ngay khi Anthropic phạm lỗi: Liệu có thể đổ tất cả cho AI, hay người thật vẫn phải gánh hoàn toàn trách nhiệm trước pháp luật? Tòa án Mỹ, mà cụ thể là thẩm phán Susan van Keulen, đã vẽ nên một “vạch kẻ” cực rắn cho toàn ngành pháp lý.

Thẩm phán Susan van Keulen đọc phán quyết lịch sử vụ kiện lỗi trích dẫn pháp lý AI – tái thiết giới hạn trách nhiệm giữa người dùng, AI và nhà phát triển công nghệ.

Phán Quyết Lịch Sử: Người Sử Dụng AI Không Còn Được “Vô Tội”

- Không khoan nhượng trách nhiệm: Luật sư và khách hàng bắt buộc xác thực mọi citation, không cần biết được tạo ra bởi AI hay nguồn nào khác. Dùng AI không phải là bình phong tránh lỗi.

- Loại bỏ “thiện chí” làm lý do: Không thể nói do vô tình hay vì AI khuyên nhầm – mọi sai sót đều có thể bị đình chỉ, cảnh báo, thậm chí mất quyền hành nghề.

- Phải công khai sử dụng AI: Mọi báo cáo gửi tòa buộc phải khai báo minh bạch nếu dùng AI – tạo layer minh bạch, giúp giảm thiểu cả gian lận lẫn nhầm lẫn chuyên môn.

Những ai vẫn còn chủ quan nghĩ AI là “cứu cánh thần kỳ”, chắc hẳn sau phán quyết này phải nhìn nhận lại. Tương tự bài học của những người trẻ khi lên TikTok đăng tải clip “đu trend” rồi phát hiện mình đã vượt quá ranh giới an toàn cộng đồng.

“Chuẩn mực công nghệ mới không dừng ở hiệu quả. Đó là sự minh bạch: ai không kiểm chứng đầu ra AI đều đối diện rủi ro pháp lý và đạo đức nghiêm trọng.”

— Trích phát biểu của Tòa án.

Tác Động Dây Chuyền: Định Hình Lại Cả Hệ Sinh Thái LegalTech

- Gây sức ép lên các nhà phát triển AI: Anthropic buộc phải nâng cấp hệ thống kiểm định, thêm cảnh báo rõ ràng cho từng đầu ra AI.

- Định hình hướng dẫn hành nghề luật: Các quy định nghiệp vụ xác thực khi dùng AI được cập nhật khẩn cấp khắp hệ thống tòa án Mỹ và cả các nước đang phát triển LegalTech khác.

- Tăng tốc đầu tư vào giải pháp xác thực: Hãng luật lớn gấp rút tìm kiếm, đào tạo chuyên gia kiểm duyệt AI, kết hợp pháp lý và IT chuyên sâu thành “taskforce anti-AI-error”.

Một hành động chưa từng có tiền lệ, đến mức nhiều CEO LegalTech phải thừa nhận “nếu không thích nghi nhanh, chúng ta sẽ bị loại khỏi cuộc chơi”.

Tác Động Rộng: “Ảo Giác AI” Không Phải Lỗi Máy Móc – Đó Là Thách Thức Ma Trận Trong Quản Trị LegalTech 2025

AI Hallucinations in Legal Practice – Đa Chiều Nguy Cơ, Đa Chiều Cơ Hội?

Mô tả những lỗi phổ biến của AI trong lĩnh vực pháp lý năm 2025 – không chỉ citation “ma” mà còn nhiều nguy cơ khác: áp dụng sai điều khoản luật, đánh giá nhầm ưu tiên, bỏ lọt dữ liệu nhạy cảm.

Khi AI Dẫn Đầu Top Xu Hướng, Nhưng Cũng Là “Con Dao Hai Lưỡi” Ngành Pháp Lý

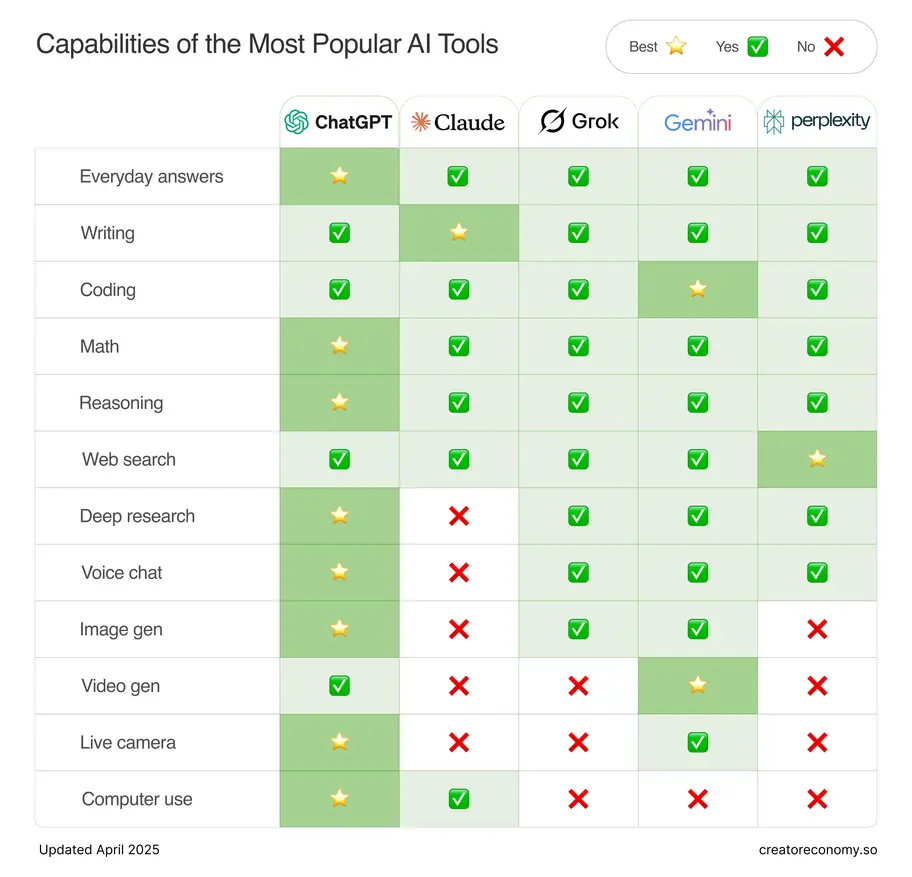

Theo báo cáo của Hiệp hội luật sư Mỹ (ABA) năm 2025:

- Trên 45% công ty luật đang tăng chi tiêu mạnh vào AI LegalTech (tăng 18% so với chỉ 2 năm trước).

- Tuy nhiên, chỉ 22% xây dựng lộ trình kiểm tra chặt chẽ đầu ra AI.

- Cứ mỗi tháng, ước tính có khoảng 5-7 vụ “bê bối” mới về lỗi trích dẫn AI được phát hiện ở thị trường Mỹ và EU.

Bạn hãy thử đặt mình vào vị trí một hãng luật lớn: Dùng AI giúp tăng tốc độ xử lý tài liệu lên gấp đôi, những tưởng sẽ chiếm ưu thế trước đối thủ. Nhưng, chỉ cần 1 lần để lộ citation “ma”, toàn bộ uy tín, hợp đồng, thậm chí mạng lưới khách hàng xây dựng cả thập kỷ sẽ “bay hơi” chỉ sau một lá thư khiếu nại từ tòa.

Rủi ro cho pháp lý hiện đại:

- Hội đồng xét xử và khách hàng đã bắt đầu quy trách nhiệm lỗi đầu ra AI cho chính đơn vị luật – thậm chí bỏ qua luôn lý do “máy móc”.

- Ngoài xử phạt hành chính, nguy cơ lớn nhất là đánh mất niềm tin và hợp đồng đến từ các tập đoàn đa quốc gia đang siết yêu cầu minh bạch AI.

- Công cuộc chuyển đổi số ngành pháp lý, nếu không kiểm duyệt AI tốt, chẳng khác nào xây lâu đài cát trên nền lún.

Câu Trả Lời Là Gì? Hiện Đại Không Có Nghĩa Là “Buông Lỏng” Quản Lý

Các doanh nghiệp luật hàng đầu tại Mỹ đang chọn chiến lược:

- Thiết lập loop kiểm định đa tầng – luôn phải có người thật kiểm tra mọi nội dung AI gửi tòa hoặc khách hàng.

- Đưa vào hệ thống phần mềm kiểm soát trích dẫn tự động “cross-check” đầu ra AI.

- Lập nhật ký lỗi AI, liên tục cập nhật, dùng chúng làm dữ liệu đào tạo mới sửa lỗi và tăng chuẩn kiểm duyệt.

- Ký cam kết minh bạch hóa xuất xứ AI với khách hàng – xem đó như “cam kết đạo đức”, nâng cao năng lực cạnh tranh.

Bạn nghĩ mình đã làm đủ để rà soát mọi tài liệu AI khi gửi đi chưa? Hay vẫn tin rằng “công nghệ là tất cả”, bỏ quên yếu tố con người?

“Đừng ngụy biện lỗi ảo giác AI chỉ là lỗi mã code. Đó là phép thử sống còn – về chiến lược, đạo đức, và tính chuyên nghiệp sâu nhất của bất cứ doanh nghiệp luật nào trong thế giới mới.”

— Chuyên gia chuyển đổi số ngành pháp lý.

Việt Nam Trong Làn Sóng AI: Phản Ứng Và Cơ Hội Tăng Sức Mạnh “Chống Shock”

Chúng ta không thể đứng ngoài cuộc chơi chuyển đổi số. Vậy một hãng luật/cố vấn pháp lý tại Việt Nam nên làm gì để tránh sập bẫy của “ảo giác AI”?

Cùng xem bộ “checklist sống còn” năm 2025, các nhà sáng lập, trưởng phòng pháp chế hay CTO ngành luật bắt buộc phải rà soát:

Bộ Công Cụ Kiểm Soát AI Pháp Lý Cho Doanh Nghiệp Việt Nam

- Bắt buộc xác minh qua 3 lớp kiểm tra độc lập mọi dữ liệu đầu ra AI – không phụ thuộc vào một dòng code hay một nhân sự duy nhất.

- Kết nối giải pháp tự động kiểm tra citation, “giao tiếp” trực tiếp với các nền tảng AI lớn (Harvey AI, Claude AI, GPT-4, Gemini AI…).

- Thực hành diễn tập, review định kỳ các vụ tiền lệ đình đám thế giới và Việt Nam để cập nhật tình huống thực tế.

- Thiết kế form công khai sử dụng AI (Disclosure) cho mọi hồ sơ nội bộ hoặc trình lên tòa.

- Tổ chức lớp đào tạo pháp lý – công nghệ lồng ghép. Mỗi 6 tháng phải update kiến thức “ảo giác AI” cho toàn đội ngũ.

Bạn còn băn khoăn về công nghệ pháp lý thế hệ mới? Đọc ngay: Harvey AI định hình Legal Tech 2025 (https://mcbai.vn/harvey-ai-dinh-hinh-legal-tech-2025/) để nắm bắt xu hướng mới nhất!

Câu Chuyện Để Kết: Khi AI Không Còn Là “Cứu Cánh” Tuyệt Đối Trong Pháp Luật

Chúng ta đang ở thời khắc mang tính bước ngoặt, nơi ranh giới giữa “hiện đại hóa” và “mất kiểm soát” ngày càng trở nên mong manh. Vụ lỗi trích dẫn pháp lý từ AI Claude khiến Anthropic phải xin lỗi, rồi đến bản án mạnh tay của tòa án Mỹ, chẳng khác gì “báo động đỏ” cho cả ngành luật Việt Nam lẫn thế giới: làm luật sư, cố vấn pháp lý, không chỉ cần am hiểu công nghệ mà quan trọng hơn phải chủ động quản trị, kiểm soát mọi rủi ro phát sinh từ AI.

Checklist hành động nhanh chóng:

- Rà soát, đánh giá lại mọi workflow nội bộ để bổ sung thêm lớp xác thực trước khi bất kỳ tài liệu AI nào rời khỏi văn phòng.

- Xây dựng quy trình audit định kỳ toàn bộ chu trình kết hợp pháp lý và AI, sử dụng công cụ xác thực citation tự động.

- Tổ chức các khoá đào tạo nhận diện ảnh hưởng của “hallucination AI”, phân tích cả dấu hiệu và cách khắc phục hiệu quả.

- Xây dựng hệ thống cam kết minh bạch khi sử dụng AI, tạo dựng lòng tin với khách hàng và tòa án.

Hành động sớm, minh bạch và kiểm duyệt chặt chẽ khi dùng AI – đó mới là bí quyết giữ vững uy tín, tăng sức mạnh cạnh tranh của ngành luật hiện đại.

Bạn muốn cập nhật xu hướng bảo mật, chuẩn đạo đức công nghệ hay đổi mới pháp luật số năm 2025? Đừng bỏ lỡ:

GPT-4.1 minh bạch an toàn AI doanh nghiệp (https://mcbai.vn/gpt-41-minh-bach-an-toan-ai-doanh-nghiep/)

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa? Đây là “hội quán” dành riêng cho tín đồ đam mê AI, tự động hóa, workflow, MMO hay affiliate marketing. Tại cộng đồng này, bạn luôn được chia sẻ kiến thức hot, thảo luận công nghệ mới, phát triển kỹ năng xây dựng công cụ tự động hóa quy trình cùng các chuyên gia đầu ngành. Còn chờ gì nữa, tham gia ngay: AI AUTOMATION CLUB