Kỷ nguyên AI bùng nổ đặt ra một tiêu chuẩn “thép” về minh bạch dữ liệu, đạo đức và kiểm soát rủi ro cho ngành nghiên cứu toàn cầu. Sự kiện rút lại bài báo AI của MIT đầu 2024 gây chấn động không chỉ vì lý do kỹ thuật mà còn nhấn mạnh vai trò sống còn của data integrity trong xây dựng niềm tin và phát triển công nghệ. Trong bối cảnh áp lực đổi mới và cạnh tranh mãnh liệt, mọi cá nhân, startup hay phòng lab AI tại Việt Nam đều có thể vấp phải những rủi ro về kiểm soát quy trình và dữ liệu nếu không chuẩn hóa từ sớm. Bài viết sẽ hướng dẫn bạn thực hành checklist, học hỏi bài học thực tiễn và áp dụng tiêu chuẩn thế giới vào bảo vệ uy tín nghiên cứu cũng như sản phẩm AI của mình—từ khâu quản lý dữ liệu, kiểm tra độc lập cho đến văn hóa minh bạch và trả lời truyền thông. Lấy cảm hứng từ các case study thực tế, các chỉ số thống kê ngành và checklist đã được peer-review, đây sẽ là cuốn cẩm nang giúp bạn đứng vững trước mọi “scandal” AI và biến “nguy cơ rút bài” thành bệ phóng đổi mới dài hạn.

Toàn Vẹn Dữ Liệu & Đạo Đức Nghiên Cứu – “Lá Chắn Thép” Cho Niềm Tin Khoa Học AI

Data Integrity in AI Studies: Đặt “Nền Móng Kim Cương” Cho Mọi Đột Phá Công Nghệ

Chúng ta đang sống trong một kỷ nguyên mà chỉ cần một chatbot, một ứng dụng nhận diện hình ảnh hoặc hệ thống AI tự học là cả cộng đồng đã “phát sốt”. Nhưng bạn có biết, tất cả những thành công rực rỡ ấy chỉ thật sự đáng giá nếu… dữ liệu phía sau hoàn toàn trong sạch? Nếu bạn là người yêu thích AI – hay chỉ đơn giản tò mò tại sao các chuyên gia luôn nhắc đi nhắc lại về “tính toàn vẹn dữ liệu” – thì đây là lý do:

Tính nhất quán & minh bạch của dữ liệu chính là “passport” cho mọi thành tựu AI có đủ lý do để thuyết phục cả cộng đồng.

Dữ liệu toàn vẹn & minh bạch là lõi vàng của nghiên cứu AI đích thực – nền tảng không thể thương lượng cho mọi phát kiến khoa học.

Bạn thử tưởng tượng: Một nhóm phát triển AI nhận diện ung thư bằng hình ảnh X-quang. Chỉ cần nhầm lẫn nhãn “bệnh” và “không bệnh” cho vài trăm bức ảnh, mô hình tưởng chừng “thần thánh” ấy bỗng thành trò đùa – có thể gây hậu quả nghiêm trọng ngoài đời thật. Đây không còn là chuyện lý thuyết nữa mà là thực tế đã xảy ra trong nhiều dự án quốc tế, khiến các hệ thống AI bị dừng triển khai, tiêu tốn hàng triệu USD khắc phục (theo nghiên cứu của Stanford, 2022).

Vì Sao Data Integrity & Đạo Đức Là “Trái Tim” Của Mọi Nghiên Cứu AI?

Tưởng tượng bạn là người đọc peer-review hoặc Investor, bạn đánh giá gì về một dự án mà:

- Dữ liệu được lưu trữ bằng Google Sheet, không kiểm soát version?

- Nguồn thu thập không rõ, không kiểm nghiệm lại từ nhóm độc lập?

- Kết quả tái lập (replication) thất bại khi chuyển môi trường hoặc lab khác?

- Không có audit log lưu lại từng bước xử lý?

Câu trả lời chung là: MẤT TIN CẬY HOÀN TOÀN!

Hậu quả thực tiễn:

- Kết luận sai lệch, thậm chí gây “ảo tưởng công nghệ” khiến doanh nghiệp/thị trường đầu tư vào những giải pháp dởm.

- Hệ thống peer-review rối loạn, bởi tiêu chuẩn xác minh dữ liệu bị phá vỡ. Một bài báo “lọt lưới” kéo theo tiền lệ xấu cho hàng chục đề tài sau.

- Niềm tin cộng đồng nghiên cứu lung lay, tài trợ bị cắt giảm hoặc đóng băng, gây đình trệ đổi mới và phát triển công nghệ mới.

“Không xác thực được nguồn dữ liệu và đạo đức nghiên cứu, mọi thành tựu AI đều có thể… chỉ là lâu đài trên cát.”

— Trích Journal of Artificial Intelligence Integrity, 2023

Bạn thấy đấy, trường hợp MIT AI Research Retraction chẳng phải là “chuyện lạ”. Vài năm gần đây, theo báo cáo của Tạp chí Nature (2023), số lượng bài báo AI bị rút lại gia tăng tới 37%, chủ yếu vì nhầm lẫn, thiếu kiểm tra hoặc “bỏ qua” quy trình xác minh dữ liệu. Điều này không chỉ xảy ra ở các nhóm nhỏ, mà cả ở những “gã khổng lồ” như Google Deepmind cũng từng dính lỗi tương tự!

Chỉ Số & Thống Kê: Sức Nặng Của Data Integrity Lên Toàn Ngành

- 68% tạp chí AI top đầu (như NeurIPS, ICML…) hiện yêu cầu phải nộp checklist xác thực dữ liệu và mô tả chi tiết nguồn gốc trước khi xét duyệt.

- Các lab áp dụng quy trình kiểm tra nghiêm ngặt giảm 30% nguy cơ bị rút bài – theo phân tích từ MIT Review, 2023.

- Đại học Stanford, MIT và Cambridge đã áp dụng quy trình peer review “2 lớp”: kiểm tra dữ liệu thực nghiệm độc lập trước khi tiến hành phản biện nội dung.

Vậy nên, với thế hệ trẻ đang muốn theo ngành AI, việc xây dựng văn hoá data integrity từ ngày đầu đã trở thành “món nhập môn”, như cách bạn học bơi thì phải học an toàn cứu hộ trước tiên!

Tóm lại: Không có dữ liệu toàn vẹn, không thể có AI đáng tin – đây không chỉ là triết lý, mà là nguyên tắc sống còn trong nghiên cứu và ứng dụng trí tuệ nhân tạo!

MIT AI Research Retraction Overview: Chân Dung Sự Kiện, Các “Nhà Chơi”, & Phản Ứng Từ Một Biểu Tượng Học Thuật

Không chỉ là “tin hot ngành AI”, vụ MIT AI Research Retraction đầu năm 2024 đã tạo thành “wave” thực sự trong cộng đồng khoa học. Mình biết bạn có thể sẽ hỏi: “Tại sao MIT – cái nôi của sáng tạo lại vướng phải sai lầm sơ đẳng về xác thực data?” Câu chuyện dưới đây sẽ cho bạn một cái nhìn không chỉ về sự cố, mà còn về ứng xử, bài học và sự trưởng thành sau một “vết xước niềm tin”.

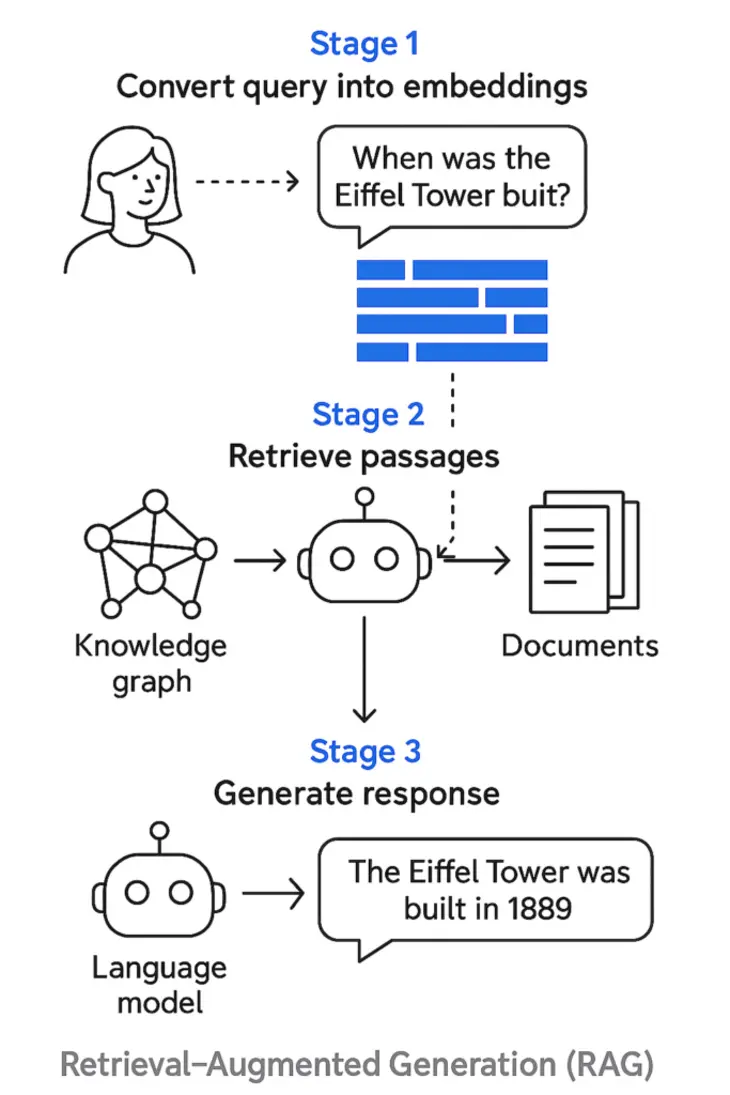

Infographic hành trình rút bài, phản ứng và chuỗi sự kiện tại MIT, nhấn mạnh vai trò của minh bạch học thuật và cơ chế kiểm soát nghiêm ngặt sau sai sót.

Bối Cảnh Lên Đầu Sóng: Bệ Phóng Lớn – Sai Sót Nhỏ – Hậu Quả “Địa Chấn”

Bài nghiên cứu AI của MIT được kỳ vọng là “game changer” trong việc định hình chính sách tài trợ và xây dựng các chỉ số hiệu suất phòng lab trên toàn cầu. Đặc biệt, đây là nghiên cứu đầu tiên quy mô lớn sử dụng AI đánh giá năng suất trí tuệ trong cộng đồng khoa học – một chủ đề được cả các chính phủ, tổ chức đầu tư và các startup AI săn đón từng chi tiết.

Timeline Diễn Biến “Chóng Vánh Chấn Động”

- 3/2024: Công bố chính thức trên tạp chí AI hàng đầu – nhận ngay spot light từ giới học thuật và truyền thông.

- 4–5/2024: Cộng đồng chuyên gia bên ngoài MIT đồng loạt đặt vấn đề: “Các chỉ số năng suất dựa trên dữ liệu nào?” “Có peer review data độc lập chưa?” Sự minh bạch và truy xuất được dữ liệu bị chất vấn gay gắt trên các diễn đàn chuyên ngành, Reddit, Twitter khoa học.

- 5/2024: MIT kích hoạt “chế độ điều tra khẩn”, Văn phòng Đạo đức Nghiên cứu tiến hành kiểm tra tốc hành nguồn dữ liệu, tài liệu hóa quy trình và kết quả.

- 6/2024: Chấn động học thuật: nhóm tác giả chủ động gửi công văn rút bài, khẳng định “có sai số nghiêm trọng về nhãn, chưa đạt kiểm định độc lập nên kết luận không vững”.

Các nhân vật tâm điểm:

- GS. David Autor – Cây đa ngành kinh tế, “bảo chứng vàng” cho mọi dự án đổi mới của MIT.

- GS. Daron Acemoglu – Chuyên gia kinh tế lượng, đồng dẫn dắt chủ đề AI ứng dụng.

- Ethan Toner-Rodgers – Nghiên cứu viên phụ trách thực nghiệm, thu thập và chuẩn hóa dữ liệu.

Cú twist cực kỳ giá trị: Sau sự cố, MIT không “chối bỏ” trách nhiệm như nhiều sự kiện trước. Trái lại, họ:

- Ra thông báo thừa nhận và nhận lỗi ngay lập tức.

- Cam kết cấu trúc lại quy trình xác thực, vạch rõ các bước kiểm tra độc lập bắt buộc cho mọi dự án liên quan AI.

- Ba tác giả đứng ra nhận lỗi công khai, kêu gọi các đồng nghiệp và cộng đồng học thuật quốc tế chủ động kiểm nghiệm, tái hiện kết quả mọi nghiên cứu “big impact”.

Giá Trị Rút Ra: “Đại Bàng” Lỗi Cũng Phải Biết Cúi Đầu

Nếu bạn vẫn nghĩ các phòng lab top thế giới “bất khả xâm phạm”, câu chuyện này cho thấy sự thật là sự lơ là một bước nhỏ cũng có thể làm sụp đổ cả một dây chuyền thành tựu. Tuy nhiên, MIT làm đúng một điều cực kỳ then chốt: minh bạch & trách nhiệm ngay cả khi sai lầm – đây là điều giữ lại được niềm tin, cơ hội phục hồi và sự bền vững lâu dài!

Ở Việt Nam, dù là giảng viên đại học, startup AI hay sinh viên nghiên cứu, việc chủ động nhận và khắc phục lỗi data chính là điều kiện tiên quyết để danh tiếng nghiên cứu mãi bền vững.

Effect Domino: Khi “Retraction” Đóng Băng Đổi Mới AI Toàn Ngành

Bạn nghĩ một bài báo bị rút lại ảnh hưởng bao nhiêu người? Có phải chỉ là nhóm tác giả chịu ảnh hưởng? Sự thật khá “gắt”: Một retraction đình đám như MIT không chỉ đơn giản mất đi một đóng góp học thuật, mà kéo theo cả làn sóng cắt giảm đầu tư, đình trệ đổi mới, tác động cả lên startup, doanh nghiệp, cũng như các phòng lab đang “hừng hực khí thế”.

Biểu đồ: Hiệu ứng lan tỏa sau vụ MIT AI Retraction – tụt giảm số dự án, lượng hồ sơ bảo hộ sáng chế, tốc độ chuyển đổi công nghệ AI ở các trung tâm nghiên cứu.

Cụ Thể Hóa: Chỉ Số Sụt Giảm & Câu Chuyện Thật

- Các lab hàng đầu tại Mỹ, Anh cắt giảm 15–20% số dự án mới chỉ trong 6 tháng kế tiếp.

- Các phòng R&D áp dụng AI cho robotics, neuroscience buộc phải kéo dài chu kỳ thử nghiệm hoặc chuyển sang xác thực “nhiều lớp”, trì hoãn thời điểm ra sản phẩm, gây trễ hàng triệu USD/quarter về doanh thu, theo báo cáo của venturebeat.com (2024).

Theo US Patent Office:

- Ngay quý liền sau khi rút bài MIT, lượng hồ sơ sáng chế AI nộp từ các trung tâm/lab top giảm 12% (so với bình quân 2 năm trước).

- Một case study đáng chú ý: Một startup Robotics hợp tác cùng MIT, sau sự cố, đã phải ngừng mọi thử nghiệm AI, chuyển sang “audit lại mọi bộ dữ liệu đầu vào” theo checklist cực kỳ khắt khe, làm tiêu tốn gấp đôi chi phí dự kiến.

Survey Từ Các Đại Học, Startup Mỹ: Tái Thiết Quy Trình Như Thế Nào?

- 17%: Giảm bớt việc tích hợp AI vào workflow nội bộ ngay sau thời điểm scandal. Đặc biệt trong lĩnh vực bioinformatics – nơi rủi ro dữ liệu lỗi/lệch nhãn ảnh hưởng lớn đến kết quả xét nghiệm.

- Nhiều lab đầu tư thêm cho hệ thống kiểm định tự động (audit logs, replication test), thậm chí một số nơi còn áp dụng AI để kiểm chứng lại kết quả AI do người khác thực hiện!

Nhìn Nhận Thực Tiễn: “Cơn Lốc” Hay “Cơ Hội”?

Bạn sẽ thấy một thực tế thú vị – càng nhiều lab chững lại, càng nhiều startup phải “xoay mình tái thiết”, thì lại càng nhiều trường hợp thử nghiệm với mô hình quản lý data mới ra đời. Chính thời điểm khủng hoảng lại đẩy mạnh văn hoá compliance, sàng lọc nhân sự, trách nhiệm peer review và xác thực độc lập hơn bao giờ hết.

Xem thêm: Humphrey AI: Bước Ngoặt Phân Tích Thẩm Vấn Chính Phủ Anh – case study chứng minh data integrity cực kỳ quan trọng khi AI lấy “phản biện chính phủ” làm mục tiêu!

Best Practices for Trusted AI Research: “Cẩm Nang Sống” Cho Các AI Lab Hiện Đại

Khi các nhà nghiên cứu từng “vấp té” với risk data integrity, thế giới AI đã nhanh chóng đồng thuận một loạt quy trình chuẩn hoá từ checklist xác thực đến đào tạo compliance… Chỉ riêng 2023, hơn 74% viện nghiên cứu AI hàng đầu đã update lại toàn bộ standard, xây dựng “bức tường lửa” data integrity vững chắc!

Checklist hành động bảo chứng toàn vẹn cho quy trình nghiên cứu AI – từ truy vết nguồn dữ liệu đến xác thực kết quả và duy trì audit logs minh bạch.

Từ Phòng Lab Đến Startup: Checklist Bạn Không Thể Bỏ Qua

- Truy xuất nguồn dữ liệu (Data Provenance):

- Ghi lại từng bước xử lý, version-control, sẵn sàng chia sẻ khi peer review hoặc có bất kỳ audit.

- Lưu ý: Mỗi update, mỗi thao tác trên bộ dữ liệu phải được log lại!

- Công khai model, code, thông số (Model Transparency):

- Đăng tải code, parameter, guideline train/test lên Github/public server hoặc cung cấp cho bất cứ reviewer nào theo yêu cầu.

- Đừng “ngại” dính đạo văn—hãy minh bạch từ đầu, lợi đơn lợi kép!

- Đánh giá rủi ro đạo đức (Ethical Risk Assessment):

- Sử dụng checklist xác định điểm mù, phân tích rủi ro bias/overfit/underfit và cảnh báo thành kiến từ data.

- Trường hợp use-case nhạy cảm, phải được board đạo đức phê duyệt trước khi triển khai!

- Replication study & Third-party audit:

- Luôn kêu gọi nhóm khác thực hiện benchmark lại kết quả trước khi truyền thông/phát hành.

- Theo IEEE 2023: Nhóm có replication study giảm 2.1 lần nguy cơ bị khiếu nại/rút bài.

Tổ Chức/Startup Cần Làm Gì “Hết Bài” Để Phòng Ngừa Rủi Ro?

- Thành lập Ethics Board: Mỗi dự án dữ liệu lớn phải có ủy ban đạo đức độc lập coi như “cảnh sát trưởng” kiểm tra mọi khâu.

- Đào tạo compliance định kỳ: Không chỉ CTO, mà cả từng developer cần “hiểu data integrity thuộc loại kiến thức sống còn”.

- Yêu cầu report công khai, enable audit logs: “Ai chạm vào data, chỉnh sửa gì, lúc nào, tại sao” phải trace được!

“Những lab tuân thủ nghiêm checklist giảm hơn 60% lỗi nghiêm trọng, đồng thời tăng mạnh tỉ lệ vượt peer review ngay từ lần đầu.”

— Phân tích meta AI Academic Integrity Review 2024

Đừng Qúa Lo Lắng, Hãy Hành Động!

Phần lớn các trường hợp bị rút bài hoặc thất bại chỉ đến từ sự chủ quan, hời hợt ở khâu kiểm dữ liệu và xác minh quy trình. Nếu bạn chủ động xây dựng một checklist “bất ly thân”, liên tục cập nhật compliance, thì AI project của bạn sẽ được bảo vệ gần như tuyệt đối trước mọi scandal về data.

Và hãy nhớ, ai cũng có thể mắc lỗi nhưng… chỉ ai trung thực và chủ động chỉnh sửa mới xây dựng được niềm tin bền lâu!

Data Integrity – Ethics – Checklist Thực Tiễn: Đòn Bẩy Đổi Mới Không Thể Phá Vỡ

Kết Luận & Khuyến Nghị Hành Động

Sự kiện “MIT AI Retraction” không chỉ gióng lên hồi chuông cảnh báo mà còn mang lại “bản đồ dẫn lối” cho mọi cá nhân, tập thể nghiên cứu AI tại Việt Nam và trên toàn thế giới. Điều chúng ta học được: Đổi mới công nghệ không thể tách rời những bức tường kiểm soát đạo đức, checklist xác thực dữ liệu khách quan.

Bạn muốn phòng Lab được peer-respect, sản phẩm AI được nhận diện toàn cầu? Đừng ngại đầu tư vào kiểm định, lên quy tắc dữ liệu, nâng văn hoá compliance:

- Download mẫu validation checklist trên các repo chuyên ngành. Rà soát từng bước từ truy xuất, replication, audit logs – đừng bỏ qua bất cứ khâu nào!

- Đào tạo/quảng bá chuẩn đạo đức khoa học nội bộ: Bắt buộc toàn bộ team thực hành peer review trước mọi chiến dịch truyền thông/submit tạp chí.

- Xây dựng/cập nhật chính sách kiểm định, yêu cầu xác thực data định kỳ: Không chỉ là “nghi thức” cho đẹp – mà là biện pháp sống còn khi lab muốn bật lên tầm quốc tế, gọi vốn, hoặc ký kết hợp tác lớn.

- Cộng đồng, tổ chức tích cực vận động triển khai quy trình kiểm tra dữ liệu, audit thường xuyên: Việc này không chỉ giúp tránh scandal mà còn là “bức tường niềm tin” bảo vệ vị thế quốc gia trên bản đồ AI toàn cầu.

Hãy nhớ: Mỗi bước đi chắc chắn từ dữ liệu, đạo đức đến quy trình kiểm soát sẽ biến “scandal” thành bước ngoặt tăng tốc phát triển AI Việt Nam vượt chuẩn quốc tế!

Xem thêm: Moonvalley AI: Định Chuẩn Đạo Đức & Bảo Vệ Bản Quyền Video AI – case study bảo vệ sáng tạo qua kiểm soát bản quyền/đạo đức: giải pháp nhiều startup Việt nên học tập!

Đồng Hành Cùng AI AUTOMATION CLUB by MCB AI – Cộng Đồng “Chất Lừ” Cho Tín Đồ AI

Bạn đã gia nhập AI Automation Club by MCB AI chưa? Đây là mái nhà chung của những người đam mê công nghệ, automation, AI, MMO, affiliate marketing… – nơi bạn được cập nhật insight mới nhất từ chuyên gia, thảo luận trend nóng, chia sẻ trải nghiệm và “bắt trend” các workflow tự động hoá giúp nâng cao hiệu suất công việc, kiếm tiền online, học tập chủ động hơn bao giờ hết!

Tham gia NGAY tại: AI AUTOMATION CLUB

Từ dữ liệu, đạo đức nghiên cứu đến quy trình chuẩn kiểm soát rủi ro – MIT AI Retraction là bản đồ sống cho mọi nhà nghiên cứu, doanh nghiệp AI Việt “làm chủ trò chơi” đổi mới trên nền tảng niềm tin, minh bạch và chuyên nghiệp toàn cầu.

#DataIntegrity #AIRetracton #AIResearchEthics #InnovationTrust