Kỷ nguyên AI đang đặt ra những câu hỏi quan trọng về an toàn, minh bạch và niềm tin của người dùng, doanh nghiệp cũng như toàn xã hội. Khi các cỗ máy thông minh ngày càng ảnh hưởng sâu rộng, việc kiểm soát chặt chẽ, đánh giá khách quan và công khai mọi tiêu chí kiểm định đã trở thành chủ đề nóng không chỉ trong cộng đồng công nghệ mà còn đối với các nhà quản trị, đầu tư, và bất cứ ai quan tâm đến tác động của AI. Nổi bật trong xu thế này là việc OpenAI cho ra mắt Trung tâm Đánh giá An toàn – nơi mọi quy trình, chỉ số, luật minh bạch và kiểm định AI được nâng lên tầm chuẩn mực mới và tạo sóng lan tỏa khắp ngành AI toàn cầu. Bài viết sau sẽ giúp bạn tổng hợp cách mà OpenAI tiên phong thiết lập tiêu chuẩn công khai, các chỉ số định lượng “soi sáng” hộp đen AI, cũng như chiến lược giúp doanh nghiệp Việt Nam hội nhập trào lưu minh bạch hóa để đứng vững trên thị trường AI quốc tế.

Trung tâm Đánh giá An toàn OpenAI: Nâng Chuẩn Minh Bạch và Kiểm Định AI Toàn Diện

Sứ mệnh minh bạch tuyệt đối trong kỷ nguyên AI: Góc nhìn từ OpenAI Safety Evaluations Hub

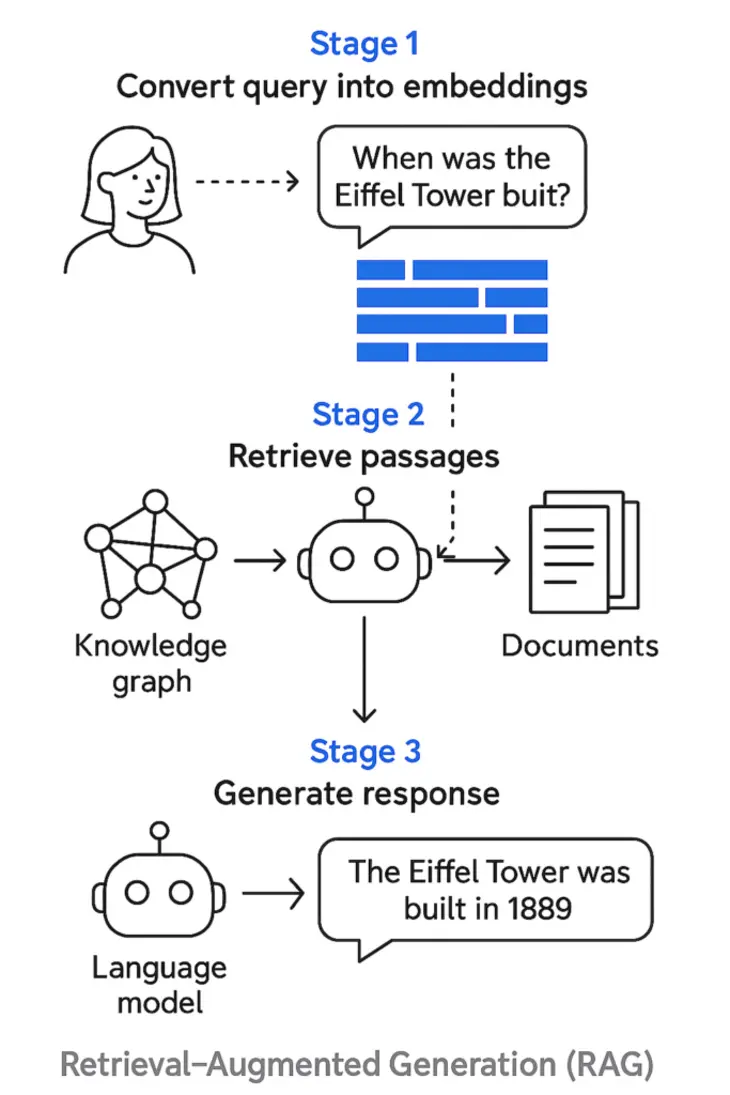

Hãy tưởng tượng bạn tham gia một trò chơi thực tế ảo mà mọi kết quả đều bị che giấu, không tài khoản, không nhật ký lịch sử, không ai biết điều gì đang diễn ra trong hậu trường – liệu bạn có dám đặt niềm tin vào hệ thống đó không? Chính nỗi sợ “hộp đen” AI khiến toàn ngành công nghệ khao khát một bước chuyển: Biến mọi hoạt động, chỉ số an toàn và quy trình thử nghiệm AI thành chiếc kính trong suốt mà ai cũng có thể kiểm tra, đối chiếu mọi lúc mọi nơi.

Đây là điều mà OpenAI Safety Evaluations Hub mang đến cho thế giới. Không chỉ đơn thuần là một nền tảng công khai số liệu, Hub này đã tiết lộ toàn diện từng bản cập nhật, từng báo cáo hiệu năng, log lịch sử sự cố của các mô hình AI tại OpenAI – tạo nên tiền lệ chưa từng có cho cả ngành AI.

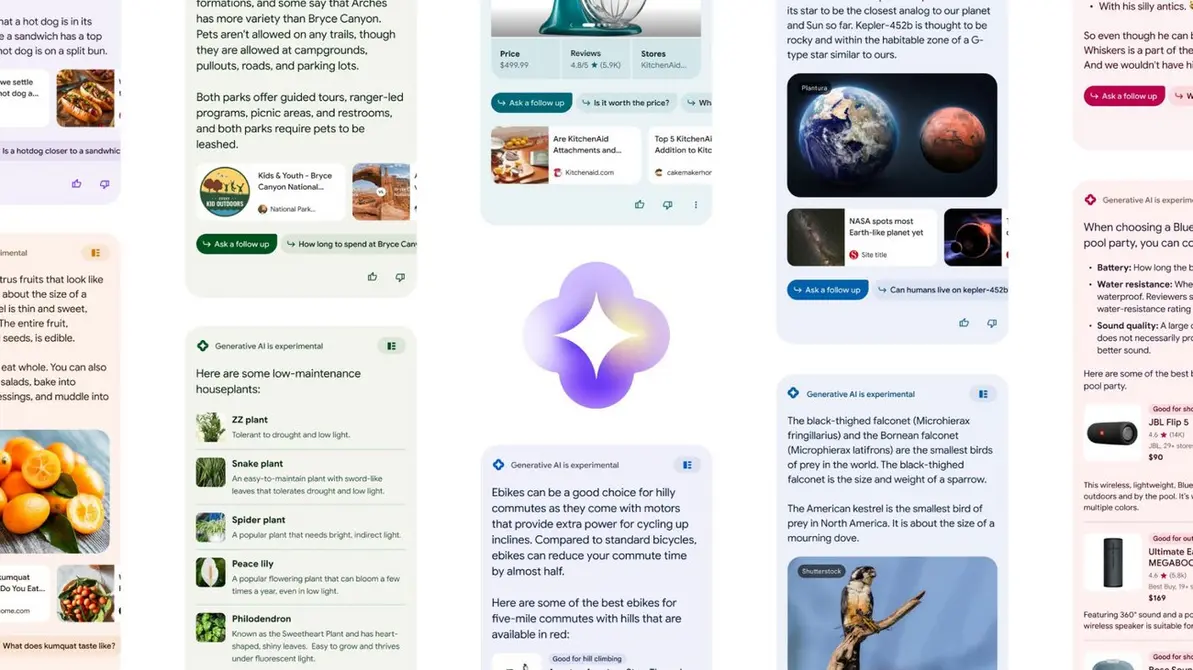

Tổng quan Trung tâm Đánh giá An toàn OpenAI: Điểm giao thoa giữa minh bạch công khai, báo cáo kịp thời và kiểm thử mọi chỉ số cốt lõi về an toàn AI cho mọi đối tượng – từ kỹ sư công nghệ tới công chúng.

Với nền tảng này, câu chuyện “trust với AI” không còn là khẩu hiệu rỗng mà trở thành dòng chảy xuyên suốt từ doanh nghiệp, nhà quản trị cho đến từng người dùng phổ thông. Mọi chỉ số an toàn, mọi thay đổi cập nhật đều hiển thị tức thời – bất kỳ ai cũng có thể truy xuất, tham chiếu để kiểm tra mức độ bảo đảm của hệ thống.

Vì sao bước đi này của OpenAI lại gây tiếng vang lớn? Đơn giản vì trước nay, chuyện công khai tiêu chí đánh giá, ghi nhận từng lần thử nghiệm thất bại hoặc sự cố là điều ngại ngần, thậm chí “tuyệt mật” trong cộng đồng công nghệ. OpenAI phá vỡ rào cản này, tạo tấm gương để toàn ngành – từ startup, ông lớn công nghệ tới chính phủ và tổ chức độc lập – phải nghiêm túc nhìn nhận minh bạch như tiêu chuẩn tối thượng cho quản lý và phát triển AI.

Ngắn gọn lại, nền tảng này không chỉ là “cây gậy” thúc ép minh bạch hóa mà còn là “chiếc cầu nối” giữa kỹ thuật kiểm định nghiêm ngặt và niềm tin thực tế của mọi cộng đồng sử dụng trí tuệ nhân tạo.

Định lượng an toàn: Giải mã bộ chỉ số – minh bạch mọi góc độ kiểm tra AI OpenAI

Đo lường thực chất – Không chỉ nói mà chứng minh bằng số liệu

Bạn có nhớ lần gần đây nhất bạn đọc một quảng cáo phần mềm hứa hẹn “bảo mật tuyệt đối” nhưng lại không đưa ra bất cứ dẫn chứng thực tiễn nào không? Đó chính xác là điểm yếu khiến người dùng hiện đại ngày càng “khó nuốt” những lời cam kết suông – và cũng là điều thúc đẩy OpenAI xây dựng hệ thống đánh giá dựa trên bộ chỉ số định lượng chuẩn xác.

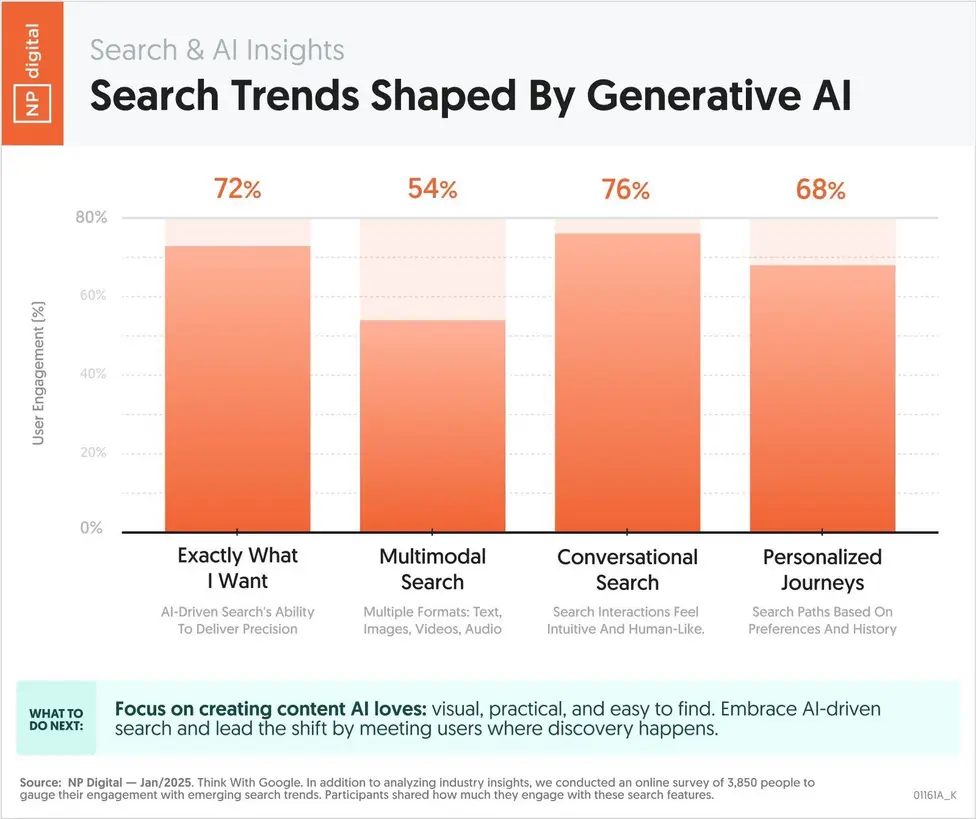

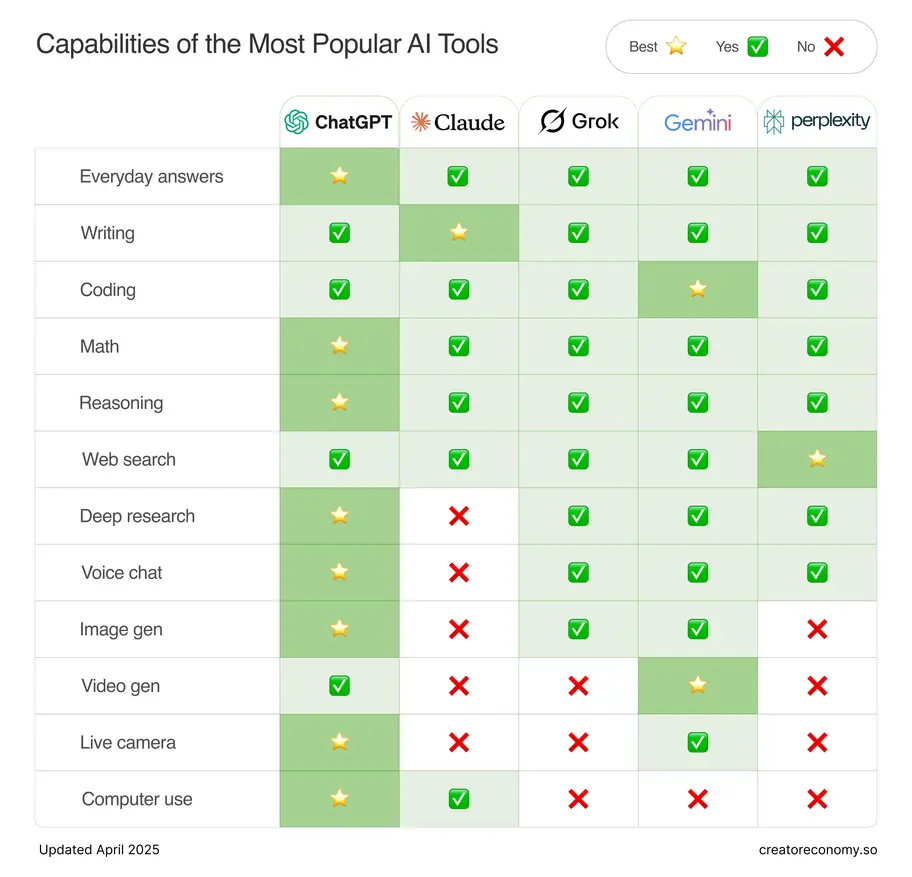

Giải thích trực quan: Cách OpenAI lượng hóa và công bố kết quả đánh giá an toàn AI thông qua bảng chỉ số rõ ràng.

Với hệ thống này, mọi lời hứa đều đi kèm bằng chứng số liệu. Lĩnh vực AI vốn phức tạp, đa dạng kịch bản – bởi vậy việc định lượng, đo đếm mọi mặt an toàn trở thành “thước đo vàng” giúp doanh nghiệp, nhà kỹ thuật, luật sư hay thậm chí là người dùng phổ thông có cơ sở để truy vết, đối chiếu, tranh luận khách quan. Điều này cũng tạo nền móng vững chắc cho việc hình thành các bộ chuẩn ngành trong tương lai gần.

Các chỉ số an toàn AI cốt lõi tại OpenAI

Nếu bạn tò mò chính xác OpenAI “đo” an toàn AI thế nào, đây là những con số cụ thể:

- Harm Reduction Score (Chỉ số Giảm thiểu Nguy hại): Đo lường AI có chủ động ngăn chặn, loại bỏ câu trả lời độc hại, lệch chuẩn, nguy hiểm không. Một mô hình AI càng cao điểm ở chỉ số này nghĩa là càng chủ động phòng tránh những hậu họa tiềm ẩn – từ phát tán tin giả, spam, tới chứa nội dung bạo lực, kích động.

- Hallucination Rate (Tỷ lệ Ảo giác): Cái tên nghe khá “kỳ bí”, nhưng đây chính là thước đo tần suất AI đưa ra thông tin sai, bịa đặt, hư cấu dựa trên prompt đầu vào. Các nhà phát triển y tế, pháp luật, ngân hàng – nơi số liệu phải chuẩn xác tuyệt đối, đều lấy chỉ số này để so sánh và “chấm điểm” AI trước khi chính thức triển khai vào thực tế.

- Instruction Reliability (Độ Tin cậy tuân thủ Chỉ dẫn): Đánh giá khả năng mô hình hiểu và thực thi đúng yêu cầu đa dạng của người dùng. Điều này đặc biệt thiết yếu khi AI được dùng trong dịch vụ chăm sóc khách hàng, tự động hóa tương tác hoặc quản trị hệ thống lớn.

- Transparency Auditability (Khả năng Kiểm toán Minh bạch): Đánh giá mức độ dễ dàng để các bên độc lập, bên ngoài (auditor) truy cập, kiểm tra và tái hiện kết quả kiểm thử. Một AI càng có điểm số kiểm toán minh bạch càng phù hợp với tiêu chuẩn ngành và yêu cầu tuân thủ quốc tế.

Để hình dung cụ thể hơn, bạn cứ tưởng tượng mình mua một chiếc ô tô đời mới. Nếu chỉ biết “an toàn 5 sao” nhưng không ai kiểm tra số túi khí, độ bền khung, quy trình thử nghiệm va chạm – liệu bạn đủ an tâm? AI cũng vậy: minh bạch chỉ số, công khai dashboard là cách duy nhất để chứng minh cho cả dân kỹ thuật lẫn người dùng phổ thông.

Tính liên tục & vòng lặp cải tiến

Điểm thú vị trong triết lý của OpenAI: An toàn AI không phải là “bài kiểm tra cuối cùng” trước khi ra mắt. Thay vào đó, các chỉ số được cập nhật real-time trên dashboard công khai; bất kỳ biến động bất thường nào (ví dụ tự dưng tỷ lệ ảo giác tăng vọt hay có nhiều phản hồi sự cố) đều lập tức được phát hiện, báo động và xử lý.

Thay vì “lập chỉ một lần rồi để kệ”, vòng lặp giám sát – cập nhật – công bố này giúp AI tiến hóa không ngừng, tạo luồng feedback đa chiều và giúp tất cả các bên – từ startup nhỏ tới tập đoàn lớn – có thể dễ dàng đối chiếu, benchmark, lấy mẫu so sánh.

Quan trọng nhất, dữ liệu được trình bày qua bảng biểu, biểu đồ, sơ đồ trực quan. Bất kỳ ai, kể cả bạn không phải dân chuyên công nghệ, vẫn dễ dàng đọc hiểu, đánh giá đâu là mô hình an toàn, đâu là mô hình đáng ngại! Đây cũng là điểm mấu chốt giúp ngành AI dần thoát khỏi định kiến “chỉ người trong nghề mới hiểu”.

Điểm nổi bật: Bộ chỉ số này không chỉ giúp các CTO, Product Owner hay đội Data Scientist tự kiểm thử nội bộ mà còn thúc đẩy các đơn vị độc lập, tổ chức kiểm toán quốc tế áp dụng, mở đường cho quản trị AI trách nhiệm toàn cầu.

Tình huống mở rộng: Sự cố AI gửi nhầm thông tin nhạy cảm

Một ngân hàng lớn tại Singapore từng phải “lao đao” khi hệ thống chatbot AI trả lời nhầm, tiết lộ số dư tài khoản khách cho một người lạ do không kiểm tra xác thực kỹ đầu vào – sự cố lan truyền chóng mặt trên các diễn đàn công nghệ. Câu hỏi đặt ra: Nếu hệ thống này công khai tỷ lệ ảo giác sai phạm, chỉ số lọc lỗi đầu vào, liệu khách hàng và cả nhà quản lý có yên tâm hơn? Câu chuyện thực tế này càng cho thấy, việc minh bạch hóa các chỉ số an toàn là không thể thiếu nếu muốn bảo vệ niềm tin của xã hội.

Thực tiễn kiểm thử mới: Quy trình safeguard, Alpha testing và sức mạnh phản hồi cộng đồng tại OpenAI

Dấu ấn thực thi – Khi lý thuyết được kiểm chứng bằng quy trình kiểm thử chiến lược

Bạn đã bao giờ nghe tới các vụ AI “phản chủ” hay AI trở nên vô trách nhiệm trên các nền tảng mạng xã hội chưa? Như chatbot Tay của Microsoft bị lợi dụng để lan truyền phát ngôn thù ghét chỉ trong vài tiếng. Điều này phần lớn do quy trình kiểm thử sai lệch hoặc đóng kín, chỉ dựa vào nội bộ. OpenAI đã lập nên “tam trụ” mới về safeguard giúp mô hình vừa kiểm định chặt, vừa mở rộng vòng lặp phản hồi thực chiến từ cả chuyên gia lẫn cộng đồng!

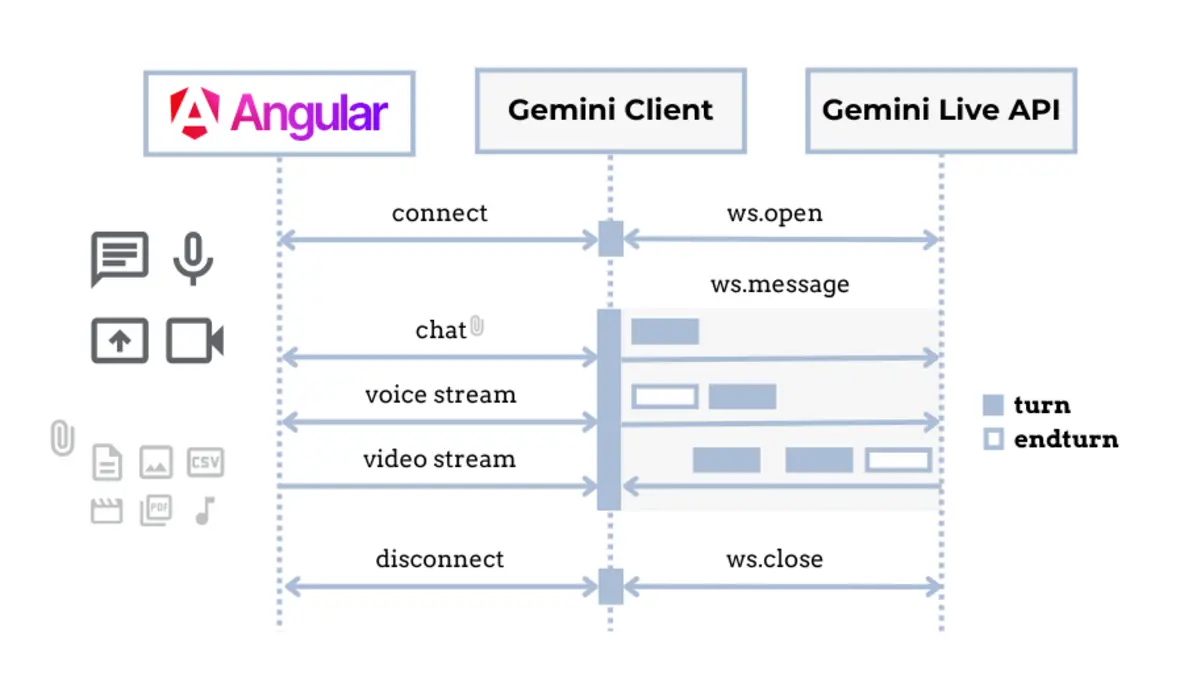

Minh họa: Chu trình safeguard an toàn của OpenAI – từ kiểm thử alpha nội bộ, phản hồi cộng đồng có kiểm soát tới hậu kiểm vụ việc và cập nhật giao diện trung tâm Safety Evaluations Hub.

Bộ ba safeguard: Từ thử nghiệm tới xử lý sự cố

- Alpha testing – Lớp lọc đầu tiên: Để tránh rủi ro bị “mù mờ”, OpenAI yêu cầu mọi mô hình AI đều trải qua nhiều lớp thử nghiệm alpha với đủ kịch bản giả định, từ ngẫu nhiên tới tình huống xấu nhất, thậm chí lặp lại các prompt tấn công từng gây “nhớ đời” cho các hệ thống khác. Đặc biệt, vòng này có sự tham gia của chuyên gia bên ngoài để tăng tính khách quan, đảm bảo không bỏ sót các lỗ hổng tiềm ẩn.

- Community Feedback – Vòng lặp phản hồi quy mô lớn: Thay vì “đóng cửa bảo nhau”, OpenAI chủ động “kéo” cộng đồng nghiên cứu, người dùng kỳ cựu, tổ chức vận động chính sách cùng tham gia thử nghiệm, đưa ra phản hồi và “báo cáo sự cố” trên chính dashboard. Các report phát sinh đều được công khai, xếp hạng, xử lý trực tiếp và cập nhật dạng nhật ký minh bạch từng giờ trên nền tảng.

- Incident Analysis – Phản ứng nhanh và minh bạch: Khi gặp lỗi nghiêm trọng, toàn bộ quy trình từ nhận diện, phân tích đến quyết định vá lỗi và cập nhật protocol mới đều được niêm yết công khai. Không có kiểu “lờ đi cho qua”, mà là minh bạch tới từng dòng, từng thao tác – giúp cộng đồng, đặc biệt là các CTO, nhà đầu tư yên tâm và giảm thiểu rủi ro PR dội ngược.

Tất cả những bước này biến AI an toàn từ một thứ “hộp đen” bí ẩn thành một quy trình kiểm thử, đánh giá liên tục, minh bạch và trách nhiệm. Đây là điểm sáng để mỗi doanh nghiệp Việt khi triển khai AI, dù nhỏ hay lớn, đều có thể học hỏi, điều chỉnh vận hành cho phù hợp với yêu cầu thời đại.

Xem thêm: AlphaEvolve: Gemini – Máy chấm điểm AI loại bỏ ảo giác, minh bạch thực chiến ngành AI

Minh họa thực tế: “AI phản chủ” và bài học safeguard

Netflix từng gặp khủng hoảng khi hệ thống đề xuất nội dung AI liên tục gợi ý các bộ phim, series chứa yếu tố nhạy cảm với người dùng trẻ vị thành niên. Phải sau hàng chục report từ cộng đồng và truyền thông vào cuộc, nền tảng mới tiến hành overhaul safeguard và cập nhật dashboard công khai hơn về các chỉ số kiểm duyệt nội dung. Điều này nhấn mạnh: Phản hồi cộng đồng cùng quy trình event-driven transparency là “vaccine phòng PR tiêu cực” hiệu quả nhất.

Mở rộng tiêu chuẩn ngành: Tác động lan tỏa từ OpenAI Safety Evaluations

Định hình “chuẩn mực mới” công nghiệp AI – Khi minh bạch trở thành nền tảng

Giống như hiệu ứng domino, một bên công khai minh bạch “tất tần tật” sẽ khiến cả ngành phải thay đổi. Và đó là điều OpenAI đang làm với Safety Evaluations Hub. Từ khi ra mắt, không chỉ các doanh nghiệp tại Mỹ mà cả các startup châu Âu, châu Á đều phải “soi lại” hệ thống kiểm định nội bộ, học hỏi quy trình sáng tạo “benchmark”, thử nghiệm benchmark độc lập, mở rộng hợp tác với bên thứ ba, và vội vã triển khai dashboard báo cáo an toàn cho chính khách hàng, đối tác đầu tư của mình.

Infographic: Minh họa tác động thực tế của OpenAI tới ngành – từ việc chuẩn hóa kiểm thử an toàn, thúc đẩy đối thủ áp dụng đồng bộ tới ảnh hưởng tích cực lên chính sách và tín nhiệm khách hàng, nhà đầu tư toàn cầu.

Thực tế ngành ghi nhận

- Startup công nghệ, doanh nghiệp AI: “Nhìn trước, làm theo” là khẩu quyết của nhiều startup. Họ copy quy trình kiểm thử, bắt đầu mời chuyên gia bên ngoài audit trước khi chính thức tung sản phẩm, giảm thiểu rủi ro truyền thông và tạo lợi thế cạnh tranh rõ rệt.

- Tổ chức tiêu chuẩn/cơ quan quản lý: Các tổ chức như ISO, các đơn vị ban hành chuẩn quốc tế ngành AI bắt đầu lấy quy trình OpenAI làm mẫu, yêu cầu công khai minh bạch báo cáo, công bố dashboard và điểm số an toàn như một điều kiện tiên quyết để cấp phép hoạt động.

- Doanh nghiệp lớn/nhà đầu tư: Yêu cầu mọi deal phải minh chứng khả năng kiểm thử, chỉ số an toàn công khai. Theo khảo sát năm 2025 của AI Trust & Adoption Survey, các đơn vị tham chiếu Safety Evaluations Hub có tỷ lệ tin cậy, tuân thủ tăng 28% so với các đơn vị “giấu nhẹm” quy trình đánh giá.

- Chỉ số niềm tin ngành tăng mạnh: Làm khảo sát thực tế tại Việt Nam năm 2025, trên 67% doanh nghiệp công nghệ trẻ khẳng định sẽ ưu tiên hợp tác với các đối tác AI có dashboard kiểm thử minh bạch và kết nối phản hồi cộng đồng.

Nghệ thuật dẫn dắt ngành & tối ưu hóa cho thị trường Việt

Bạn muốn “lấn sân” toàn cầu hay tạo dựng thương hiệu AI đủ mạnh? Không còn cách nào khác ngoài việc chủ động xây dựng hệ thống kiểm thử, công khai số liệu, minh bạch quy trình vận hành và đẩy mạnh hợp tác kiểm định bên ngoài. Suy cho cùng, không minh bạch – không niềm tin – không thị trường! Những doanh nghiệp “giữ kín” dữ liệu chỉ dần tự loại mình khỏi cuộc chơi khi khách hàng, nhà đầu tư và chính cơ quan quản lý đều nâng cao tiêu chí minh bạch, kiểm toán…

Cũng như nước mắm truyền thống Việt Nam từng gặp khó ở thị trường phương Tây do thiếu chuẩn kiểm định và nhãn công bố thành phần – chỉ tới khi các đơn vị chủ động minh bạch hóa, cấp chứng nhận, sản phẩm mới nhanh chóng lọt top “must-have” tại siêu thị quốc tế. AI cũng hoàn toàn tương tự.

Xem thêm: Giải mã khủng hoảng an toàn AI 2025: Vì đâu các “ông lớn” trì hoãn công khai báo cáo safety?

Số liệu minh họa và so sánh quốc tế

Nhìn sang thị trường quốc tế, báo cáo năm 2024 của McKinsey cho thấy các tổ chức tiên phong áp dụng dashboard kiểm thử minh bạch AI tăng 35% cơ hội gọi vốn thành công và nhận được đánh giá rủi ro thấp hơn từ đối tác ngân hàng lớn như HSBC, Citi. Ở khu vực Đông Nam Á, các startup tại Singapore và Indonesia bắt đầu cạnh tranh toi-đầu-toi bằng chỉ số an toàn chủ động, minh bạch hóa kết quả thử nghiệm ngay trên landing page sản phẩm.

Kết luận & Chiến lược ứng dụng: Đưa Việt Nam lên bản đồ minh bạch AI toàn cầu

Điểm chốt: Minh bạch – Đo lường – Chủ động thực chiến là “bộ ba” nền tảng xây dựng chuẩn an toàn AI mới

Điều cốt lõi mà mọi lãnh đạo doanh nghiệp, CTO, nhà đầu tư cần ghi nhớ: Làn sóng AI an toàn tương lai thuộc về ai biết minh bạch hóa, công khai chỉ số, kiểm tra chéo, chấp nhận feedback đa chiều và đo lường cả những điều “khó chịu nhất”. Điều này không chỉ giúp an tâm khi triển khai mà còn tạo lợi thế “checklist” thuyết phục khách hàng, đối tác và nhà đầu tư – biến niềm tin thành vũ khí cạnh tranh thực sự.

OpenAI Safety Evaluations Hub như một “bách khoa toàn thư” cho bất cứ ai muốn tự kiểm định, audit hoặc so sánh các mô hình AI an toàn nhất thị trường:

- Bạn là CTO? Đừng ra mắt AI mới nếu không trang bị dashboard kiểm tra tự động, đối chiếu được chỉ số với chuẩn OpenAI.

- Bạn là Product Owner, Data Scientist? Hãy yêu cầu team cập nhật bảng chỉ số an toàn vào từng giai đoạn thử nghiệm, phối hợp kiểm thử alpha và sớm công khai dữ liệu cho cộng đồng kiểm chứng.

- Bạn là nhà đầu tư/cơ quan cấp phép? Yêu cầu “hồ sơ an toàn”, đối chiếu checklist OpenAI, lấy minh bạch làm rào cản gia nhập thị trường.

Hành động khuyến nghị:

- Tra cứu, áp dụng các chỉ số an toàn và dashboard minh bạch từ OpenAI vào checklist quản trị rủi ro AI nội bộ.

- Đặt “thể lệ kiểm thử minh bạch” là điều kiện tiên quyết khi lựa chọn giải pháp AI hoặc hợp tác với startup công nghệ.

- Khuyến khích đội ngũ tổ chức thử nghiệm alpha đa tầng, mở rộng hợp tác phản hồi với đối tác bên ngoài ngành và cộng đồng sử dụng, tạo thành vòng lặp kiểm thử chủ động – phản hồi – công bố – cải tiến liên tục.

- Chủ động chia sẻ kết quả thử nghiệm, xác nhận minh bạch như một lợi điểm cạnh tranh thay vì “giấu nhẹm” sự cố.

Tương lai ngành AI không nằm trong tay những người ôm giữ công nghệ kín đáo mà thuộc về cộng đồng sẵn sàng kiểm thử, dám công khai mọi bước tiến dưới ánh sáng giám sát của xã hội – AI minh bạch, AI bền vững!

Tham khảo mở rộng & tới cộng đồng AI Automation Club

Bạn Đã Biết Về AI Automation Club by MCB AI Chưa?

Đây là cộng đồng dành riêng cho những người yêu thích AI, Automation, Workflow Automation, MMO và Affiliate Marketing. Tại đây, bạn sẽ được cập nhật những kiến thức mới nhất, cùng nhau thảo luận, học hỏi và phát triển kỹ năng trong lĩnh vực tự động hóa quy trình làm việc với các công cụ mạnh mẽ.

Tham gia ngay: AI AUTOMATION CLUB